Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

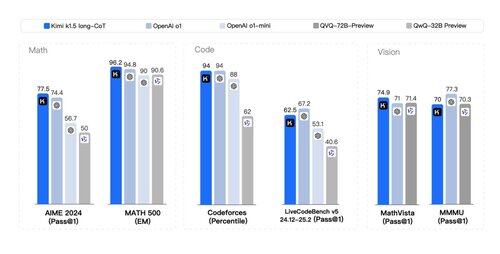

Те, що *другий* папір із безліччю секретів маховика RL і міркувань у стилі *мультимодального* o1 сьогодні не на моїй картці бінго. Документи Kimi's (ще один стартап) і DeepSeek дивовижним чином зійшлися на схожих висновках:

> Немає потреби в складному пошуку по дереву, як MCTS. Просто лінеаризуйте слід думки і зробіть старе добре авторегресивне передбачення;

> Немає необхідності в ціннісних функціях, які вимагають ще однієї дорогої копії моделі;

> Немає необхідності в щільному моделюванні винагороди. Максимально покладайтеся на правду, кінцевий результат.

Відмінності:

> DeepSeek робить підхід AlphaZero - чисто bootstrap через RL без людського введення, тобто "холодний старт". Кімі використовує підхід AlphaGo-Master: запалює SFT для прогріву за допомогою швидко розроблених трас CoT.

> Ваги DeepSeek мають ліцензію MIT (лідерство думок!); У Kimi поки що немає релізу моделі.

> Kimi демонструє сильну мультимодальну продуктивність (!) на таких бенчмарках, як MathVista, що вимагає візуального розуміння геометрії, тестів IQ тощо.

> документі Kimi є НАБАГАТО більше деталей про дизайн системи: інфраструктура RL, гібридний кластер, пісочниця коду, стратегії паралелізму; та деталі навчання: довгий контекст, стиснення CoT, навчальна програма, стратегія вибірки, генерація тестових випадків тощо.

Бадьорі читання у святковий день!

Посилання на білу книгу:

300,44K

Найкращі

Рейтинг

Вибране