Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

RT pour aider Simon à sensibiliser sur les attaques par injection de prompt dans les LLM.

On a un peu l'impression que c'est le far west de l'informatique des débuts, avec des virus informatiques (aujourd'hui = des prompts malveillants cachés dans les données/outils web), et des défenses pas encore bien développées (antivirus, ou un paradigme de sécurité kernel/user space beaucoup plus développé où, par exemple, un agent se voit attribuer des types d'actions très spécifiques au lieu de la capacité d'exécuter des scripts bash arbitraires).

Je suis partagé parce que je veux être un adoptant précoce des agents LLM dans mon informatique personnelle, mais le far west des possibilités me retient.

16 juin 2025

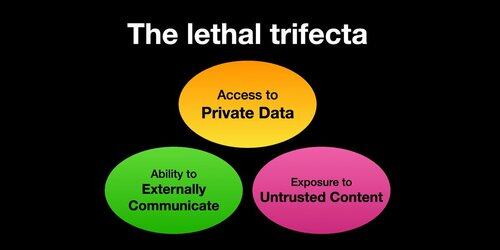

Si vous utilisez des "agents IA" (LLMs qui appellent des outils), vous devez être conscient du Trifecta Mortel.

Chaque fois que vous combinez l'accès à des données privées avec l'exposition à du contenu non fiable et la capacité de communiquer à l'extérieur, un attaquant peut tromper le système pour voler vos données !

Je devrais préciser que le risque est le plus élevé si vous exécutez des agents LLM locaux (par exemple, Cursor, Claude Code, etc.).

Si vous parlez simplement à un LLM sur un site web (par exemple, ChatGPT), le risque est beaucoup plus faible *à moins* que vous ne commenciez à activer les Connecteurs. Par exemple, je viens de voir que ChatGPT ajoute le support MCP. Cela se combinera particulièrement mal avec toutes les fonctionnalités de mémoire récemment ajoutées - par exemple, imaginez que ChatGPT dise tout ce qu'il sait sur vous à un attaquant sur Internet juste parce que vous avez coché la mauvaise case dans les paramètres des Connecteurs.

386K

Meilleurs

Classement

Favoris