Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

RT para ayudar a Simon a crear conciencia sobre los ataques de inyección rápida en los LLM.

Se siente un poco como el salvaje oeste de los primeros computadores, con virus informáticos (ahora = avisos maliciosos escondidos en datos/herramientas web) y defensas no bien desarrolladas (antivirus, o un paradigma de seguridad del kernel/espacio de usuario mucho más desarrollado donde, por ejemplo, a un agente se le dan tipos de acción muy específicos en lugar de la capacidad de ejecutar scripts bash arbitrarios).

Conflictivo porque quiero ser uno de los primeros en adoptar agentes de LLM en mi informática personal, pero el salvaje oeste de las posibilidades me está frenando.

16 jun 2025

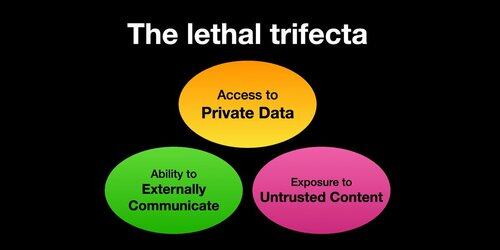

Si utilizas "agentes de IA" (LLM que llaman a herramientas) debes conocer la Trifecta Letal

Cada vez que combina el acceso a datos privados con la exposición a contenido no confiable y la capacidad de comunicarse externamente, un atacante puede engañar al sistema para que robe sus datos.

Debo aclarar que el riesgo es mayor si está ejecutando agentes LLM locales (por ejemplo, Cursor, Claude Code, etc.).

Si solo estás hablando con un LLM en un sitio web (por ejemplo, ChatGPT), el riesgo es mucho menor *a menos* que comiences a activar los conectores. Por ejemplo, acabo de ver que ChatGPT está agregando soporte para MCP. Esto combinará especialmente mal con todas las funciones de memoria añadidas recientemente, por ejemplo, imagina que ChatGPT cuenta todo lo que sabe sobre ti a algún atacante en Internet sólo porque has marcado la casilla incorrecta en la configuración de los conectores.

385.98K

Populares

Ranking

Favoritas