Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

RT, aby pomóc Simonowi zwiększyć świadomość na temat ataków typu prompt injection w LLM.

Czuje się to trochę jak dziki zachód wczesnego komputerowania, z wirusami komputerowymi (teraz = złośliwe prompty ukryte w danych/narzędziach internetowych) i słabo rozwiniętymi obronami (antywirus, lub znacznie bardziej rozwinięty paradygmat bezpieczeństwa jądra/procesu użytkownika, gdzie np. agentowi przydzielane są bardzo specyficzne typy działań zamiast możliwości uruchamiania dowolnych skryptów bash).

Czuję się skonfliktowany, ponieważ chcę być wczesnym użytkownikiem agentów LLM w moim osobistym komputerze, ale dziki zachód możliwości mnie powstrzymuje.

16 cze 2025

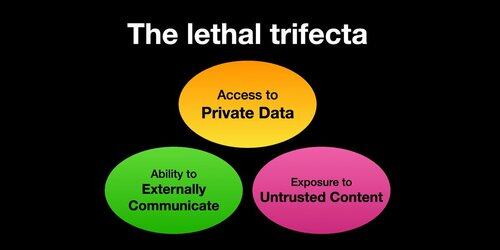

Jeśli używasz "agentów AI" (LLM, które wywołują narzędzia), musisz być świadomy Lethal Trifecta.

Za każdym razem, gdy łączysz dostęp do danych prywatnych z narażeniem na nieznane treści oraz możliwością komunikacji zewnętrznej, atakujący może oszukać system, aby ukraść twoje dane!

Powinienem wyjaśnić, że ryzyko jest najwyższe, jeśli uruchamiasz lokalne agenty LLM (np. Cursor, Claude Code itp.).

Jeśli po prostu rozmawiasz z LLM na stronie internetowej (np. ChatGPT), ryzyko jest znacznie niższe *chyba że* zaczniesz włączać Connectory. Na przykład właśnie zauważyłem, że ChatGPT dodaje wsparcie dla MCP. To połączenie będzie szczególnie źle działać z wszystkimi niedawno dodanymi funkcjami pamięci - np. wyobraź sobie, że ChatGPT mówi wszystko, co wie o tobie, jakiemuś atakującemu w internecie, tylko dlatego, że zaznaczyłeś niewłaściwe pole w ustawieniach Connectorów.

386K

Najlepsze

Ranking

Ulubione