Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jason Wei

Výzkumný pracovník v oblasti umělé inteligence @openai

Jason Wei repostoval/a

📣 S nadšením se s vámi můžeme podělit o naši reálnou studii klinického kopilota LLM, spolupráce mezi @OpenAI a @PendaHealth.

Během 39 849 živých návštěv pacientů zaznamenali kliničtí lékaři s umělou inteligencí 16% relativní snížení diagnostických chyb a 13% snížení chyb v léčbě ve srovnání s pacienty bez ní. 🧵

258,12K

Jason Wei repostoval/a

Toto je moje přednáška z před 2 měsíců na @Cornell

"Jak mohu zvýšit svůj výkon?" Jedna přirozená odpověď je: "Budu pracovat ještě pár hodin." Delší práce vám může pomoci, ale nakonec narazíte na fyzický limit.

Lepší otázka zní: "Jak mohu zvýšit svůj výstup, aniž bych tolik zvýšil vstup?" To je pákový efekt.

Slovo "pákový efekt" slýcháme tak často, že jeho důsledky je snadné přehlédnout. Moje osobní oblíbená kategorizace pákového efektu je podle Naval Ravikant: lidská práce, kapitál a kód / média. Každý z nich poháněl velké vlny tvorby bohatství v historii.

Jakmile se však zdroj pákového efektu stane populárním (vzpomeňte si na kanály YouTube dnes oproti deseti letům), konkurence stlačuje marži. Takže když se objeví nová páka, je to vzácná šance na nadměrné zisky.

V této přednášce popisuji umělou inteligenci jako nově vznikající páku. Agent umělé inteligence kombinuje pákový efekt pracovní síly (funguje za vás a je bez povolení) s využitím kódu (můžete jej zkopírovat a vložit).

Je klišé říkat, že umělá inteligence vytvoří obrovské bohatství. Použití této pákové čočky nám však umožňuje interpretovat hlučný zpravodajský cyklus umělé inteligence konzistentním způsobem a odhalit skutečné příležitosti.

Díky @unsojo za hostování!

402,4K

Nový příspěvek na blogu o asymetrii verifikace a "zákonu verifikátora":

Asymetrie verifikace – myšlenka, že některé úlohy je mnohem snazší ověřit než vyřešit – se stává důležitou myšlenkou, protože máme RL, který konečně funguje obecně.

Skvělými příklady asymetrie ověřování jsou věci jako sudoku, psaní kódu pro webové stránky jako instagram a problémy BrowseComp (trvá ~100 webových stránek, než najdete odpověď, ale snadno ji ověříte, jakmile odpověď máte).

Jiné úlohy mají téměř symetrii ověřování, jako je sečtení dvou 900místných čísel nebo některé skripty pro zpracování dat. Jiné úkoly je však mnohem snazší navrhnout pro ně proveditelná řešení, než je ověřit (např. ověření faktů v dlouhé eseji nebo stanovení nové diety jako "jezte pouze bizony").

Důležitou věcí, kterou je třeba pochopit o asymetrii ověřování, je, že asymetrii můžete zlepšit tím, že si předem uděláte nějakou práci. Například pokud máte klíč odpovědí na matematický problém nebo pokud máte testovací případy pro problém Leetcode. To značně zvyšuje množinu problémů s žádoucí verifikační asymetrií.

"Zákon ověřovatele" říká, že snadnost trénování umělé inteligence k vyřešení úkolu je úměrná tomu, jak ověřitelný úkol je. Všechny úkoly, které je možné řešit a snadno ověřit, budou řešeny umělou inteligencí. Schopnost vycvičit umělou inteligenci k řešení úkolu je úměrná tomu, zda má úkol následující vlastnosti:

1. Objektivní pravda: všichni se shodnou na tom, jaká jsou dobrá řešení

2. Rychlé ověření: jakékoli dané řešení lze ověřit během několika sekund

3. Škálovatelné ověření: lze ověřit mnoho řešení současně

4. Nízký šum: ověření je co nejtěsněji spojeno s kvalitou řešení

5. Průběžná odměna: je snadné seřadit dobrotu mnoha řešení pro jeden problém

Jedním ze zřejmých příkladů zákona ověřovatele je skutečnost, že většinu benchmarků navržených v AI lze snadno ověřit a dosud byla vyřešena. Všimněte si, že prakticky všechny populární benchmarky za posledních deset let vyhovovaly kritériím #1-4; Benchmarky, které nesplňují kritéria #1-4, by se těžko staly populárními.

Proč je ověřitelnost tak důležitá? Množství učení v AI, ke kterému dochází, je maximalizováno, když jsou splněna výše uvedená kritéria; Můžete udělat spoustu kroků se sklonem, kde každý krok má velký signál. Rychlost iterací je rozhodující – je to důvod, proč je pokrok v digitálním světě mnohem rychlejší než pokrok ve fyzickém světě.

AlphaEvolve od Googlu je jedním z největších příkladů využití asymetrie ověřování. Zaměřuje se na nastavení, která splňují všechna výše uvedená kritéria, a vedla k řadě pokroků v matematice a dalších oblastech. Na rozdíl od toho, co jsme dělali v oblasti umělé inteligence v posledních dvou desetiletích, je to nové paradigma v tom, že všechny problémy jsou optimalizovány v prostředí, kde je vlaková sada ekvivalentní testovací sadě.

Asymetrie ověřování je všudypřítomná a je vzrušující uvažovat o světě zubaté inteligence, kde se vyřeší vše, co můžeme změřit.

298,77K

Přímo Banger, četl jsem okamžitě

Kevin Lu10. 7. 00:01

Proč byste měli přestat pracovat na výzkumu RL a místo toho pracovat na produktu //

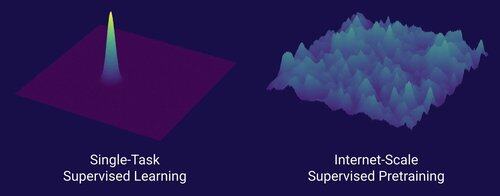

Technologií, která odemkla velký posun v oblasti umělé inteligence, je internet, nikoli transformátory

Myslím, že je dobře známo, že data jsou v umělé inteligenci to nejdůležitější, a také to, že výzkumníci se rozhodli, že na nich stejně nebudou pracovat. ... Co to znamená pracovat s daty (škálovatelným způsobem)?

Internet poskytoval bohatý zdroj hojných dat, který byl rozmanitý, poskytoval přirozené učební osnovy, reprezentoval kompetence, na kterých lidem skutečně záleží, a byl ekonomicky životaschopnou technologií pro nasazení ve velkém měřítku – stal se dokonalým doplňkem k predikci dalšího tokenu a byl prvotní polévkou pro umělou inteligenci.

Bez transformátorů by se mohlo prosadit libovolné množství přístupů, pravděpodobně bychom mohli mít CNN nebo stavové modely na úrovni GPT-4.5. Od GPT-4 však nedošlo k dramatickému zlepšení základních modelů. Modely uvažování jsou skvělé v úzkých doménách, ale ne tak velký skok, jako byl GPT-4 v březnu 2023 (před více než 2 lety...)

S posilovaným učením máme něco skvělého, ale hluboce se obávám, že budeme opakovat chyby z minulosti (éra RL 2015-2020) a dělat RL výzkum, na kterém nezáleží.

Stejně jako byl internet duálním předtréninkem pod dohledem, jaký bude duální RL, který povede k masivnímu pokroku jako GPT-1 -> GPT-4? Myslím, že to vypadá jako společný design výzkumu a produktu.

18,62K

Zatím nemáme umělou inteligenci, která by se sama vylepšovala, a až se nám to podaří, změní to pravidla hry. S větší moudrostí ve srovnání s dny GPT-4 je zřejmé, že nepůjde o "rychlý start", ale spíše o extrémně postupný v průběhu mnoha let, pravděpodobně desetiletí.

První věc, kterou je třeba vědět, je, že sebezdokonalování, tj. trénování modelů samých, není binární. Vezměme si scénář tréninku GPT-5 GPT-6, což by bylo neuvěřitelné. Přešel by GPT-5 najednou z neschopnosti trénovat GPT-6 na extrémně zdatný trénink? Rozhodně ne. První tréninkové běhy GPT-6 by byly pravděpodobně extrémně neefektivní z hlediska času a výpočtů ve srovnání s lidskými výzkumníky. A teprve po mnoha zkouškách by GPT-5 skutečně dokázal trénovat GPT-6 lépe než lidé.

Za druhé, i kdyby se model dokázal sám trénovat, nezlepšil by se náhle ve všech oblastech. Existuje gradient obtížnosti v tom, jak těžké je zlepšit se v různých oblastech. Například sebezdokonalování možná zpočátku funguje pouze na doménách, které už víme, jak snadno opravit po tréninku, jako jsou základní halucinace nebo styl. Další by byla matematika a kódování, které vyžaduje více práce, ale zavedlo metody pro zlepšování modelů. A pak si v extrému můžete představit, že existují úkoly, které jsou velmi těžké pro sebezdokonalování. Například schopnost mluvit tlingitštinou, indiánským jazykem, kterým mluví ~500 lidí. Pro model bude velmi těžké se v mluvení tlingitštinou zdokonalit, protože zatím nemáme způsoby, jak řešit jazyky s nízkými zdroji, jako je tento, kromě sběru více dat, což by zabralo čas. Takže kvůli gradientu obtížnosti sebezdokonalování se to nestane všechno najednou.

A konečně, možná je to kontroverzní, ale v konečném důsledku je pokrok ve vědě brzděn experimenty v reálném světě. Někteří se mohou domnívat, že přečtení všech prací z biologie nám řekne lék na rakovinu, nebo že přečtení všech prací ML a zvládnutí veškeré matematiky vám umožní dokonale trénovat GPT-10. Pokud by tomu tak bylo, pak by lidé, kteří přečetli nejvíce článků a studovali nejvíce teorie, byli nejlepšími výzkumníky v oblasti umělé inteligence. Ve skutečnosti se však stalo to, že umělou inteligenci (a mnoho dalších oborů) ovládli nemilosrdní empirickí výzkumníci, což odráží, jak velký pokrok je založen na experimentech v reálném světě, nikoli na hrubé inteligenci. Takže můj názor je, že i když super chytrý agent může navrhnout 2x nebo dokonce 5x lepší experimenty než naši nejlepší lidští výzkumníci, na konci dne musí stále čekat na spuštění experimentů, což by bylo zrychlení, ale ne rychlý start.

Stručně řečeno, existuje mnoho překážek pokroku, nejen hrubá inteligence nebo systém sebezdokonalování. Umělá inteligence vyřeší mnoho domén, ale každá doména má své vlastní tempo pokroku. A dokonce i ta nejvyšší inteligence bude stále vyžadovat experimenty v reálném světě. Takže to bude zrychlení a ne rychlý vzlet, děkuji vám za přečtení mého tirády

339,86K

Řekl bych, že jsme nepochybně na AGI, kdy AI dokáže vytvořit skutečného, živého jednorožce. A ne, nemyslím tím společnost za 1 miliardu dolarů, vy pitomci, myslím doslova růžového koně se spirálovitým rohem. Vzor vědeckého pokroku v genetickém inženýrství a buněčném programování. Věc dětských snů. Troufám si říci, že se to stane během našich životů

84,28K

Top

Hodnocení

Oblíbené

Co je v trendu on-chain

Populární na X

Nejvyšší finanční vklady v poslední době

Nejpozoruhodnější