Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jason Wei

Peneliti AI @openai

Jason Wei memposting ulang

📣 Senang untuk membagikan studi dunia nyata kami tentang kopilot klinis LLM, kolaborasi antara @OpenAI dan @PendaHealth.

Dari 39.849 kunjungan pasien langsung, dokter dengan AI memiliki pengurangan relatif 16% dalam kesalahan diagnostik dan pengurangan 13% dalam kesalahan pengobatan dibandingkan dengan mereka yang tidak. 🧵

258,12K

Jason Wei memposting ulang

Ini adalah kuliah saya dari 2 bulan yang lalu di @Cornell

"Bagaimana cara meningkatkan output saya?" Salah satu jawaban alami adalah "Saya hanya akan bekerja beberapa jam lagi." Bekerja lebih lama dapat membantu, tetapi pada akhirnya Anda mencapai batas fisik.

Pertanyaan yang lebih baik adalah, "Bagaimana cara meningkatkan output saya tanpa meningkatkan input sebanyak itu?" Itu adalah leverage.

Kita sering mendengar "leverage" sehingga implikasinya mudah diabaikan. Kategorisasi leverage favorit pribadi saya adalah oleh Naval Ravikant: tenaga kerja manusia, modal, dan kode / media. Masing-masing telah mendorong gelombang besar penciptaan kekayaan dalam sejarah.

Namun, begitu sumber leverage menjadi populer (pikirkan saluran YouTube saat ini versus sepuluh tahun yang lalu) persaingan memampatkan margin. Jadi ketika leverage baru muncul, itu adalah kesempatan langka untuk keuntungan yang sangat besar.

Dalam pembicaraan ini, saya menggambarkan AI sebagai pengaruh yang muncul. Agen AI memadukan leverage tenaga kerja (itu bekerja untuk Anda dan tanpa izin) dengan leverage kode (Anda dapat menyalin dan menempelkannya).

Adalah klise untuk mengatakan AI akan menciptakan kekayaan besar. Tetapi menggunakan lensa leverage ini memungkinkan kita menafsirkan siklus berita AI yang berisik dengan cara yang konsisten dan menemukan peluang nyata.

Terima kasih @unsojo telah menjamu saya!

402,41K

Posting blog baru tentang asimetri verifikasi dan "hukum verifikasi":

Asimetri verifikasi–gagasan bahwa beberapa tugas jauh lebih mudah untuk diverifikasi daripada dipecahkan–menjadi ide penting karena kita memiliki RL yang akhirnya berfungsi secara umum.

Contoh asimetri verifikasi yang bagus adalah hal-hal seperti teka-teki sudoku, menulis kode untuk situs web seperti instagram, dan masalah BrowseComp (membutuhkan ~100 situs web untuk menemukan jawabannya, tetapi mudah diverifikasi setelah Anda memiliki jawabannya).

Tugas lain memiliki verifikasi yang hampir simetri, seperti menjumlahkan dua angka 900 digit atau beberapa skrip pemrosesan data. Namun tugas-tugas lain jauh lebih mudah untuk mengusulkan solusi yang layak daripada memverifikasinya (misalnya, memeriksa fakta esai panjang atau menyatakan diet baru seperti "hanya makan bison").

Hal penting yang perlu dipahami tentang asimetri verifikasi adalah Anda dapat memperbaiki asimetri dengan melakukan beberapa pekerjaan sebelumnya. Misalnya, jika Anda memiliki kunci jawaban untuk soal matematika atau jika Anda memiliki kasus pengujian untuk soal Leetcode. Ini sangat meningkatkan serangkaian masalah dengan asimetri verifikasi yang diinginkan.

"Hukum verifikasi" menyatakan bahwa kemudahan melatih AI untuk menyelesaikan tugas sebanding dengan seberapa dapat diverifikasi tugas tersebut. Semua tugas yang mungkin diselesaikan dan mudah diverifikasi akan diselesaikan oleh AI. Kemampuan untuk melatih AI untuk menyelesaikan tugas sebanding dengan apakah tugas tersebut memiliki properti berikut:

1. Kebenaran objektif: semua orang setuju apa itu solusi yang baik

2. Cepat untuk memverifikasi: solusi apa pun dapat diverifikasi dalam beberapa detik

3. Dapat diskalakan untuk memverifikasi: banyak solusi dapat diverifikasi secara bersamaan

4. Kebisingan rendah: verifikasi berkorelasi erat dengan kualitas solusi

5. Hadiah berkelanjutan: mudah untuk memberi peringkat kebaikan banyak solusi untuk satu masalah

Salah satu instansiasi yang jelas dari hukum verifikator adalah fakta bahwa sebagian besar tolok ukur yang diusulkan dalam AI mudah diverifikasi dan sejauh ini telah diselesaikan. Perhatikan bahwa hampir semua tolok ukur populer dalam sepuluh tahun terakhir sesuai dengan kriteria #1-4; Tolok ukur yang tidak memenuhi kriteria #1-4 akan kesulitan untuk menjadi populer.

Mengapa verifikasi begitu penting? Jumlah pembelajaran dalam AI yang terjadi dimaksimalkan ketika kriteria di atas terpenuhi; Anda dapat mengambil banyak langkah gradien di mana setiap langkah memiliki banyak sinyal. Kecepatan iterasi sangat penting—itulah alasan mengapa kemajuan di dunia digital jauh lebih cepat daripada kemajuan di dunia fisik.

AlphaEvolve dari Google adalah salah satu contoh terbaik dalam memanfaatkan asimetri verifikasi. Ini berfokus pada pengaturan yang sesuai dengan semua kriteria di atas, dan telah mengarah pada sejumlah kemajuan dalam matematika dan bidang lainnya. Berbeda dari apa yang telah kami lakukan dalam AI selama dua dekade terakhir, ini adalah paradigma baru di mana semua masalah dioptimalkan dalam pengaturan di mana set kereta setara dengan set pengujian.

Asimetri verifikasi ada di mana-mana dan sangat menarik untuk mempertimbangkan dunia kecerdasan bergerigi di mana apa pun yang dapat kita ukur akan diselesaikan.

298,77K

straight banger, saya langsung membaca

Kevin Lu10 Jul, 00.01

Mengapa Anda harus berhenti mengerjakan penelitian RL dan sebagai gantinya mengerjakan produk //

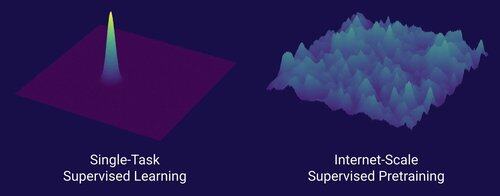

Teknologi yang membuka pergeseran penskalaan besar dalam AI adalah internet, bukan transformator

Saya pikir sudah diketahui bahwa data adalah hal terpenting dalam AI, dan juga bahwa para peneliti memilih untuk tidak mengerjakannya. ... Apa artinya mengerjakan data (dengan cara yang dapat diskalakan)?

Internet menyediakan sumber data yang kaya berlimpah, yang beragam, menyediakan kurikulum alami, mewakili kompetensi yang benar-benar dipedulikan orang, dan merupakan teknologi yang layak secara ekonomi untuk diterapkan dalam skala besar - itu menjadi pelengkap sempurna untuk prediksi token berikutnya dan merupakan sup primordial bagi AI untuk lepas landas.

Tanpa transformator, sejumlah pendekatan bisa lepas landas, kita mungkin bisa memiliki CNN atau model ruang negara pada tingkat GPT-4.5. Tetapi belum ada peningkatan dramatis dalam model dasar sejak GPT-4. Model penalaran sangat bagus dalam domain sempit, tetapi tidak lompatan besar seperti GPT-4 pada Maret 2023 (lebih dari 2 tahun yang lalu...)

Kami memiliki sesuatu yang hebat dengan pembelajaran penguatan, tetapi ketakutan saya yang mendalam adalah bahwa kami akan mengulangi kesalahan masa lalu (RL era 2015-2020) dan melakukan penelitian RL yang tidak masalah.

Dengan cara internet adalah ganda dari prapelatihan yang diawasi, apa yang akan menjadi ganda RL yang akan mengarah pada kemajuan besar-besaran seperti GPT-1 -> GPT-4? Saya pikir itu terlihat seperti desain bersama produk penelitian.

18,63K

Kami belum memiliki AI yang meningkatkan diri, dan ketika kami melakukannya, itu akan menjadi pengubah permainan. Dengan lebih banyak kebijaksanaan sekarang dibandingkan dengan GPT-4 hari, jelas bahwa itu tidak akan menjadi "lepas landas cepat", melainkan sangat bertahap selama bertahun-tahun, mungkin satu dekade.

Hal pertama yang perlu diketahui adalah bahwa perbaikan diri, yaitu, model melatih diri mereka sendiri, tidak biner. Pertimbangkan skenario GPT-5 melatih GPT-6, yang akan luar biasa. Akankah GPT-5 tiba-tiba berubah dari tidak dapat melatih GPT-6 sama sekali menjadi melatihnya dengan sangat mahir? Tentu saja tidak. Pelatihan GPT-6 pertama mungkin akan sangat tidak efisien dalam waktu dan komputasi dibandingkan dengan peneliti manusia. Dan hanya setelah banyak uji coba, GPT-5 benar-benar dapat melatih GPT-6 lebih baik daripada manusia.

Kedua, bahkan jika sebuah model dapat melatih dirinya sendiri, itu tidak akan tiba-tiba menjadi lebih baik di semua domain. Ada gradien kesulitan dalam betapa sulitnya untuk meningkatkan diri dalam berbagai domain. Misalnya, mungkin perbaikan diri hanya bekerja pada awalnya pada domain yang sudah kita ketahui cara memperbaikinya dengan mudah dalam pasca-pelatihan, seperti halusinasi dasar atau gaya. Berikutnya adalah matematika dan pengkodean, yang membutuhkan lebih banyak pekerjaan tetapi telah menetapkan metode untuk meningkatkan model. Dan kemudian secara ekstrim, Anda dapat membayangkan bahwa ada beberapa tugas yang sangat sulit untuk perbaikan diri. Misalnya, kemampuan berbicara Tlingit, bahasa asli Amerika yang dituturkan oleh ~500 orang. Akan sangat sulit bagi model untuk meningkatkan diri dalam berbicara Tlingit karena kita belum memiliki cara untuk memecahkan bahasa sumber daya rendah seperti ini kecuali mengumpulkan lebih banyak data yang akan memakan waktu. Jadi karena gradien kesulitan-perbaikan-diri, itu tidak akan terjadi sekaligus.

Akhirnya, mungkin ini kontroversial tetapi pada akhirnya kemajuan dalam sains terhambat oleh eksperimen dunia nyata. Beberapa orang mungkin percaya bahwa membaca semua makalah biologi akan memberi tahu kita obat untuk kanker, atau bahwa membaca semua makalah ML dan menguasai semua matematika akan memungkinkan Anda untuk melatih GPT-10 dengan sempurna. Jika ini masalahnya, maka orang-orang yang membaca makalah paling banyak dan mempelajari teori paling banyak akan menjadi peneliti AI terbaik. Tetapi apa yang sebenarnya terjadi adalah bahwa AI (dan banyak bidang lainnya) menjadi didominasi oleh peneliti empiris yang kejam, yang mencerminkan seberapa banyak kemajuan didasarkan pada eksperimen dunia nyata daripada kecerdasan mentah. Jadi maksud saya adalah, meskipun agen super pintar mungkin merancang eksperimen 2x atau bahkan 5x lebih baik daripada peneliti manusia terbaik kita, pada akhirnya mereka masih harus menunggu eksperimen berjalan, yang akan menjadi akselerasi tetapi bukan lepas landas yang cepat.

Singkatnya, ada banyak hambatan untuk kemajuan, bukan hanya kecerdasan mentah atau sistem perbaikan diri. AI akan memecahkan banyak domain tetapi setiap domain memiliki tingkat kemajuannya sendiri. Dan bahkan kecerdasan tertinggi pun masih membutuhkan eksperimen di dunia nyata. Jadi ini akan menjadi akselerasi dan bukan lepas landas cepat, terima kasih telah membaca kata-kata kasar saya

339,86K

Hal yang paling bermanfaat tentang bekerja di kantor pada malam hari dan akhir pekan bukanlah pekerjaan sebenarnya yang Anda selesaikan, tetapi percakapan spontan dengan orang lain yang selalu bekerja. Mereka adalah orang-orang yang cenderung melakukan hal-hal besar dan akan menjadi teman Anda yang paling sukses

74,5K

Saya akan mengatakan bahwa kita tidak diragukan lagi berada di AGI ketika AI dapat menciptakan unicorn yang nyata dan hidup. Dan tidak, yang saya maksud bukan perusahaan $ 1 miliar yang Anda kutu buku, maksud saya kuda merah muda literal dengan tanduk spiral. Contoh kemajuan ilmiah dalam rekayasa genetika dan pemrograman sel. Hal-hal impian masa kecil. Berani saya katakan itu akan terjadi dalam hidup kita

84,28K

Teratas

Peringkat

Favorit

Trending onchain

Trending di X

Pendanaan teratas terbaru

Paling terkenal