Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jason Wei

AI-forskare @openai

Jason Wei delade inlägget

📣 Vi är glada över att dela vår verkliga studie av en LLM-klinisk copilot, ett samarbete mellan @OpenAI och @PendaHealth.

Över 39 849 patientbesök i realtid hade läkare med AI en relativ minskning av diagnostiska fel med 16 % och en minskning med 13 % av behandlingsfel jämfört med de utan. 🧵

258,12K

Jason Wei delade inlägget

Det här är min föreläsning för 2 månader sedan på @Cornell

"Hur ökar jag min produktion?" Ett naturligt svar är: "Jag ska bara jobba några timmar till." Att arbeta längre kan hjälpa, men så småningom når du en fysisk gräns.

En bättre fråga är: "Hur ökar jag min produktion utan att öka inmatningen lika mycket?" Det är hävstångseffekt.

Vi hör "hävstång" så ofta att dess innebörd är lätt att förbise. Min personliga favoritkategorisering av hävstång är av Naval Ravikant: mänskligt arbete, kapital och kod / media. Var och en har drivit stora vågor av välståndsskapande i historien.

Men när en hävstångskälla blir populär (tänk YouTube-kanaler idag jämfört med för tio år sedan) komprimerar konkurrensen marginalen. Så när en ny hävstång dyker upp är det en sällsynt chans till överdimensionerade vinster.

I det här föredraget beskriver jag AI som den framväxande hävstångseffekten. En AI-agent blandar arbetskraft (den fungerar för dig och är utan behörighet) med kodhävstång (du kan kopiera och klistra in den).

Det är klyschigt att säga att AI kommer att skapa enorma rikedomar. Men genom att använda denna hävstångslins kan vi tolka den bullriga AI-nyhetscykeln på ett konsekvent sätt och upptäcka de verkliga möjligheterna.

Tack @unsojo för att du tog emot mig!

402,41K

Nytt blogginlägg om asymmetri i verifiering och "verifierarens lag":

Asymmetri för verifiering – idén att vissa uppgifter är mycket lättare att verifiera än att lösa – blir en viktig idé eftersom vi har RL som äntligen fungerar generellt.

Bra exempel på asymmetri i verifiering är saker som sudoku-pussel, att skriva koden för en webbplats som instagram och BrowseComp-problem (tar ~100 webbplatser att hitta svaret, men lätt att verifiera när du väl har svaret).

Andra uppgifter har nästan symmetri i verifieringen, som att summera två 900-siffriga tal eller vissa databehandlingsskript. Men andra uppgifter är mycket lättare att föreslå genomförbara lösningar för än att verifiera dem (t.ex. faktagranskning av en lång uppsats eller att ange en ny diet som "ät bara bison").

En viktig sak att förstå om asymmetri i verifiering är att du kan förbättra asymmetrin genom att göra lite arbete i förväg. Till exempel om du har svarsnyckeln till ett matematiskt problem eller om du har testfall för ett Leetcode-problem. Detta ökar kraftigt uppsättningen problem med önskvärd verifieringsasymmetri.

"Verifierarens lag" säger att hur lätt det är att träna AI att lösa en uppgift är proportionell mot hur verifierbar uppgiften är. Alla uppgifter som är möjliga att lösa och lätta att verifiera kommer att lösas av AI. Möjligheten att träna AI för att lösa en uppgift är proportionell mot om uppgiften har följande egenskaper:

1. Objektiv sanning: alla är överens om vad bra lösningar är

2. Snabbt att verifiera: alla givna lösningar kan verifieras på några sekunder

3. Skalbar att verifiera: många lösningar kan verifieras samtidigt

4. Lågt brus: verifieringen är så nära korrelerad till lösningens kvalitet som möjligt

5. Kontinuerlig belöning: det är lätt att rangordna godheten hos många lösningar på ett enda problem

En uppenbar exemplifiering av verifierarens lag är det faktum att de flesta riktmärken som föreslås i AI är lätta att verifiera och hittills har lösts. Lägg märke till att praktiskt taget alla populära riktmärken under de senaste tio åren passar in på kriterium #1-4; Riktmärken som inte uppfyller kriterium #1-4 skulle kämpa för att bli populära.

Varför är verifierbarhet så viktigt? Mängden lärande i AI som sker maximeras när ovanstående kriterier är uppfyllda; Du kan ta många gradientsteg där varje steg har mycket signal. Iterationshastigheten är avgörande – det är anledningen till att framstegen i den digitala världen har varit så mycket snabbare än framstegen i den fysiska världen.

AlphaEvolve från Google är ett av de bästa exemplen på att utnyttja asymmetri i verifieringen. Den fokuserar på upplägg som passar alla ovanstående kriterier och har lett till ett antal framsteg inom matematik och andra områden. Till skillnad från vad vi har gjort inom AI under de senaste två decennierna är det ett nytt paradigm i och med att alla problem optimeras i en miljö där tågsetet är likvärdigt med testsetet.

Asymmetri för verifiering finns överallt och det är spännande att tänka på en värld av ojämn intelligens där allt vi kan mäta kommer att lösas.

298,78K

Straight banger, jag läste genast

Kevin Lu10 juli 00:01

Varför du bör sluta arbeta med RL-forskning och istället arbeta med produkt //

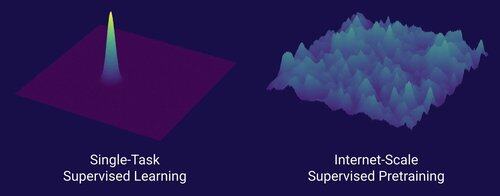

Tekniken som låste upp det stora skalningsskiftet inom AI är internet, inte transformatorer

Jag tror att det är välkänt att data är det viktigaste inom AI, och att forskare väljer att inte arbeta med det ändå. ... Vad innebär det att arbeta med data (på ett skalbart sätt)?

Internet tillhandahöll en rik källa till rikligt med data, som var mångsidigt, gav en naturlig läroplan, representerade de kompetenser som människor faktiskt bryr sig om och var en ekonomiskt lönsam teknik att distribuera i stor skala – det blev det perfekta komplementet till nästa token-förutsägelse och var den ursprungliga soppan för AI att ta fart.

Utan transformatorer hade hur många tillvägagångssätt som helst kunnat ta fart, vi skulle förmodligen ha haft CNN eller statliga rymdmodeller på GPT-4.5-nivå. Men det har inte skett någon dramatisk förbättring av basmodellerna sedan GPT-4. Resonemangsmodeller är bra inom smala domäner, men inte ett lika stort steg som GPT-4 var i mars 2023 (för över 2 år sedan...)

Vi har något bra med reinforcement learning, men min djupa rädsla är att vi kommer att upprepa misstagen från det förflutna (2015-2020 era RL) och göra RL-forskning som inte spelar någon roll.

På det sätt som internet var dubbeln av övervakad förträning, vad kommer att vara dubbeln av RL som kommer att leda till ett massivt framsteg som GPT-1 -> GPT-4? Jag tycker att det ser ut som forskning-produkt-co-design.

18,64K

Normala människors dejtingråd: Gift dig inte tidigt om du växer och förändras mycket varje år

AI-kompis (@YiTayML): Du är som ett neuralt nät mitt i träningen och förlusten förbättras fortfarande. Det är bättre att träna på konvergens i stället för att ta en tidig ögonblicksbild av kontrollpunkten

185,81K

Vi har inte AI som förbättrar sig själv ännu, och när vi gör det kommer det att vara en gamechanger. Med mer visdom nu jämfört med GPT-4-dagarna är det uppenbart att det inte kommer att bli en "snabb start", utan snarare extremt gradvis under många år, förmodligen ett decennium.

Det första du bör veta är att självförbättring, det vill säga modeller som tränar sig själva, inte är binär. Tänk på scenariot med GPT-5-träning GPT-6, vilket skulle vara otroligt. Skulle GPT-5 plötsligt gå från att inte kunna träna GPT-6 alls till att träna den extremt skickligt? Definitivt inte. De första GPT-6-träningskörningarna skulle förmodligen vara extremt ineffektiva i tid och beräkning jämfört med mänskliga forskare. Och först efter många försök skulle GPT-5 faktiskt kunna träna GPT-6 bättre än människor.

För det andra, även om en modell kunde träna sig själv, skulle den inte plötsligt bli bättre på alla domäner. Det finns en gradient av svårigheter i hur svårt det är att förbättra sig själv inom olika områden. Till exempel kanske självförbättring bara fungerar till en början på domäner som vi redan vet hur man enkelt kan åtgärda efter träning, som grundläggande hallucinationer eller stil. Nästa skulle vara matematik och kodning, som kräver mer arbete men har etablerade metoder för att förbättra modeller. Och i extremfallet kan du föreställa dig att det finns vissa uppgifter som är mycket svåra för självförbättring. Till exempel förmågan att tala Tlingit, ett indianspråk som talas av ~500 personer. Det kommer att vara mycket svårt för modellen att själv förbättra sig på att tala Tlingit eftersom vi ännu inte har några sätt att lösa lågresursspråk som detta förutom att samla in mer data, vilket skulle ta tid. Så på grund av gradienten av svårighet att förbättra sig själv kommer allt inte att hända på en gång.

Slutligen kanske detta är kontroversiellt, men i slutändan är framsteg inom vetenskapen flaskhalsar av verkliga experiment. Vissa kanske tror att om man läser alla biologiartiklar skulle man få reda på botemedlet mot cancer, eller att man genom att läsa alla ML-artiklar och behärska all matematik skulle kunna träna GPT-10 perfekt. Om så vore fallet skulle de personer som läser flest artiklar och studerar mest teori vara de bästa AI-forskarna. Men vad som verkligen hände var att AI (och många andra områden) kom att domineras av hänsynslöst empiriska forskare, vilket speglar hur mycket framsteg som bygger på verkliga experiment snarare än rå intelligens. Så min poäng är att även om en supersmart agent kan designa 2x eller till och med 5x bättre experiment än våra bästa mänskliga forskare, måste de i slutet av dagen fortfarande vänta på att experimenten ska köras, vilket skulle vara en acceleration men inte en snabb start.

Sammanfattningsvis finns det många flaskhalsar för framsteg, inte bara rå intelligens eller ett självförbättringssystem. AI kommer att lösa många domäner, men varje domän har sin egen utvecklingstakt. Och även den högsta intelligensen kommer fortfarande att kräva experiment i den verkliga världen. Så det kommer att bli en acceleration och inte en snabb start, tack för att du läste min rant

339,86K

Jag skulle säga att vi utan tvekan befinner oss vid AGI när AI kan skapa en riktig, levande enhörning. Och nej, jag menar inte ett företag på 1 miljard dollar, ni nördar, jag menar en bokstavlig rosa häst med ett spiralhorn. En förebild för vetenskapliga framsteg inom genteknik och cellprogrammering. Som en barndomsdröm. Vågar jag säga att det kommer att hända under vår livstid

84,28K

Topp

Rankning

Favoriter

Trendande på kedjan

Trendande på X

Senaste toppfinansieringarna

Mest anmärkningsvärda