Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jason Wei

Pesquisador de IA @openai

Jason Wei republicou

📣 Estamos entusiasmados em compartilhar nosso estudo do mundo real sobre um copiloto clínico LLM, uma colaboração entre @OpenAI e @PendaHealth.

Em 39.849 visitas de pacientes ao vivo, os clínicos com IA tiveram uma redução relativa de 16% nos erros de diagnóstico e uma redução de 13% nos erros de tratamento em comparação com aqueles sem. 🧵

296,98K

Jason Wei republicou

Esta é a minha palestra de há 2 meses na @Cornell

"Como posso aumentar a minha produção?" Uma resposta natural é "Vou apenas trabalhar algumas horas a mais." Trabalhar mais pode ajudar, mas eventualmente você atinge um limite físico.

Uma pergunta melhor é: "Como posso aumentar a minha produção sem aumentar tanto o input?" Isso é alavancagem.

Ouvimos "alavancagem" com tanta frequência que a sua implicação é fácil de ignorar. A minha categorização favorita de alavancagem é a de Naval Ravikant: trabalho humano, capital e código / mídia. Cada um deles impulsionou grandes ondas de criação de riqueza na história.

No entanto, uma vez que uma fonte de alavancagem se torna popular (pense nos canais do YouTube hoje em dia em comparação com há dez anos), a concorrência comprime a margem. Portanto, quando uma nova alavancagem aparece, é uma rara oportunidade para ganhos desproporcionais.

Nesta palestra, descrevo a IA como essa alavancagem emergente. Um agente de IA combina alavancagem de trabalho (ele faz trabalho para você e é sem permissão) com alavancagem de código (você pode copiar e colar).

É um clichê dizer que a IA criará uma riqueza massiva. Mas usar essa lente de alavancagem nos permite interpretar o ciclo de notícias barulhento da IA de uma maneira consistente e identificar as verdadeiras oportunidades.

Obrigado @unsojo por me receber!

402,42K

Novo post no blog sobre a assimetria da verificação e a "lei do verificador":

A assimetria da verificação – a ideia de que algumas tarefas são muito mais fáceis de verificar do que de resolver – está a tornar-se uma ideia importante à medida que temos RL que finalmente funciona de forma geral.

Ótimos exemplos de assimetria da verificação são coisas como quebra-cabeças de sudoku, escrever o código para um site como o instagram, e problemas de BrowseComp (leva ~100 sites para encontrar a resposta, mas é fácil de verificar uma vez que se tem a resposta).

Outras tarefas têm uma quase simetria de verificação, como somar dois números de 900 dígitos ou alguns scripts de processamento de dados. No entanto, outras tarefas são muito mais fáceis de propor soluções viáveis do que de as verificar (por exemplo, verificar um longo ensaio ou afirmar uma nova dieta como "comer apenas bisão").

Uma coisa importante a entender sobre a assimetria da verificação é que se pode melhorar a assimetria fazendo algum trabalho previamente. Por exemplo, se você tiver a chave de resposta para um problema de matemática ou se tiver casos de teste para um problema do Leetcode. Isso aumenta muito o conjunto de problemas com uma desejável assimetria de verificação.

A "lei do verificador" afirma que a facilidade de treinar IA para resolver uma tarefa é proporcional à facilidade de verificação da tarefa. Todas as tarefas que são possíveis de resolver e fáceis de verificar serão resolvidas pela IA. A capacidade de treinar IA para resolver uma tarefa é proporcional a se a tarefa possui as seguintes propriedades:

1. Verdade objetiva: todos concordam sobre quais são boas soluções

2. Rápido de verificar: qualquer solução dada pode ser verificada em poucos segundos

3. Escalável para verificar: muitas soluções podem ser verificadas simultaneamente

4. Baixo ruído: a verificação está o mais correlacionada possível à qualidade da solução

5. Recompensa contínua: é fácil classificar a qualidade de muitas soluções para um único problema

Uma instância óbvia da lei do verificador é o fato de que a maioria dos benchmarks propostos em IA são fáceis de verificar e até agora foram resolvidos. Note que praticamente todos os benchmarks populares nos últimos dez anos se encaixam nos critérios #1-4; benchmarks que não atendem aos critérios #1-4 teriam dificuldades em se tornar populares.

Por que a verificabilidade é tão importante? A quantidade de aprendizado em IA que ocorre é maximizada quando os critérios acima são satisfeitos; você pode dar muitos passos de gradiente onde cada passo tem muito sinal. A velocidade de iteração é crítica – é a razão pela qual o progresso no mundo digital tem sido muito mais rápido do que o progresso no mundo físico.

AlphaEvolve do Google é um dos maiores exemplos de aproveitamento da assimetria da verificação. Foca em configurações que atendem a todos os critérios acima e levou a uma série de avanços em matemática e outras áreas. Diferente do que temos feito em IA nas últimas duas décadas, é um novo paradigma em que todos os problemas são otimizados em um ambiente onde o conjunto de treino é equivalente ao conjunto de teste.

A assimetria da verificação está em toda parte e é emocionante considerar um mundo de inteligência irregular onde tudo o que podemos medir será resolvido.

298,81K

música incrível, li imediatamente

Kevin Lu10/07, 00:01

Por que você deve parar de trabalhar em pesquisa de RL e, em vez disso, trabalhar em produtos //

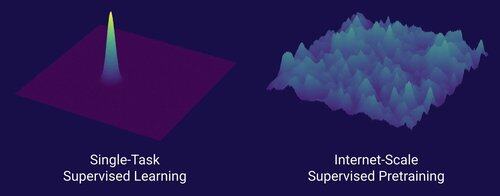

A tecnologia que desbloqueou a grande mudança de escala na IA é a internet, não os transformers

Acho que é bem conhecido que os dados são a coisa mais importante na IA, e também que os pesquisadores escolhem não trabalhar nisso de qualquer maneira. ... O que significa trabalhar com dados (de uma maneira escalável)?

A internet forneceu uma rica fonte de dados abundantes, que eram diversos, ofereciam um currículo natural, representavam as competências que as pessoas realmente se importam e eram uma tecnologia economicamente viável para implantar em escala -- tornou-se o complemento perfeito para a previsão do próximo token e foi a sopa primordial para a IA decolar.

Sem transformers, qualquer número de abordagens poderia ter decolado, provavelmente poderíamos ter CNNs ou modelos de espaço de estado no nível do GPT-4.5. Mas não houve uma melhoria dramática nos modelos base desde o GPT-4. Modelos de raciocínio são ótimos em domínios restritos, mas não são um salto tão grande quanto o GPT-4 foi em março de 2023 (há mais de 2 anos...)

Temos algo ótimo com aprendizado por reforço, mas meu profundo medo é que repetiremos os erros do passado (era de RL de 2015-2020) e faremos pesquisa de RL que não importa.

Da mesma forma que a internet foi o dual do pré-treinamento supervisionado, qual será o dual do RL que levará a um avanço massivo como GPT-1 -> GPT-4? Acho que parece pesquisa-design de produto co-desenhado.

18,66K

Conselho de namoro para pessoas normais: Não se case cedo se você está crescendo e mudando muito a cada ano

Amigo AI (@YiTayML): Você é como uma rede neural no meio do treinamento e a perda ainda está melhorando. É melhor treinar até a convergência em vez de tirar uma captura de checkpoint antecipada.

185,84K

Ainda não temos IA que se auto-melhora, e quando tivermos, será uma mudança de jogo. Com mais sabedoria agora em comparação com os dias do GPT-4, é óbvio que não será uma "decolagem rápida", mas sim extremamente gradual ao longo de muitos anos, provavelmente uma década.

A primeira coisa a saber é que a auto-melhoria, ou seja, modelos que se treinam a si mesmos, não é binária. Considere o cenário em que o GPT-5 treina o GPT-6, o que seria incrível. O GPT-5 de repente passaria de não conseguir treinar o GPT-6 de forma alguma para treiná-lo extremamente proficientemente? Definitivamente não. As primeiras execuções de treinamento do GPT-6 provavelmente seriam extremamente ineficientes em termos de tempo e computação em comparação com pesquisadores humanos. E só após muitas tentativas, o GPT-5 realmente seria capaz de treinar o GPT-6 melhor do que os humanos.

Em segundo lugar, mesmo que um modelo pudesse treinar a si mesmo, não melhoraria de repente em todos os domínios. Existe um gradiente de dificuldade em quão difícil é melhorar a si mesmo em vários domínios. Por exemplo, talvez a auto-melhoria funcione apenas inicialmente em domínios que já sabemos como corrigir facilmente após o treinamento, como alucinações básicas ou estilo. O próximo seria matemática e programação, que exigem mais trabalho, mas têm métodos estabelecidos para melhorar modelos. E então, no extremo, você pode imaginar que há algumas tarefas que são muito difíceis para a auto-melhoria. Por exemplo, a capacidade de falar Tlingit, uma língua nativa americana falada por cerca de 500 pessoas. Será muito difícil para o modelo se auto-melhorar em falar Tlingit, pois ainda não temos maneiras de resolver línguas de baixo recurso como esta, exceto coletando mais dados, o que levaria tempo. Portanto, devido ao gradiente de dificuldade da auto-melhoria, isso não acontecerá tudo de uma vez.

Finalmente, talvez isso seja controverso, mas, em última análise, o progresso na ciência é limitado por experimentos do mundo real. Alguns podem acreditar que ler todos os artigos de biologia nos diria a cura para o câncer, ou que ler todos os artigos de ML e dominar toda a matemática permitiria treinar o GPT-10 perfeitamente. Se esse fosse o caso, então as pessoas que lessem mais artigos e estudassem mais teoria seriam os melhores pesquisadores de IA. Mas o que realmente aconteceu é que a IA (e muitos outros campos) se tornou dominada por pesquisadores empíricos implacáveis, o que reflete o quanto o progresso é baseado em experimentos do mundo real, em vez de inteligência bruta. Portanto, meu ponto é que, embora um agente super inteligente possa projetar experimentos 2x ou até 5x melhores do que nossos melhores pesquisadores humanos, no final do dia, eles ainda têm que esperar os experimentos serem realizados, o que seria uma aceleração, mas não uma decolagem rápida.

Em resumo, existem muitos gargalos para o progresso, não apenas inteligência bruta ou um sistema de auto-melhoria. A IA resolverá muitos domínios, mas cada domínio tem sua própria taxa de progresso. E mesmo a mais alta inteligência ainda exigirá experimentos no mundo real. Portanto, será uma aceleração e não uma decolagem rápida, obrigado por ler meu desabafo.

339,9K

A coisa mais gratificante de trabalhar no escritório à noite e nos fins de semana não é o trabalho que você realmente realiza, mas as conversas espontâneas com outras pessoas que estão sempre trabalhando. Elas são as pessoas que tendem a fazer grandes coisas e se tornarão seus amigos mais bem-sucedidos.

74,54K

Eu diria que estamos indubitavelmente na AGI quando a IA puder criar um unicórnio real e vivo. E não, não me refiro a uma empresa de $1B, seus nerds, quero dizer um cavalo rosa literal com um chifre espiralado. Um paradigma do avanço científico em engenharia genética e programação celular. O material dos sonhos de infância. Ousaria dizer que isso acontecerá em nossas vidas.

84,32K

Top

Classificação

Favoritos

Tendências on-chain

Popular no X

Principais financiamentos atuais

Mais notável