热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

Jason Wei

AI 研究员 @openai

Jason Wei 已转发

这是我两个月前在@Cornell的讲座

“我如何提高我的产出?”一个自然的答案是“我只需多工作几个小时。”工作时间更长确实有帮助,但最终你会达到一个身体极限。

一个更好的问题是,“我如何在不大幅增加投入的情况下提高我的产出?”这就是杠杆。

我们听到“杠杆”这个词太多,以至于它的含义很容易被忽视。我个人最喜欢的杠杆分类是Naval Ravikant的:人力劳动、资本和代码/媒体。每一种都在历史上推动了重大的财富创造浪潮。

然而,一旦某个杠杆来源变得流行(想想今天的YouTube频道与十年前的对比),竞争就会压缩利润空间。因此,当出现新的杠杆时,这是获得超额收益的难得机会。

在这次演讲中,我将AI描述为那种新兴的杠杆。一个AI代理结合了劳动杠杆(它为你工作且无需许可)和代码杠杆(你可以复制和粘贴它)。

说AI将创造巨大的财富是陈词滥调。但使用这种杠杆视角可以让我们以一致的方式解读嘈杂的AI新闻周期,并发现真正的机会。

感谢@unsojo的邀请!

402.4K

关于验证的不对称性和“验证者法则”的新博客文章:

验证的不对称性——某些任务的验证要比解决更容易的想法——随着我们有了最终普遍有效的强化学习,正变得越来越重要。

验证不对称性的好例子包括数独谜题、为像 Instagram 这样的网站编写代码,以及 BrowseComp 问题(需要大约 100 个网站来找到答案,但一旦有了答案就很容易验证)。

其他任务的验证几乎是对称的,比如对两个 900 位数字求和或一些数据处理脚本。还有一些任务提出可行解决方案要比验证它们容易得多(例如,核实一篇长文章的事实或提出一种新的饮食方式,如“只吃野牛”)。

理解验证不对称性的重要一点是,通过提前做一些工作可以改善这种不对称性。例如,如果你有数学问题的答案钥匙,或者如果你有 Leetcode 问题的测试用例。这大大增加了具有理想验证不对称性的问题集。

“验证者法则”指出,训练 AI 解决任务的难易程度与任务的可验证性成正比。所有可以解决且易于验证的任务都将被 AI 解决。训练 AI 解决任务的能力与任务是否具有以下特性成正比:

1. 客观真理:每个人都同意什么是好的解决方案

2. 快速验证:任何给定的解决方案可以在几秒钟内验证

3. 可扩展验证:可以同时验证多个解决方案

4. 低噪声:验证与解决方案质量的相关性尽可能紧密

5. 连续奖励:很容易对单个问题的多个解决方案的优劣进行排名

验证者法则的一个明显实例是,AI 中提出的大多数基准测试都易于验证,并且迄今为止已被解决。注意,过去十年几乎所有流行的基准测试都符合标准 #1-4;不符合标准 #1-4 的基准测试将难以流行。

为什么可验证性如此重要?当上述标准得到满足时,AI 中的学习量达到最大;你可以进行很多梯度步骤,每一步都有大量信号。迭代速度至关重要——这就是数字世界的进步比物理世界的进步快得多的原因。

谷歌的 AlphaEvolve 是利用验证不对称性的最佳例子之一。它专注于符合上述所有标准的设置,并在数学和其他领域取得了一系列进展。与我们在过去二十年中在 AI 中所做的不同,它是一种新范式,即所有问题都在训练集等于测试集的环境中进行优化。

验证不对称性无处不在,考虑一个我们可以测量的世界的锯齿状智能是令人兴奋的。

298.74K

直接就是个好歌,我立刻就读了

Kevin Lu7月10日 00:01

为什么你应该停止从事强化学习研究,而是专注于产品 //

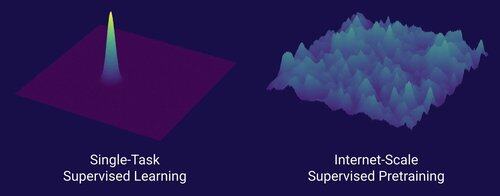

解锁人工智能大规模转变的技术是互联网,而不是变压器

我认为大家都知道数据是人工智能中最重要的东西,而且研究人员选择不去研究它……在可扩展的方式上,研究数据意味着什么?

互联网提供了丰富的、丰富的数据来源,这些数据多样,提供了自然的课程,代表了人们真正关心的能力,并且是一种经济上可行的技术,可以大规模部署——它成为了下一个标记预测的完美补充,并且是人工智能起飞的原始汤。

没有变压器,任何数量的方法都可能起飞,我们可能会有CNN或状态空间模型达到GPT-4.5的水平。但自从GPT-4以来,基础模型并没有显著改善。推理模型在狭窄领域表现出色,但并没有像2023年3月的GPT-4那样取得巨大的飞跃(已经超过两年了……)

我们在强化学习方面有一些伟大的东西,但我深深担心我们会重蹈过去的覆辙(2015-2020年期间的强化学习),进行无关紧要的强化学习研究。

就像互联网是监督预训练的对偶,什么将是强化学习的对偶,能够带来像GPT-1到GPT-4那样的巨大进步?我认为这看起来像是研究-产品共同设计。

18.6K

我们还没有自我改进的人工智能,当我们拥有时,它将是一个游戏规则的改变者。与GPT-4时代相比,现在的智慧更多,很明显这不会是一个“快速起飞”,而是会在许多年内极其渐进,可能需要十年。

首先要知道的是,自我改进,即模型自我训练,并不是二元的。考虑GPT-5训练GPT-6的场景,这将是不可思议的。GPT-5会突然从完全无法训练GPT-6变成非常熟练地训练它吗?绝对不会。第一次GPT-6的训练运行可能在时间和计算上与人类研究人员相比极其低效。只有经过多次尝试,GPT-5才能实际比人类更好地训练GPT-6。

其次,即使一个模型能够自我训练,它也不会突然在所有领域变得更好。在各个领域自我改进的难度是有梯度的。例如,也许自我改进一开始只在我们已经知道如何轻松修复的后训练领域有效,比如基本的幻觉或风格。接下来是数学和编码,这需要更多的工作,但有已建立的方法来改进模型。然后在极端情况下,你可以想象有些任务对于自我改进来说是非常困难的。例如,讲Tlingit语的能力,这是一种由约500人讲的美洲土著语言。模型在自我改进讲Tlingit语方面会非常困难,因为我们还没有解决这种低资源语言的方法,除了收集更多数据,这需要时间。因此,由于自我改进的难度梯度,这一切不会一下子发生。

最后,也许这有争议,但科学的进步最终是受到现实世界实验的瓶颈限制的。有些人可能认为阅读所有生物学论文会告诉我们癌症的治疗方法,或者阅读所有机器学习论文并掌握所有数学将使你能够完美地训练GPT-10。如果真是这样,那么阅读最多论文和研究最多理论的人将是最好的人工智能研究人员。但实际上发生的情况是,人工智能(以及许多其他领域)被无情的经验研究人员主导,这反映了进步在多大程度上基于现实世界的实验,而不是单纯的智力。因此,我的观点是,尽管一个超级聪明的代理可能设计出比我们最优秀的人类研究人员好2倍甚至5倍的实验,但最终他们仍然必须等待实验的进行,这将是加速,但不是快速起飞。

总之,进步有许多瓶颈,不仅仅是原始智力或自我改进系统。人工智能将解决许多领域,但每个领域都有其自己的进展速度。即使是最高的智力仍然需要现实世界中的实验。因此,这将是一个加速,而不是快速起飞,感谢你阅读我的发言。

339.84K

热门

排行

收藏

链上热点

X 热门榜

近期融资

最受认可