Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Je suis tout à fait d'accord : 1. La collaboration parallèle entre plusieurs agents intelligents n'est pas aussi stable qu'un fil d'exécution unique ; 2. RAG n'est pas fiable, c'est même moins bon que la recherche traditionnelle ; 3. Plus il y a d'instructions dans le prompt, moins le modèle sait comment choisir.

—— Traduction originale ci-dessous ——

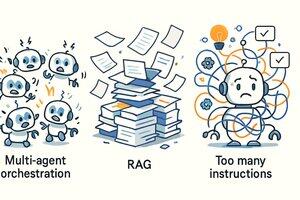

Dans la construction d'agents intelligents (AI Agent), notre équipe @Cline a identifié trois "virus de pensée". Ce que l'on appelle un "virus de pensée", ce sont ces idées séduisantes qui semblent brillantes mais qui, en pratique, ne fonctionnent pas du tout.

Ces trois virus sont :

* Collaboration multi-agents (Multi-Agent Orchestration)

* Génération augmentée par recherche (RAG)

* Plus il y a d'instructions = meilleur est le résultat

Voyons cela de plus près !

1. Collaboration multi-agents

Cette scène de film de science-fiction — "agents de soutien, agents de logistique, agents d'analyse, agents de commandement" envoyant une grande foule d'agents, puis rassemblant les résultats — semble vraiment cool. Mais la réalité est que la plupart des travaux utiles des agents sont en fil d'exécution unique.

Les processus de collaboration complexes apportent rarement une véritable valeur, mais créent souvent de la confusion. Il faut savoir que faire fonctionner le modèle de manière stable en fil d'exécution unique est déjà assez difficile, sans parler de la gestion de ces logiques de collaboration parallèles. Cela augmente non seulement la complexité de la mise en œuvre, mais rend également le processus de compréhension et de décision du modèle exceptionnellement complexe.

2. Utiliser RAG pour construire des agents

RAG, c'est-à-dire la génération augmentée par recherche (Retrieval Augmented Generation), est aussi un virus de pensée. En théorie, cela semble très puissant, mais en pratique, surtout dans le contexte des agents, parfois même une commande de recherche de texte basique comme GREP est plus utile.

Pourquoi l'aura de RAG s'est-elle estompée dans les flux de travail des agents ? Parce que les informations récupérées sont souvent des fragments épars, incapables de permettre au modèle de former une "compréhension" cohérente et utile.

Une meilleure méthode est presque toujours : laisser le modèle énumérer les fichiers, effectuer une recherche de manière similaire à grep, puis ouvrir et lire l'ensemble du fichier (comme un humain). L'équipe @Cline a commencé à faire cela très tôt, et nous avons ensuite vu que @Amp — Research Preview et @Cursor se sont également tournés vers cette méthode plus pragmatique.

3. Plus d'instructions = meilleur résultat

Il existe une idée reçue largement répandue : entasser de plus en plus d'"instructions" dans le prompt système (system prompt) rendra le modèle plus intelligent. C'est complètement faux.

Surcharger le prompt ne fera que confondre le modèle, car plus d'instructions entraînent souvent des conflits de suggestions et une surcharge d'informations.

Le résultat est que vous devez, comme dans un jeu de "tapette à taupes", continuellement corriger les comportements étranges du modèle, au lieu d'obtenir des résultats réellement utiles. Pour la plupart des modèles de pointe d'aujourd'hui, la meilleure méthode est de ne pas entraver leur chemin, plutôt que de crier à côté en essayant de les diriger vers une certaine direction. Chérissez chaque mot (ou Token) que vous utilisez.

En résumé, ces trois idées sont toutes très séduisantes. Si vous ne traitez pas avec l'IA tous les jours, vous pourriez penser qu'elles ont toutes du sens — mais ce n'est pas le cas. Bien sûr, avec l'amélioration des capacités des modèles sous-jacents, notre perception de ces méthodes pourrait également changer à l'avenir.

20 août, 01:00

En construisant des agents IA @cline, nous avons identifié trois virus mentaux. Les virus mentaux sont des idées séduisantes qui semblent intelligentes, mais qui ne fonctionnent pas en pratique.

1. Orchestration Multi-Agent

2. RAG (Génération Augmentée par Récupération)

3. Plus d'instructions = Meilleurs résultats

Explorons pourquoi !

85,86K

Meilleurs

Classement

Favoris