Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Concordo plenamente: 1. A colaboração paralela de múltiplos agentes não é tão estável quanto a de um único thread; 2. RAG não é confiável e é pior do que a busca tradicional; 3. Quanto mais instruções houver nas palavras-chave, menos o modelo sabe como escolher.

—— A tradução original do tweet é a seguinte ——

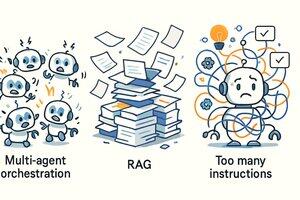

Na construção de agentes inteligentes de IA (AI Agent), nossa equipe @Cline identificou três "vírus de pensamento". O que chamamos de "vírus de pensamento" são aquelas ideias que parecem muito inteligentes, mas que na prática não funcionam de jeito nenhum.

Esses três vírus são:

* Colaboração de múltiplos agentes (Multi-Agent Orchestration)

* Geração aumentada por busca (RAG)

* Mais instruções = melhores resultados

Vamos explorar isso!

1. Colaboração de múltiplos agentes

Aquela cena de filme de ficção científica — "agentes de apoio, agentes de suprimentos, agentes de análise, agentes de comando" despachando um grande número de sub-agentes e, por fim, reunindo os resultados — soa realmente legal. Mas a realidade é que a grande maioria do trabalho útil dos agentes é feito em um único thread.

Processos de colaboração complexos raramente trazem valor real, e muitas vezes criam confusão. É importante saber que apenas fazer o modelo funcionar de forma estável em um único thread já é bastante difícil, quanto mais lidar com aquelas lógicas de colaboração paralela. Isso não só aumenta a complexidade da implementação, mas também torna o processo de compreensão e decisão do modelo excepcionalmente complicado.

2. Usar RAG para construir agentes

RAG, ou Geração Aumentada por Busca (Retrieval Augmented Generation), também é um vírus de pensamento. Ele parece muito poderoso em teoria, mas na prática, especialmente em cenários de agentes, às vezes até mesmo um comando básico de busca de texto como GREP é mais útil.

Por que o brilho do RAG se desvanece nos fluxos de trabalho reais dos agentes? Porque as informações recuperadas são frequentemente fragmentadas e não permitem que o modelo forme uma "compreensão" coerente e útil.

Uma abordagem melhor é quase sempre: deixar o modelo listar os arquivos, buscar de forma semelhante ao grep e, em seguida, abrir e ler o arquivo inteiro (como um humano faria). A equipe @Cline começou a fazer isso há muito tempo, e depois vimos que @Amp — Research Preview e @Cursor também se voltaram para essa abordagem mais pragmática.

3. Mais instruções = melhores resultados

Há um equívoco amplamente difundido: empilhar cada vez mais "instruções" nas palavras-chave do sistema (system prompt) fará com que o modelo se torne mais inteligente. Isso está completamente errado.

"Hidratar" as palavras-chave só confundirá o modelo, pois mais instruções frequentemente levam a conflitos de sugestões e sobrecarga de informações.

O resultado é que você acaba tendo que consertar continuamente os comportamentos estranhos do modelo, como se estivesse jogando "mole" em vez de obter saídas realmente úteis. Para a maioria dos modelos de ponta hoje, a melhor abordagem é não obstruir seu caminho, em vez de ficar gritando ao lado, tentando direcioná-los para uma determinada direção. Valorize cada uma de suas palavras (ou Tokens).

Em suma, essas três ideias são extremamente sedutoras. Se você não lida com IA o dia todo, pode achar que todas elas fazem muito sentido — no entanto, a realidade é diferente. Claro, à medida que as capacidades dos modelos subjacentes melhoram, nossa visão sobre esses métodos também pode mudar no futuro.

20/08, 01:00

Ao construir agentes de IA @cline, identificámos três vírus mentais. Os Vírus Mentais são ideias sedutoras que parecem inteligentes, mas não funcionam na prática.

1. Orquestração Multi-Agente

2. RAG (Geração Aumentada por Recuperação)

3. Mais Instruções = Melhores Resultados

Vamos explorar o porquê!

85,86K

Top

Classificação

Favoritos