Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jag håller helt med:1. Parallellt samarbete mellan flera agenter är inte lika stabilt som en enda tråd. 2. RAG är inte lika tillförlitlig som traditionell sökning; 3. Ju fler instruktioner som finns i prompten, desto mer vet modellen inte hur den ska välja.

——Den ursprungliga översättningen är som följer——

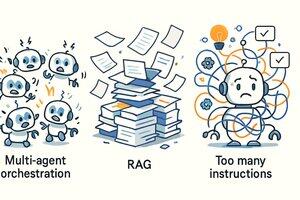

På vägen mot att bygga AI-agenter @Cline vårt team identifierat tre "tänkande virus". Det så kallade "tankeviruset" är de frestande idéer som låter väldigt smarta men som inte fungerar alls i praktiken.

De tre virusen är:

* Orkestrering med flera agenter

* Hämtning av Augmented Generation (RAG)

* Ju fler instruktioner = desto bättre effekt

Låt oss ta reda på det!

1. Samarbete mellan flera agenter

Den typ av scen som utspelar sig i en science fiction-film - "rear agents, ammunitionsagenter, analysagenter, kommandoagenter" - där man skickar iväg en stor grupp underagenter och slutligen summerar resultaten - låter riktigt coolt. Men verkligheten är att den stora majoriteten av användbart agentarbete är enkeltrådat.

Komplexa samarbetsprocesser levererar sällan verkligt värde och skapar ofta kaos. Du vet, det är svårt nog att få modellen att fungera stabilt i en enda tråd, än mindre hantera parallell samarbetslogik. Detta ökar inte bara komplexiteten i implementeringen, utan gör också förståelsen och beslutsprocessen för modellen extremt komplex.

2. Använd RAG för att bygga agenter

RAG, eller Retrieval Augmented Generation, är också ett tankevirus. Det ser kraftfullt ut i teorin, men i praktiken, särskilt i agentscenarier, är till och med grundläggande textsökningskommandon som GREP ibland bättre än det.

Varför bleknar RAG:s aura i det faktiska agentarbetsflödet? Eftersom den information som hämtas ofta är fragmenterad och inte kan låta modellen bilda en sammanhängande och användbar "förståelse".

En bättre metod är nästan alltid att låta modellen lista filerna på egen hand, söka på ett grep-liknande sätt och sedan öppna och läsa hela filen (precis som en människa). Det @Cline-teamet började göra detta tidigt, och sedan såg vi att @Amp – Research Preview och @Cursor – också gick över till detta mer pragmatiska tillvägagångssätt.

3. Fler instruktioner = desto bättre effekt

Det finns en utbredd missuppfattning om att man blir smartare om man samlar på sig fler och fler "instruktioner" i systemprompter. Detta är helt fel.

Att "vattna" uppmaningen kommer bara att förvirra modellen, eftersom fler instruktioner tenderar att leda till motstridiga förslag och informationsöverbelastning.

Som ett resultat måste du spela en omgång "whack-a-mole" och ständigt mixtra med alla möjliga konstiga beteenden hos modellen istället för att få riktigt användbara resultat. För de flesta av dagens banbrytande modeller är det bästa sättet att komma ur vägen att inte skrika på dem i ett försök att styra dem i en viss riktning. Var snäll och vårda varje ord (eller token).

På det hela taget är alla tre av ovanstående idéer mycket frestande. Om du inte arbetar med AI hela dagen kanske du tror att de alla är vettiga – men det gör de inte. I takt med att kapaciteten hos de underliggande modellerna förbättras kan vår uppfattning om dessa metoder förändras i framtiden.

20 aug. 01:00

Genom att bygga AI-agenter @cline har vi identifierat tre tankevirus Mind Virus är förföriska idéer som låter smarta, men som inte fungerar i praktiken.

1. Orkestrering med flera agenter

2. RAG (Retrieval Augmented Generation)

3. Fler instruktioner = bättre resultat

Låt oss utforska varför!

85,87K

Topp

Rankning

Favoriter