Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Profondamente d'accordo: 1. La collaborazione parallela tra più agenti non è stabile come un singolo thread; 2. RAG non è affidabile e non è migliore della ricerca tradizionale; 3. Più istruzioni ci sono nei prompt, meno il modello sa come scegliere.

——Traduzione originale——

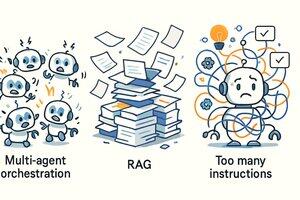

Nel percorso di costruzione di agenti intelligenti (AI Agent), il nostro team @Cline ha identificato tre "virus mentali". I cosiddetti "virus mentali" sono quelle idee seducenti che sembrano brillanti, ma che in pratica non funzionano affatto.

Questi tre virus sono:

* Collaborazione tra più agenti (Multi-Agent Orchestration)

* Generazione aumentata da ricerca (RAG)

* Più istruzioni = migliori risultati

Esploriamo insieme!

1. Collaborazione tra più agenti

Quella scena da film di fantascienza — "agenti di supporto, agenti di approvvigionamento, agenti di analisi, agenti di comando" che inviano un gran numero di sottogruppi di agenti, per poi riassumere i risultati — suona davvero fantastica. Ma la realtà è che la maggior parte del lavoro utile degli agenti è a thread singolo.

Processi di collaborazione complessi raramente portano a un vero valore, anzi spesso creano confusione. È importante sapere che far funzionare il modello in modo stabile in un singolo thread è già abbastanza difficile, figuriamoci gestire quelle logiche di collaborazione parallela. Questo non solo aumenta la complessità dell'implementazione, ma rende anche il processo di comprensione e decisione del modello eccezionalmente complesso.

2. Costruire agenti con RAG

RAG, ovvero Generazione Aumentata da Ricerca (Retrieval Augmented Generation), è anch'esso un virus mentale. In teoria sembra molto potente, ma nella pratica, specialmente nello scenario degli agenti, a volte comandi di ricerca di base come GREP sono più utili.

Perché l'aura di RAG svanisce nei flussi di lavoro reali degli agenti? Perché le informazioni recuperate sono spesso frammentate e non consentono al modello di formare una "comprensione" coerente e utile.

Un metodo migliore è quasi sempre: lasciare che il modello elenchi i file, cercando in modo simile a grep, e poi aprire e leggere l'intero file (proprio come farebbe un umano). Il team @Cline ha iniziato a farlo molto tempo fa, e successivamente abbiamo visto che @Amp — Research Preview e @Cursor si sono anche orientati verso questo approccio più pragmatico.

3. Più istruzioni = migliori risultati

C'è un malinteso molto diffuso: accumulare sempre più "istruzioni" nel prompt di sistema (system prompt) renderà il modello più intelligente. Questo è completamente sbagliato.

Aggiungere "acqua" ai prompt non fa altro che confondere il modello, poiché più istruzioni spesso portano a conflitti tra suggerimenti e sovraccarico di informazioni.

Il risultato è che ti ritrovi a dover riparare continuamente i vari comportamenti strani del modello, come in un gioco di "colpisci il topo", piuttosto che ottenere output realmente utili. Per la maggior parte dei modelli all'avanguardia di oggi, il miglior approccio è non ostacolarli, piuttosto che stare a urlare incessantemente per cercare di indirizzarli in una direzione specifica. Valuta ogni tua parola (o Token).

In sintesi, queste tre idee sono tutte molto seducenti. Se non hai a che fare con l'AI tutto il giorno, potresti trovarle tutte molto sensate — ma non è così. Certamente, con il miglioramento delle capacità dei modelli sottostanti, la nostra opinione su questi metodi potrebbe cambiare in futuro.

20 ago, 01:00

Nella costruzione di agenti AI @cline, abbiamo identificato tre virus mentali. I virus mentali sono idee seducenti che sembrano intelligenti, ma non funzionano nella pratica.

1. Orchestrazione Multi-Agente

2. RAG (Generazione Aumentata da Recupero)

3. Più Istruzioni = Migliori Risultati

Esploriamo perché!

89,31K

Principali

Ranking

Preferiti