Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

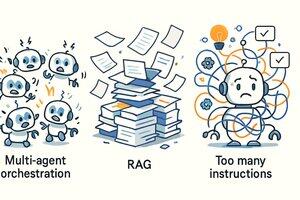

Diep van mening: 1. Multi-agent samenwerking is minder stabiel dan single-thread; 2. RAG is onbetrouwbaar en slechter dan traditionele zoekmethoden; 3. Hoe meer instructies in de prompt, hoe minder het model weet wat te kiezen.

—— Originele vertaling hieronder ——

Op de weg naar het bouwen van AI-agenten heeft ons team @Cline drie soorten "denkvira" geïdentificeerd. Wat we "denkvira" noemen, zijn ideeën die heel slim klinken, maar in de praktijk totaal niet werken.

Deze drie virussen zijn:

* Multi-agent samenwerking (Multi-Agent Orchestration)

* Zoekversterkte generatie (RAG)

* Hoe meer instructies = hoe beter het resultaat

Laten we ze eens nader bekijken!

1. Multi-agent samenwerking

Die scènes uit sciencefictionfilms - "achtergrondagenten, militaire agenten, analyseagenten, commandantagenten" die een grote groep sub-agenten uitzenden en uiteindelijk de resultaten samenvoegen - klinkt inderdaad heel cool. Maar de realiteit is dat de meeste nuttige agentwerkzaamheden single-threaded zijn.

Complexe samenwerkingsprocessen brengen zelden echte waarde, maar veroorzaken vaak chaos. Het is belangrijk te weten dat het al moeilijk genoeg is om het model stabiel te laten werken in een single-thread, laat staan om die parallelle samenwerkingslogica te verwerken. Dit verhoogt niet alleen de complexiteit van de implementatie, maar maakt ook het begrip en het besluitvormingsproces van het model uitzonderlijk complex.

2. Gebruik RAG om agenten te bouwen

RAG, oftewel Zoekversterkte Generatie (Retrieval Augmented Generation), is ook een soort denkvira. Het lijkt in theorie heel krachtig, maar in de praktijk, vooral in agentenscenario's, is het soms zelfs minder handig dan een basis tekstzoekopdracht zoals GREP.

Waarom vervaagt de glans van RAG in de werkstromen van agenten? Omdat de informatie die het ophaalt vaak losse fragmenten zijn, die het model niet in staat stellen een samenhangend en nuttig "begrip" te vormen.

Een betere methode is bijna altijd: laat het model zelf de documenten opsommen, zoek op een manier die lijkt op grep, en open en lees het hele document (zoals mensen dat doen). Het @Cline-team is hier al vroeg mee begonnen, en later zagen we dat @Amp - Research Preview en @Cursor ook deze meer pragmatische aanpak zijn gaan volgen.

3. Hoe meer instructies = hoe beter het resultaat

Er is een wijdverspreide misvatting: door steeds meer "instructies" in de systeemprompt te stapelen, kan het model slimmer worden. Dit is volledig onjuist.

Het "overladen" van de prompt zal het model alleen maar in verwarring brengen, omdat meer instructies vaak leiden tot conflicterende aanbevelingen en informatie-overload.

Het resultaat is dat je, net als bij het spel "mollen vangen", voortdurend de vreemde gedragingen van het model moet repareren, in plaats van echt nuttige output te krijgen. Voor de meeste moderne modellen is de beste aanpak om ze niet in de weg te staan, in plaats van ernaast te staan en voortdurend te schreeuwen om ze in een bepaalde richting te duwen. Waardeer elk woord (of Token) dat je hebt.

Samenvattend, deze drie ideeën zijn zeer verleidelijk. Als je niet de hele dag met AI bezig bent, lijkt het misschien allemaal heel logisch - maar dat is het niet. Natuurlijk, naarmate de onderliggende modelcapaciteiten verbeteren, kan onze kijk op deze methoden in de toekomst ook veranderen.

20 aug, 01:00

Bij het bouwen van AI-agenten @cline hebben we drie geestelijke virussen geïdentificeerd. Geestelijke virussen zijn verleidelijke ideeën die slim klinken, maar in de praktijk niet werken.

1. Multi-Agent Orkestratie

2. RAG (Retrieval Augmented Generation)

3. Meer instructies = Betere resultaten

Laten we onderzoeken waarom!

85,86K

Boven

Positie

Favorieten