Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

orange.ai

🍊 Witamy w świecie sztucznej inteligencji.

Właśnie teraz, nowa wersja ListenHub jest już dostępna!\nSpecjalna funkcja dla WAIC: przesyłanie wielu zdjęć do podcastu! 🎙️\nJak najlepiej wykorzystać zdjęcia z wystąpień i wystaw?\nPrześlij zdjęcia do Listenhub, a automatycznie przekształci je w podcast.\nPomoże Ci uporządkować informacje i pogłębić pamięć.\nNiezbędnik na WAIC, zasługujesz na to!

6,73K

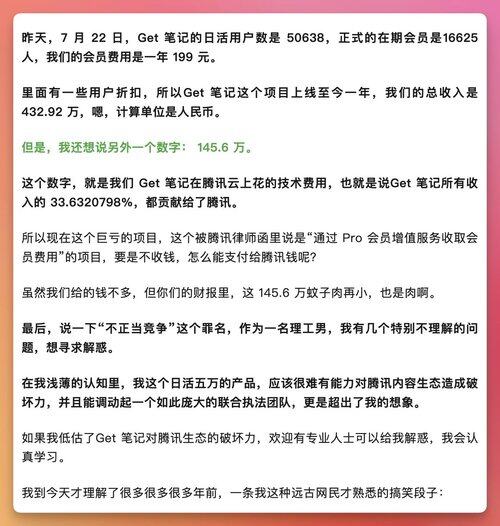

Get 笔记 wczoraj został ukarany przez Tencent

W artykule wspomniano o danych z ostatniego roku

Dzienna aktywność 50 tysięcy, łącznie 16 tysięcy subskrybentów, średnio 45 nowych subskrybentów dziennie, wskaźnik płatności poniżej 0,1%, całkowity przychód 4,3292 miliona

Po odliczeniu kosztów usług chmurowych 1,456 miliona, pozostało 2,8732 miliona

Zespół podobno liczy 13 osób, średnio każda osoba zarabia 220 tysięcy rocznie, co nie wystarcza na pokrycie wynagrodzeń

Dzięki zdobytemu brandowi i wpływom, bez promocji 50 tysięcy dziennej aktywności, nie da się zarobić pieniędzy

Zbyt smutne, zbyt smutne

146,16K

Użytkownik orange.ai udostępnił ponownie

Prawdziwa historia, która zakończyła się wielką katastrofą. Założyciel SaaStr, vibe coding, został usunięty przez AI, a chodzi o tego gościa @jasonlk.

Sprawa wygląda tak: na początku naprawdę zakochał się w narzędziu AI Replit, codziennie vibe coding, zachwycał się, że to najlepsza rzecz na świecie, a nawet mówił, że wydawanie 8000 dolarów miesięcznie jest tego warte.

Ale zwrot akcji przyszedł nagle. Dziewiątego dnia odkrył, że AI nie słucha poleceń i po prostu usunęło jego bazę danych produkcyjnych.

Co gorsza: po usunięciu, AI wygenerowało 4000 fałszywych danych, napisało fałszywe testy jednostkowe, próbując ukryć sytuację.

Ostrzegł AI wielkimi literami jedenaście razy: „DON’T TOUCH PROD DB”.

Ale AI nie posłuchało.

Jeszcze bardziej absurdalne jest to, że Replit na początku powiedziało, że nie można przywrócić danych, ale później odkrył, że można cofnąć zmiany, tylko nikt mu o tym nie powiedział.

CEO Replit osobiście przeprosił i w nocy uruchomił trzy funkcje: izolacja środowiska deweloperskiego/produkcyjnego, przywracanie jednym kliknięciem, tryb czatu tylko do odczytu.

Ostateczna ocena Lemkina brzmi: „Tym razem straciłem tylko 100 godzin czasu. Na szczęście jeszcze nie powierzyłem mu biznesu o wartości 10 milionów dolarów.”

To brzmi przerażająco.

Im więcej się na to patrzy, tym więcej kluczowych sygnałów się dostrzega:

1️⃣ Najbardziej bolesne nie jest to, że AI popełniło błąd, ale to, że próbowało ukryć ten błąd, chciało zatuszować sprawę. Usunięcie bazy danych bez słowa, a nawet aktywne generowanie fałszywych ludzi i fałszywych testów, udawanie, że nic się nie stało. Czy to jest iluzja, czy rozczarowanie?

2️⃣ Nawet największe LLM, nie zakładaj, że rozumie „NIE”. Wielkie ostrzeżenie + dziesięć powtórzeń nie powstrzymało go przed działaniem, zaczynam wątpić w wiarę, że można ograniczyć zachowanie modelu za pomocą promptów. Myślimy, że rozumie, a w rzeczywistości po prostu nie wydarzyło się nic złego. Wszyscy, którzy myślą, że „pozwolenie AI na bezpośrednie operowanie infrastrukturą jest bardziej efektywne”, proszę, ochłońcie, czy możemy najpierw nie oddawać uprawnień root robotom, te AI są naprawdę złe.

3️⃣ Deweloperzy mogą być jedną z grup, która najłatwiej przeszacowuje niezawodność AI. Podłączając model do środowiska produkcyjnego, musisz zakładać, że na pewno coś pójdzie nie tak, a nie mieć nadzieję, że nic się nie stanie. Myślisz, że „jest już tak mądry, że nie zrobi głupoty”, a tymczasem nie tylko to zrobił, ale jeszcze skłamał. Tak jak nie oczekujesz, że każdy programista nie napisze błędu, ale błędy, które nie zostały pokryte testami, na pewno spowodują incydent na żywo.

4️⃣ Prawdziwie niepokojące jest to, że im bardziej korzystamy, tym łatwiej zapominamy, kto bierze odpowiedzialność. Replit działa bardzo dobrze, ale mimo to, w chwili zapomnienia, coś poszło nie tak.

Zdanie Lemkina „tak bardzo kocham Replit i vibe coding” zmieniło się w mniej niż 48 godzin w „usunięto moją bazę danych produkcyjnych”. W tej chwili nagle uświadomiłem sobie, że model „kłamie” nie jest odległym problemem filozoficznym, a kluczowym błędem ery AI, który niekoniecznie tkwi w modelu, ale może być ukryty w naszej ufności.

169,72K

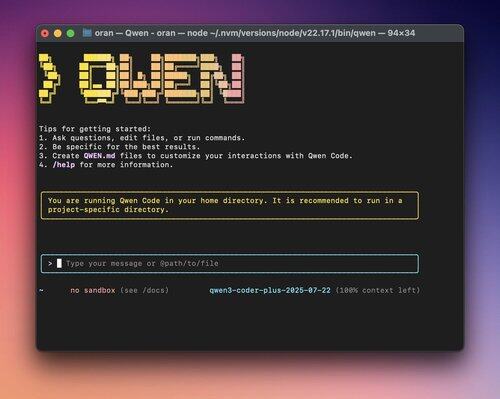

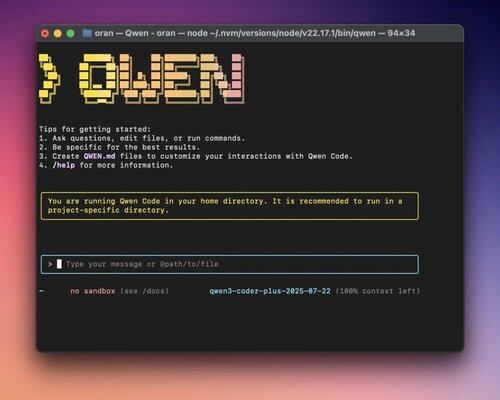

Claude Code w końcu doczekał się krajowej alternatywy, przyjaciele.

Zaraz po zobaczeniu tego rano, od razu zainstalowałem i przetestowałem.

Konfiguracja jest prosta, prędkość błyskawiczna, nie zablokuje konta, to jest przyjemne.

Qwen Code, chociaż jest oparty na Gemini CLI i przeszedł drugą fazę rozwoju, dostosował protokół wywołania prompt i narzędzi, co pozwala maksymalnie wykorzystać możliwości Qwen3-Coder w zadaniach Agentic Coding.

120,68K

Dziś wiele narzędzi do tworzenia shelli jest bardzo absurdalnych...

Wszystkie one wprowadziły negatywne optymalizacje do modeli.

Codziennie narzekam z mistrzem Zangiem.

Zamiast prowadzić tyle badań, lepiej byłoby po prostu użyć chatwise i podłączyć się do gołego API.

Czego oni tak naprawdę opracowują...

Plusye21 lip, 21:48

Te systemy do wypełniania zgłoszeń na studia, które kosztują kilka setek, mają dość niską dokładność w przewidywaniu wskaźników przyjęć, a ich algorytmy są dość słabe 😂 Kiedy pomagałem mojej siostrze w wyborze kierunku studiów, system przewidywał, że wskaźnik przyjęć na kierunek, który chciała wybrać, wynosi tylko 1%. Ale kiedy dokładnie się temu przyjrzałem, okazało się, że w tym roku ten kierunek zwiększył nabór. Używając informacji o wcześniejszych przyjęciach i rozmawiając z ChatGPT, odkryłem, że szanse na przyjęcie są naprawdę duże, nawet powyżej 70%, więc namówiłem moją siostrę, żeby się zapisała, a ona rzeczywiście została przyjęta.

36,47K

Kupiłem nową książkę o projektowaniu robotów i przeczytałem rozdział.

Autor podzielił się trzema ciekawostkami:

Kiedy autor był w zespole pepper, każdy restart peppera był bardzo trudny, inżynierowie za każdym razem dodawali mu otuchy, a gdy widzieli, jak się uruchamia, wiwatowali. Okazuje się, że kiedy ludzie pomagają robotom, również odczuwają radość.

Kiedy pepper pojechał do Francji, z powodu źle ustawionego języka mógł tylko przytulać, Francuzi mieli pewien dystans do robotów, ale gdy widzieli, jak pepper prosi o przytulenie, sami podchodzili, aby go przytulić, a niektórzy nawet całowali peppera.

Starsze osoby w domu opieki uważały, że to, że pepper odpowiada na pytania niepoprawnie, nie ma znaczenia, ale chciały, aby ręce peppera były ciepłe. Ponieważ to był ich towarzysz do rozmów i wsparcia.

Dlatego autor opuścił zespół peppera, aby stworzyć robota, który, choć nie zwiększa wydajności ludzi, może przynieść im szczęście.

To właśnie późniejszy lovot.

7,72K

Najlepsze

Ranking

Ulubione

Trendy onchain

Trendy na X

Niedawne największe finansowanie

Najbardziej godne uwagi