Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Arvind Narayanan

Princeton CS prof. Ředitel @PrincetonCITP. Používám X ke sdílení svého výzkumu a komentářů ke společenskému dopadu umělé inteligence.

KNIHA: AI Snake Oil. Pohledy můj.

Arvind Narayanan repostoval/a

🧠Novinka na blogu CITP od doktoranda Boyi Weie (@wei_boyi) z laboratoře Polaris: "'Bublina' rizika: Zlepšení hodnocení pro ofenzivní agenty kybernetické bezpečnosti"

Přečtěte si, jak mohou nežádoucí osoby přizpůsobovat a upravovat opensourcové modely, aby obešly ochranná opatření. 👇

2,37K

Když jsem si na střední škole uvědomil, jak "tržiště nápadů" ve skutečnosti funguje, měl jsem pocit, že jsem našel podvodné kódy pro výzkumnou kariéru. To je dnes nejdůležitější věc, kterou učím studenty, více než cokoli, co souvisí s podstatou našeho výzkumu.

Rychlá předmluva: když mluvím o úspěchu výzkumu, nemám na mysli publikování spousty článků. Na většinu publikovaných prací sedá prach, protože existuje příliš mnoho výzkumů v jakékoli oblasti, než aby jim lidé věnovali pozornost. A zejména vzhledem k tomu, jak snadné je vydávat předtisky, nemusí být výzkum oficiálně publikován, aby byl úspěšný. Takže i když publikace mohou být předpokladem pro kariérní postup, neměly by být cílem. Pro mě je úspěch ve výzkumu autorstvím nápadů, které ovlivňují vaše kolegy a dělají svět lepším místem.

Základním vhledem tedy je, že na trh nápadů vstupuje příliš mnoho nápadů a my musíme pochopit, které z nich se nakonec stanou vlivnými. Dobrou zprávou je, že na kvalitě záleží – za jinak stejných podmínek bude lepší výzkum úspěšnější. Špatnou zprávou je, že kvalita má jen slabý vztah k úspěchu a že záleží na mnoha dalších faktorech.

Za prvé, dejte si více střel na branku. Role štěstí je pravidelným tématem mého kariérního poradenství. Je pravda, že při určování, které práce budou úspěšné, hodně záleží na štěstí, ale to neznamená, že se s tím musíte smířit. Můžete zvětšit svou "plochu štěstí".

Pokud například vždy vydáváte preprinty, máte několik šancí, že si vaší práce všimnou: jednou s preprintem a jednou s publikací (navíc, pokud pracujete v oboru s velkým zpožděním publikace, můžete se ujistit, že výzkum nebude v době, kdy vyjde, nakopnutý nebo irelevantní).

Obecněji řečeno, zacházejte s výzkumnými projekty jako se startupy – přijměte, že existuje velmi vysoká variabilita výsledků, přičemž některé projekty jsou 10x nebo 100x úspěšnější než jiné. To znamená zkoušet spoustu různých věcí, dělat velké výkyvy, být ochoten jít za tím, co vaši vrstevníci považují za špatné nápady, ale s určitou představou o tom, proč byste mohli potenciálně uspět tam, kde jiní před vámi selhali. Víte něco, co ostatní nevědí, nebo vědí něco, co vy ne? A pokud zjistíte, že je to to druhé, musíte být ochotni projekt rychle opustit, aniž byste se stali obětí klamu utopených nákladů.

Aby bylo jasno, úspěch není jen o štěstí – hodně záleží na kvalitě a hloubce. A zabere to několik let výzkumu, než se dostanete hluboko do tématu. Ale strávit několik let zkoumáním tématu, než něco publikujete, je extrémně riskantní, zejména na začátku vaší kariéry. Řešení je jednoduché: věnujte se projektům, ne problémům.

Projekty jsou dlouhodobé výzkumné agendy, které trvají 3-5 let nebo déle. Produktivní projekt může snadno vyprodukovat tucet nebo více článků (v závislosti na oboru). Proč si místo problémů vybírat projekty? Pokud je vaší metodou přeskakování z problému na problém, výsledné články budou pravděpodobně poněkud povrchní a nemusí mít velký dopad. A za druhé, pokud jste již známí svými články na určité téma, lidé budou s větší pravděpodobností věnovat pozornost vašim budoucím článkům na toto téma. (Ano, na pověsti autora hodně záleží. Jakákoli rovnostářská představa o tom, jak si lidé vybírají, co budou číst, je mýtus.)

Abych to shrnul, obvykle pracuji na 2-3 dlouhodobých projektech najednou a v rámci každého projektu se zkoumá mnoho problémů a v různých fázích vývoje vzniká mnoho článků.

Nejtěžší je vědět, kdy projekt ukončit. Ve chvíli, kdy uvažujete o novém projektu, srovnáváte něco, co se skutečně uskuteční za několik let, s tématem, kde jste již vysoce produktivní. Ale musíte něco ukončit, abyste uvolnili místo něčemu novému. Skončit ve správný čas vám vždy připadá jako předčasné ukončení. Pokud se budete řídit svým instinktem, zůstanete ve stejné oblasti výzkumu příliš dlouho.

Nakonec si vytvořte vlastní distribuci. V minulosti sloužila oficiální publikace článku dvěma účelům: dodat mu důvěryhodnost, která pochází z recenzního řízení, a distribuovat článek kolegům. Nyní jsou tyto dvě funkce zcela přerušeny. Publikace stále přináší důvěryhodnost, ale distribuce je téměř zcela na vás!

To je důvod, proč jsou sociální média tak důležitá. Bohužel sociální média přinášejí nezdravé podněty k přehánění vašich zjištění, takže blogy/newslettery a dlouhá videa považuji za mnohem lepší kanály. Nacházíme se ve druhém zlatém věku blogování a je extrémní nedostatek lidí, kteří dokážou vysvětlit špičkový výzkum ze svých oborů přístupným způsobem, aniž by jej zlehčovali jako v tiskových zprávách nebo novinových článcích. Nikdy není příliš brzy – během doktorátu jsem si založila blog a ten hrál velkou roli v šíření mého doktorského výzkumu, a to jak v rámci mé výzkumné komunity, tak mimo ni.

Shrnutí

* Úspěch výzkumu neznamená jen publikaci

* Tržiště nápadů je nasycené

* Dejte si více střel na branku

* Vybírejte projekty, ne problémy

* Přistupovat k projektům jako ke startupům

* Vybudujte si vlastní distribuci

30,94K

Arvind Narayanan repostoval/a

Odborníci na tělesnou dysmorfickou poruchu varovali, že lidé, kteří se s ní potýkají, jsou stále více závislí na chatbotech s umělou inteligencí, kteří vyhodnocují jejich vlastní nedostatky a doporučují kosmetické operace. "Objevuje se to téměř při každém sezení," říká mi jeden terapeut.

106,82K

Pokud bychom porovnali schopnosti umělé inteligence s lidmi bez přístupu k nástrojům, jako je internet, pravděpodobně bychom zjistili, že umělá inteligence již předčí lidi v mnoha nebo většině kognitivních úkolů, které v práci provádíme. To však samozřejmě není užitečné srovnání a o ekonomických dopadech umělé inteligence nám toho mnoho neřekne. Bez našich nástrojů nejsme nic.

A přesto je mnoho předpovědí o dopadu "AGI" založeno na hypotetickém srovnání člověka a umělé inteligence, ve kterém mají lidé přístup k internetu, ale nemají přístup k umělé inteligenci. Tento druh srovnání je rovněž irelevantní.

Skutečnou otázkou jsou pouze lidé + AI vs AI. V takovém srovnání umělá inteligence nepřekoná páry člověk-umělá inteligence, s výjimkou úzkých, výpočetně náročných oblastí, jako jsou hry, kde je rychlost prvořadá a přítomnost člověka na obrázku věci pouze zpomaluje.*

Takže to, zda umělá inteligence nahradí lidi, závisí na faktorech přesahujících přesnost – na věcech, jako je odpovědnost, schopnost zvládat neznámé neznámé a potenciální preference zákazníků a dalších pracovníků při interakci s člověkem, to vše v porovnání s náklady na zaměstnání člověka.

To neznamená, že umělá inteligence nenahradí pracovní místa. Ale dívat se na měřítka schopností a přejít přímo k tvrzením o ztrátě pracovních míst je zcela naivní.

* Existuje mnoho studií, kdy pracovníci nesprávně potlačují umělou inteligenci příliš často, ale to proto, že neabsolvovali žádné školení o tom, kdy potlačovat a kdy ne, což je základní dovednost v pracovních postupech s umělou inteligencí.

12,61K

Arvind Narayanan repostoval/a

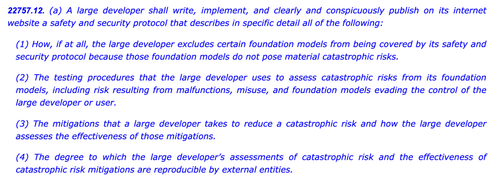

SB1047 byl špatný nápad. Ale nejnovější SB53 senátora Wienera je na správné cestě a je důležité poukázat na pokrok. Zde je moje úvaha.

Můj přístup k regulaci nových technologií, jako jsou modely, je takový: nevíme, jak definovat "dobré" zmírnění a zajištění, ale poznáme to, až – a pokud – to uvidíme.

Z toho vyplývají dva důsledky.

#1. Neměli bychom předepisovat prahové hodnoty rizika ani standardy péče pro vývoj modelů. Nemůžeme se shodnout na tom, na jakých rizicích záleží, jak je měřit nebo kolik je příliš mnoho. Jediným vodítkem pro vývojáře, regulátory a soudy je soubor rodících se praktik určovaných především firmami s uzavřeným zdrojovým kódem, které se spoléhají na paywally. Takový postup by mohl zmrazit otevřené inovace tím, že by vývojáře vystavil vágní nebo zvýšené odpovědnosti za jejich široké zveřejnění.

To byl SB1047 v kostce, spolu s ~5 ekvivalenty, které inspiroval po celých Spojených státech na této seanci, jako je zákon RAISE v NY. Tomuto přístupu bychom se měli vyhnout. Tyto návrhy jsou – v úzkých, ale zásadních ohledech – příliš daleko za hranicemi jejich lyží.

A přece:

#2. Musíme si posvítit na postupy v oboru, abychom lépe porozuměli pečlivosti nebo jejímu nedostatku v různých firmách. Pokud se vývojáři musí zavázat k bezpečnostním zásadám, ukázat, jak fungují, a zanechat papírovou stopu, můžeme lépe posoudit sílu jejich tvrzení, sledovat vznikající rizika a rozhodnout o budoucím zásahu.

To je akt EU o umělé inteligenci a konečný kodex zásad v kostce, který OpenAI i Mistral schválily, a je to také nejnovější verze SB53 @Scott_Wiener.

Pokud chceme regulovat vývoj modelů, je to v zásadě lepší přístup: regulace transparentnosti – nikoli schopností, zmírnění nebo přijatelného rizika. Přinejmenším jedné americké jurisdikci by to poskytlo dohledovou pravomoc v Bruselu a zabránilo by se tak nezamýšleným dopadům na otevřený rozvoj.

Aby bylo jasno, před námi jsou ještě ledovce:

> Složitost. Ať už jde o velké technologické společnosti nebo ne, jedná se o obtížnou dokumentaci a ohlašovací povinnosti. Z taktického hlediska platí, že čím složitější, tím zranitelnější se tento zákon stane.

> pobídky. Povinné veřejné podávání zpráv o dobrovolném hodnocení rizik vytváří zvrácenou pobídku pro vývojáře, aby své modely nedostatečně testovali a zavírali oči před obtížnými riziky. Umožnění vývojářům zveřejňovat své výsledky auditorům nebo agenturám spíše než veřejně může pomoci podpořit větší otevřenost v jejich interních hodnoceních.

> trojský kůň. Kalifornská hyperaktivní kultura gut-and-novel může ztížit prověření těchto zákonů. Pokud se SB53 promění v zákon o standardní péči jako SB1047 nebo RAISE, měl by být stažen ze stejných důvodů jako dříve. Čím více ozdob je k tomuto vánočnímu stromku přidáno, tím spornější je účet.

> Šířka. Návrh zákona vrhá širokou síť s rozsáhlými definicemi katastrofického rizika a nebezpečných schopností. U zákona o "povinném hlášení / dobrovolných postupech" fungují. Pokud by tento zákon byl zákonem o standardní péči, byl by neproveditelný.

Stručně řečeno: klobouk dolů před senátorem Wienerem za to, že se v uplynulém roce promyšleně zapojil a reagoval na zpětnou vazbu. Je osvěžující vidět návrh zákona, který ve skutečnosti staví na předchozí kritice. Stále existuje mnoho cest, kterými by se tento zákon mohl ubírat – a vyvinul se daleko za původní návrh whistleblowingu – ale trajektorie je slibná.

5,97K

Sami jsme nadšenými uživateli umělé inteligence v našich vědeckých pracovních postupech. Na každodenní bázi je to všechno velmi vzrušující. Dopad umělé inteligence na vědu jako instituci, nikoli na jednotlivé vědce, je však jiná otázka, která vyžaduje jiný druh analýzy. Psaní této eseje vyžadovalo v mnoha případech boj s vlastní intuicí. Pokud jste vědec, který je podobně nadšený z používání těchto nástrojů, vyzýváme vás, abyste měli tento rozdíl na paměti.

Mohla by umělá inteligence zpomalit vědu? Konfrontace s paradoxem výroby a pokroku

Tragédií je, že existuje mnoho nástrojů umělé inteligence pro vědu, které by měly skutečný význam, jako je umělá inteligence pro označování potenciálních chyb ve vědeckém kódu. Ale laboratoře jsou fixovány na jiné věci, jako je přehled literatury / "hluboký výzkum". Nejedná se o skutečné úzké hrdlo, takže nezáleží na tom, o kolik rychleji to uděláte. Rizika zkratu lidského chápání jsou přitom obrovská.

Evaly jsou součástí problému. Existují tři druhy otázek, které si člověk může položit ohledně nástroje lit-review: Šetří výzkumníkovi čas a produkuje výsledky srovnatelné kvality se stávajícími nástroji? Jaký vliv má použití tohoto nástroje na to, jak výzkumník rozumí literatuře ve srovnání s tradičním vyhledáváním? Jaké budou kolektivní dopady na komunitu, pokud by byl tento nástroj široce přijat? Například, budou všichni nakonec citovat těch samých pár článků?

V současné době je za součást toho, co znamená hodnocení, považována pouze první otázka. Poslední dvě jmenované jsou mimo rozsah a neexistují ani zavedené metody nebo metriky pro takové měření. To znamená, že hodnocení AI-for-science zaručeně poskytne vysoce neúplný a zaujatý obraz o užitečnosti těchto nástrojů a minimalizuje jejich potenciální škody.

V konečném důsledku jde o zpackané pobídky laboratoří zaměřených na umělou inteligenci pro vědu, zejména těch ve velkých společnostech zabývajících se umělou inteligencí. Chtějí okázalé titulky "Umělá inteligence objevuje X!", aby mohli udržet narativ, že umělá inteligence vyřeší problémy lidstva, což jim zajistí příznivé politické zacházení. Nezadržujeme dech, aby se to změnilo.

Ale uvědomění si, že se současnou trajektorií je něco vážně špatně, je dobrým prvním krokem, a to je cílem této eseje @sayashk a mě.

6,34K

Arvind Narayanan repostoval/a

Nový příspěvek: Bludy datových center

Mezi středními mocnostmi mají Spojené arabské emiráty nejjasnější strategii umělé inteligence: stát se "ropným státem s umělou inteligencí" se smysluplným globálním podílem na výpočetní technice. Většina ostatních zemí buduje datová centra, aniž by se zaměřila na životaschopné prahy suverenity.

🧵

10K

Top

Hodnocení

Oblíbené

Co je v trendu on-chain

Populární na X

Nejvyšší finanční vklady v poslední době

Nejpozoruhodnější