Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Arvind Narayanan

Princeton CS prof. Directeur @PrincetonCITP. Ik gebruik X om mijn onderzoek en commentaar op de maatschappelijke impact van AI te delen.

BOEK: AI Snake Oil. Uitzicht op de mijne.

Mijn ervaring met ChatGPT Agent tot nu toe: Ik heb geen gebruiksgevallen kunnen vinden die _niet_ kunnen worden afgehandeld door Deep Research en die toch met succes door Agent kunnen worden voltooid zonder tegen obstakels aan te lopen zoals haperende webformulieren of toegangsbeperkingen.

Ik weet zeker dat ik enkele toepassingen zal vinden, maar het zal uiteindelijk een klein percentage zijn van de taken die zich in mijn workflows voordoen.

Als dit het geval is, heeft het geen zin om nieuwe taken met Agent te proberen, tenzij het een taak is waar ik anders uren aan zou besteden (of die ik dagelijks zou moeten herhalen). Als mijn verwachting is dat Agent met een kans van 5% zal slagen, en het 10-20 minuten duurt om pijnlijk hard te proberen voordat ik opgeef, is het mijn tijd niet waard om zelfs maar te ontdekken of Agent het kan. Ik zou het alleen gebruiken als ik op de een of andere manier al wist dat het een taak is die Agent kan afhandelen.

Gezien dit alles blijf ik denken dat taak-specifieke agents in de nabije toekomst succesvoller zullen zijn.

6,78K

Arvind Narayanan heeft opnieuw gepost

🧠Nieuw op de CITP Blog van PhD-student Boyi Wei (@wei_boyi) van het POLARIS Lab: "De 'Bubbel' van Risico: Verbeteren van Beoordelingen voor Aanvallende Cybersecurity Agents"

Lees hoe tegenstanders open-source modellen kunnen aanpassen en wijzigen om beveiligingen te omzeilen. 👇

3,1K

Terug in de graduate school, toen ik me realiseerde hoe de "marktplaats van ideeën" eigenlijk werkt, voelde het alsof ik de cheatcodes voor een onderzoeksloopbaan had gevonden. Vandaag is dit het belangrijkste dat ik studenten leer, meer dan wat dan ook gerelateerd aan de inhoud van ons onderzoek.

Een korte inleiding: als ik het heb over onderzoeksucces bedoel ik niet het publiceren van veel artikelen. De meeste gepubliceerde artikelen verstoffen omdat er te veel onderzoek in elk vakgebied is voor mensen om aandacht aan te besteden. En vooral gezien de eenvoud van het publiceren van preprints, hoeft onderzoek niet officieel gepubliceerd te worden om succesvol te zijn. Dus terwijl publicaties misschien een vereiste zijn voor carrière-ontwikkeling, zouden ze niet het doel moeten zijn. Voor mij is onderzoeksucces auteurschap van ideeën die je collega's beïnvloeden en de wereld een betere plek maken.

Dus de basisinzichten zijn dat er te veel ideeën de marktplaats van ideeën binnenkomen, en we moeten begrijpen welke uiteindelijk invloedrijk zijn. Het goede nieuws is dat kwaliteit ertoe doet — andere dingen gelijk, beter onderzoek zal succesvoller zijn. Het slechte nieuws is dat kwaliteit slechts zwak gecorreleerd is met succes, en er zijn veel andere factoren die belangrijk zijn.

Ten eerste, geef jezelf meerdere kansen. De rol van geluk is een regelmatig thema in mijn loopbaanadvies. Het is waar dat geluk veel invloed heeft op welke artikelen succesvol zijn, maar dat betekent niet dat je je eraan moet overgeven. Je kunt je "geluksoppervlakte" vergroten.

Bijvoorbeeld, als je altijd preprints publiceert, krijg je meerdere kansen voor je werk om opgemerkt te worden: eenmaal met de preprint en eenmaal met de publicatie (plus als je in een veld met grote publicatietijden zit, kun je ervoor zorgen dat het onderzoek niet wordt gestolen of irrelevant is tegen de tijd dat het uitkomt).

Algemeen gesproken, behandel onderzoeksprojecten als startups — accepteer dat er een zeer hoge variatie in uitkomsten is, waarbij sommige projecten 10x of 100x succesvoller zijn dan andere. Dit betekent dat je veel verschillende dingen moet proberen, grote sprongen moet maken, bereid moet zijn om te streven naar wat je collega's als slechte ideeën beschouwen, maar met een idee van waarom je mogelijk zou kunnen slagen waar anderen voor jou gefaald hebben. Weet je iets dat anderen niet weten, of weten zij iets dat jij niet weet? En als je ontdekt dat het het laatste is, moet je bereid zijn om het project snel te stoppen, zonder in de val van de verzonken kosten te trappen.

Om duidelijk te zijn, succes is niet alleen afhankelijk van geluk — kwaliteit en diepgang zijn erg belangrijk. En het kost een paar jaar onderzoek om diep in een onderwerp te duiken. Maar een paar jaar aan een onderwerp besteden voordat je iets publiceert is extreem riskant, vooral vroeg in je carrière. De oplossing is eenvoudig: volg projecten, niet problemen.

Projecten zijn langetermijn onderzoeksagenda's die 3-5 jaar of langer duren. Een productief project kan gemakkelijk een dozijn of meer artikelen opleveren (afhankelijk van het vakgebied). Waarom projecten kiezen in plaats van problemen? Als je methode is om van probleem naar probleem te springen, zijn de resulterende artikelen waarschijnlijk enigszins oppervlakkig en hebben ze mogelijk niet veel impact. En ten tweede, als je al bekend bent om artikelen over een bepaald onderwerp, zullen mensen eerder aandacht besteden aan je toekomstige artikelen over dat onderwerp. (Ja, auteursreputatie is erg belangrijk. Elke egalitaire opvatting over hoe mensen kiezen wat ze lezen is een mythe.)

Om samen te vatten, ik werk meestal aan 2-3 langetermijnprojecten tegelijk, en binnen elk project zijn er veel problemen die worden onderzocht en veel artikelen die in verschillende stadia van de pijplijn worden geproduceerd.

Het moeilijkste is weten wanneer je een project moet beëindigen. Op het moment dat je een nieuw project overweegt, vergelijk je iets dat een paar jaar zal duren om echt tot bloei te komen met een onderwerp waar je al zeer productief bent. Maar je moet iets beëindigen om ruimte te maken voor iets nieuws. Stoppen op het juiste moment voelt altijd aan als te vroeg stoppen. Als je op je gevoel afgaat, blijf je veel te lang in hetzelfde onderzoeksgebied.

Tot slot, bouw je eigen distributie. In het verleden diende de officiële publicatie van een artikel twee doelen: het geven van de geloofwaardigheid die voortkomt uit peer review, en het distribueren van het artikel naar je collega's. Nu zijn die twee functies volledig gescheiden. Publicatie brengt nog steeds geloofwaardigheid, maar distributie is bijna volledig aan jou!

Dit is waarom sociale media zo belangrijk zijn. Helaas introduceren sociale media ongezonde prikkels om je bevindingen te overdrijven, dus ik vind blogs/nieuwsbrieven en lange video's veel betere kanalen. We bevinden ons in een tweede gouden tijdperk van bloggen en er is een extreme schaarste aan mensen die geavanceerd onderzoek uit hun disciplines op een toegankelijke manier kunnen uitleggen zonder het te verlagen zoals in persberichten of nieuwsartikelen. Het is nooit te vroeg — ik begon een blog tijdens mijn PhD en het speelde een grote rol in het verspreiden van mijn doctoraal onderzoek, zowel binnen mijn onderzoekscommunity als daarbuiten.

Samenvatting

* Onderzoeksucces betekent niet alleen publicatie

* De marktplaats van ideeën is verzadigd

* Geef jezelf meerdere kansen

* Kies projecten, niet problemen

* Behandel projecten als startups

* Bouw je eigen distributie.

44,22K

Arvind Narayanan heeft opnieuw gepost

Experts op het gebied van lichaamsdysmorfische stoornis hebben gewaarschuwd dat mensen die hiermee worstelen steeds afhankelijker zijn geworden van AI-chatbots om hun zelfperceptie van tekortkomingen te evalueren en cosmetische chirurgie aan te bevelen. "Het komt bijna in elke sessie ter sprake," vertelt een therapeut me.

106,84K

Als we de mogelijkheden van AI vergelijken met die van mensen zonder toegang tot hulpmiddelen, zoals het internet, zouden we waarschijnlijk ontdekken dat AI al beter presteert dan mensen bij veel of de meeste cognitieve taken die we op het werk uitvoeren. Maar natuurlijk is dit geen nuttige vergelijking en vertelt het ons niet veel over de economische impact van AI. We zijn niets zonder onze hulpmiddelen.

En toch zijn veel voorspellingen over de impact van "AGI" gebaseerd op hypothetische vergelijkingen tussen mensen en AI, waarbij de mensen toegang hebben tot het internet maar geen toegang tot AI. Dit soort vergelijking is even irrelevant.

De echte vraag is mensen + AI versus AI alleen. In zo'n vergelijking zal AI niet beter presteren dan menselijke-AI paren, behalve in smalle, computationeel zware domeinen zoals spellen waar snelheid van het grootste belang is en het hebben van een mens in het plaatje alleen maar alles vertraagt.*

Dus of AI mensen zal vervangen, hangt af van factoren die verder gaan dan nauwkeurigheid — dingen zoals verantwoordelijkheid, het vermogen om onbekende onbekenden te hanteren, en de mogelijke voorkeuren van klanten en andere werknemers om met een mens te interageren, alles afgewogen tegen de kosten van het in dienst nemen van een mens.

Dit wil niet zeggen dat AI geen banen zal verdringen. Maar kijken naar capaciteitsbenchmarks en direct doorgaan naar claims over banenverlies is volkomen naïef.

* Er zijn veel studies waarin werknemers AI te vaak onterecht overrulen, maar dat komt omdat ze geen training hebben gekregen in wanneer ze moeten overrulen en wanneer niet, wat een essentiële vaardigheid is in AI-ondersteunde workflows.

12,64K

Arvind Narayanan heeft opnieuw gepost

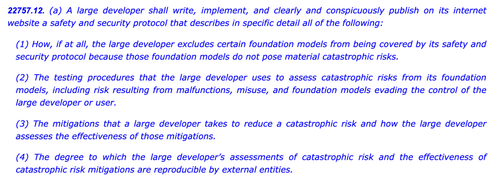

SB1047 was een slecht idee. Maar de laatste SB53 van senator Wiener is de goede kant op, en het is belangrijk om de vooruitgang te benoemen. Hier is mijn redenatie.

Mijn benadering van het reguleren van nieuwe technologieën zoals modellen is: we weten niet hoe we "goede" mitigatie en waarborging moeten definiëren, maar we zullen het weten wanneer—en als—we het zien.

Er zijn twee implicaties.

#1. We zouden geen risicodrempels of zorgstandaarden voor modelontwikkeling moeten voorschrijven. We kunnen het niet eens worden over de risico's die ertoe doen, hoe we ze moeten meten, of hoeveel te veel is. De enige richtlijn voor ontwikkelaars, regelgevers en rechtbanken is een set van opkomende praktijken die voornamelijk zijn bepaald door gesloten bedrijven die afhankelijk zijn van betaalmuren om het zware werk te doen. Dit zou open innovatie kunnen afschrikken door ontwikkelaars bloot te stellen aan vage of verhoogde aansprakelijkheid voor wijdverspreide releases.

Dat was SB1047 in een notendop, samen met ~5 equivalente voorstellen die het deze sessie in de VS hebben geïnspireerd, zoals de RAISE Act in NY. We zouden die aanpak moeten vermijden. Deze voorstellen zijn—in smalle maar cruciale opzichten—te ver over hun skis gegaan.

En toch:

#2. We moeten een licht werpen op de praktijken in de industrie om beter te begrijpen welke zorgvuldigheid, of het gebrek daaraan, door verschillende bedrijven wordt toegepast. Als ontwikkelaars zich moeten committeren aan een veiligheids- en beveiligingsbeleid, hun werkwijze moeten tonen en een papieren spoor moeten achterlaten, kunnen we beter de sterkte van hun claims beoordelen, monitoren op opkomende risico's en beslissen over toekomstige interventie.

Dat is de AI-wet van de EU en de definitieve gedragscode in een notendop, die zowel OpenAI als Mistral hebben goedgekeurd, en het is ook de laatste versie van SB53 van @Scott_Wiener.

Als we modelontwikkeling gaan reguleren, is dat fundamenteel de betere aanpak: reguleren van transparantie—niet van capaciteiten, mitigaties of acceptabel risico. Het zou tenminste één Amerikaanse jurisdictie de toezichthoudende autoriteit van Brussel geven, en het zou onbedoelde effecten op open ontwikkeling vermijden.

Om duidelijk te zijn, er zijn nog steeds ijsbergen voor ons:

> Complexiteit. Of het nu Big Tech is of niet, dit zijn zware documentatie- en rapportageverplichtingen. Tactisch gezien, hoe complexer, hoe kwetsbaarder dit wetsvoorstel zal worden.

> Prikkels. Verplichte openbare rapportage van vrijwillige risico-evaluaties creëert een perverse prikkel voor ontwikkelaars om hun modellen minder te testen en moeilijke risico's te negeren. Ontwikkelaars toestaan om hun resultaten aan auditors of instanties bekend te maken in plaats van openbaar kan helpen om grotere openhartigheid in hun interne beoordelingen te bevorderen.

> Trojan horse. De hyperactieve cultuur van California van het afschaffen en aanpassen kan het moeilijk maken om deze wetsvoorstellen te beoordelen. Als SB53 verandert in een zorgstandaardwet zoals SB1047 of RAISE, moet het om dezelfde redenen als voorheen worden afgewezen. Hoe meer versieringen aan deze kerstboom worden toegevoegd, hoe controversiëler het wetsvoorstel.

> Breedte. Het wetsvoorstel werpt een breed net met uitgebreide definities van catastrofaal risico en gevaarlijke capaciteiten. Voor een "verplicht rapporteren / vrijwillige praktijken" wetsvoorstel werken ze. Als dit wetsvoorstel een zorgstandaardwet was, zouden ze onuitvoerbaar zijn.

Samenvattend: hoed af voor senator Wiener voor het doordacht omgaan met en reageren op feedback het afgelopen jaar. Het is verfrissend om een wetsvoorstel te zien dat daadwerkelijk voortbouwt op eerdere kritiek. Er zijn nog veel paden die dit wetsvoorstel kan inslaan—en het is goed geëvolueerd voorbij het oorspronkelijke klokkenluidervoorstel—maar de koers is veelbelovend.

5,98K

Arvind Narayanan heeft opnieuw gepost

Voor degenen die zich afvragen wat hier technisch gezien aan de hand is, een uitleg:

Wanneer er veel trainingsdata is met een bepaalde stijl, zal het gebruik van een vergelijkbare stijl in je prompt de LLM aanzetten om in die stijl te reageren. In dit geval is er VEEL fanfic:

🧵

180,26K

Arvind Narayanan heeft opnieuw gepost

Nieuwe post: Datacenter Illusies

Onder de middelgrote machten heeft de VAE de duidelijkste AI-strategie: een 'AI-olie staat' worden met een betekenisvol wereldwijd computeraandeel. De meeste andere landen bouwen datacenters zonder haalbare soevereiniteit drempels te targeten.

🧵

10,03K

Boven

Positie

Favorieten

Populair op onchain

Populair op X

Recente topfinanciering

Belangrijkste