Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Arvind Narayanan

Princeton CS Prof. Direktor @PrincetonCITP. Ich verwende X, um meine Forschung und Kommentare zu den gesellschaftlichen Auswirkungen von KI zu teilen.

BUCH: AI Snake Oil. Ansichten meine.

Arvind Narayanan erneut gepostet

🧠Neu auf dem CITP-Blog von Doktorand Boyi Wei (@wei_boyi) vom POLARIS-Labor: "Die 'Blase' des Risikos: Verbesserung der Bewertungen für offensive Cybersecurity-Agenten"

Erfahren Sie, wie Gegner Open-Source-Modelle anpassen und modifizieren können, um Sicherheitsvorkehrungen zu umgehen. 👇

2,61K

Zurück in der Graduiertenschule, als ich erkannte, wie der "Marktplatz der Ideen" tatsächlich funktioniert, fühlte es sich an, als hätte ich die Cheat-Codes für eine Forschungskarriere gefunden. Heute ist das der wichtigste Stoff, den ich den Studenten beibringe, mehr als alles, was mit dem Inhalt unserer Forschung zu tun hat.

Eine kurze Vorbemerkung: Wenn ich von Forschungserfolg spreche, meine ich nicht, viele Artikel zu veröffentlichen. Die meisten veröffentlichten Artikel verstauben, weil es in jedem Bereich zu viel Forschung gibt, als dass die Leute darauf achten würden. Und insbesondere angesichts der Leichtigkeit, mit der Preprints veröffentlicht werden, muss Forschung nicht offiziell veröffentlicht werden, um erfolgreich zu sein. Während Veröffentlichungen also eine Voraussetzung für den beruflichen Aufstieg sein können, sollten sie nicht das Ziel sein. Für mich ist Forschungserfolg die Urheberschaft von Ideen, die Ihre Kollegen beeinflussen und die Welt zu einem besseren Ort machen.

Die grundlegende Erkenntnis ist also, dass zu viele Ideen in den Marktplatz der Ideen eintreten, und wir müssen verstehen, welche davon einflussreich werden. Die gute Nachricht ist, dass Qualität zählt – bei gleichen Bedingungen wird bessere Forschung erfolgreicher sein. Die schlechte Nachricht ist, dass Qualität nur schwach mit Erfolg korreliert, und es gibt viele andere Faktoren, die wichtig sind.

Zuerst, geben Sie sich mehrere Chancen. Die Rolle des Glücks ist ein regelmäßiges Thema in meinen Karriere-Ratschlägen. Es stimmt, dass Glück eine große Rolle dabei spielt, welche Artikel erfolgreich sind, aber das bedeutet nicht, sich ihm zu ergeben. Sie können Ihre "Glücksoberfläche" vergrößern.

Wenn Sie beispielsweise immer Preprints veröffentlichen, haben Sie mehrere Chancen, dass Ihre Arbeit bemerkt wird: einmal mit dem Preprint und einmal mit der Veröffentlichung (außerdem, wenn Sie in einem Bereich mit großen Veröffentlichungsverzögerungen sind, können Sie sicherstellen, dass die Forschung nicht überholt oder irrelevant ist, wenn sie veröffentlicht wird).

Allgemeiner gesagt, behandeln Sie Forschungsprojekte wie Startups – akzeptieren Sie, dass es eine sehr hohe Varianz in den Ergebnissen gibt, wobei einige Projekte 10x oder 100x erfolgreicher sind als andere. Das bedeutet, viele verschiedene Dinge auszuprobieren, große Risiken einzugehen, bereit zu sein, das zu verfolgen, was Ihre Kollegen für schlechte Ideen halten, aber mit einer Vorstellung davon, warum Sie möglicherweise dort erfolgreich sein könnten, wo andere zuvor gescheitert sind. Wissen Sie etwas, das andere nicht wissen, oder wissen sie etwas, das Sie nicht wissen? Und wenn Sie herausfinden, dass es letzteres ist, müssen Sie bereit sein, das Projekt schnell abzubrechen, ohne dem Sunk-Cost-Fehlschluss zum Opfer zu fallen.

Um klarzustellen, Erfolg hängt nicht nur vom Glück ab – Qualität und Tiefe sind sehr wichtig. Und es dauert einige Jahre Forschung, um tief in ein Thema einzutauchen. Aber mehrere Jahre mit der Forschung zu einem Thema zu verbringen, bevor Sie etwas veröffentlichen, ist extrem riskant, insbesondere zu Beginn Ihrer Karriere. Die Lösung ist einfach: Verfolgen Sie Projekte, nicht Probleme.

Projekte sind langfristige Forschungsagenden, die 3-5 Jahre oder länger dauern. Ein produktives Projekt könnte leicht ein Dutzend oder mehr Artikel produzieren (je nach Fachgebiet). Warum Projekte statt Probleme wählen? Wenn Ihre Methode darin besteht, von Problem zu Problem zu springen, sind die resultierenden Artikel wahrscheinlich etwas oberflächlich und haben möglicherweise nicht viel Einfluss. Und zweitens, wenn Sie bereits für Artikel zu einem bestimmten Thema bekannt sind, werden die Leute eher auf Ihre zukünftigen Artikel zu diesem Thema achten. (Ja, der Ruf des Autors zählt viel. Jede egalitäre Vorstellung davon, wie Menschen auswählen, was sie lesen, ist ein Mythos.)

Zusammenfassend arbeite ich normalerweise an 2-3 langfristigen Projekten gleichzeitig, und innerhalb jedes Projekts gibt es viele Probleme, die untersucht werden, und viele Artikel, die in verschiedenen Phasen der Pipeline produziert werden.

Der schwierigste Teil ist zu wissen, wann man ein Projekt beenden sollte. In dem Moment, in dem Sie ein neues Projekt in Betracht ziehen, vergleichen Sie etwas, das einige Jahre braucht, um wirklich Früchte zu tragen, mit einem Thema, in dem Sie bereits sehr produktiv sind. Aber Sie müssen etwas beenden, um Platz für etwas Neues zu schaffen. Zu einem richtigen Zeitpunkt aufzugeben, fühlt sich immer an, als würde man zu früh aufgeben. Wenn Sie auf Ihr Bauchgefühl hören, werden Sie viel zu lange im selben Forschungsbereich bleiben.

Schließlich, bauen Sie Ihre eigene Verteilung auf. In der Vergangenheit diente die offizielle Veröffentlichung eines Artikels zwei Zwecken: um ihm die Glaubwürdigkeit zu verleihen, die aus der Peer-Review resultiert, und um den Artikel an Ihre Kollegen zu verteilen. Jetzt sind diese beiden Funktionen vollständig getrennt. Die Veröffentlichung bringt immer noch Glaubwürdigkeit, aber die Verteilung liegt fast vollständig bei Ihnen!

Deshalb ist soziale Medien so wichtig. Leider führen soziale Medien zu ungesunden Anreizen, Ihre Ergebnisse zu übertreiben, weshalb ich Blogs/Newsletter und lange Videos als viel bessere Kanäle empfinde. Wir befinden uns in einem zweiten goldenen Zeitalter des Bloggens, und es gibt einen extremen Mangel an Menschen, die in der Lage sind, bahnbrechende Forschung aus ihren Disziplinen auf eine zugängliche Weise zu erklären, ohne sie wie in Pressemitteilungen oder Nachrichtenartikeln zu simplifizieren. Es ist nie zu früh – ich habe während meiner Promotion einen Blog gestartet, und er spielte eine große Rolle bei der Verbreitung meiner Doktorarbeit, sowohl innerhalb meiner Forschungscommunity als auch außerhalb.

36,36K

Arvind Narayanan erneut gepostet

Experten für Körperdysmorphe Störung haben gewarnt, dass Menschen, die damit kämpfen, zunehmend von KI-Chatbots abhängig geworden sind, um ihre selbstwahrgenommenen Mängel zu bewerten und kosmetische Operationen zu empfehlen. "Es kommt in fast jeder Sitzung vor", sagt mir ein Therapeut.

106,83K

Wenn wir die Fähigkeiten von KI mit Menschen vergleichen, die keinen Zugang zu Werkzeugen haben, wie zum Beispiel dem Internet, würden wir wahrscheinlich feststellen, dass KI bereits in vielen oder den meisten kognitiven Aufgaben, die wir bei der Arbeit ausführen, besser abschneidet als Menschen. Aber natürlich ist dies kein hilfreicher Vergleich und sagt uns nicht viel über die wirtschaftlichen Auswirkungen von KI. Wir sind nichts ohne unsere Werkzeuge.

Und doch basieren viele Vorhersagen über die Auswirkungen von "AGI" auf hypothetischen Vergleichen zwischen Menschen und KI, bei denen die Menschen Zugang zum Internet, aber keinen Zugang zu KI haben. Diese Art von Vergleich ist ebenso irrelevant.

Die eigentliche Frage ist Menschen + KI vs. KI allein. In einem solchen Vergleich wird KI nicht besser abschneiden als Mensch-KI-Paare, außer in engen, rechenintensiven Bereichen wie Spielen, wo Geschwindigkeit entscheidend ist und die Anwesenheit eines Menschen die Dinge nur verlangsamt.*

Ob KI Menschen ersetzen wird oder nicht, hängt von Faktoren ab, die über die Genauigkeit hinausgehen – Dinge wie Verantwortlichkeit, die Fähigkeit, mit unbekannten Unbekannten umzugehen, und die potenziellen Vorlieben von Kunden und anderen Mitarbeitern, mit einem Menschen zu interagieren, alles abgewogen gegen die Kosten für die Beschäftigung eines Menschen.

Das soll nicht heißen, dass KI keine Arbeitsplätze verdrängen wird. Aber die Betrachtung von Fähigkeitsbenchmarks und das direkte Übergehen zu Behauptungen über Arbeitsplatzverluste ist völlig naiv.

* Es gibt viele Studien, in denen Arbeiter KI zu oft falsch übersteuern, aber das liegt daran, dass sie keine Schulung erhalten haben, wann sie übersteuern und wann nicht, was eine wesentliche Fähigkeit in KI-gestützten Arbeitsabläufen ist.

12,61K

Arvind Narayanan erneut gepostet

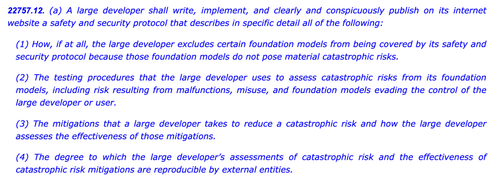

SB1047 war eine schlechte Idee. Aber Sen. Wieners neuestes SB53 ist auf dem richtigen Weg, und es ist wichtig, den Fortschritt zu würdigen. Hier ist meine Begründung.

Mein Ansatz zur Regulierung neuartiger Technologien wie Modelle ist: Wir wissen nicht, wie wir "gute" Minderung und Gewährleistung definieren sollen, aber wir werden es wissen, wenn – und falls – wir es sehen.

Es gibt zwei Implikationen.

#1. Wir sollten keine Risikoschwellen oder Standards für die Entwicklung von Modellen vorschreiben. Wir können uns nicht auf die Risiken einigen, die wichtig sind, wie man sie misst oder wie viel zu viel ist. Die einzige Anleitung für Entwickler, Regulierungsbehörden und Gerichte ist eine Reihe von aufkeimenden Praktiken, die hauptsächlich von geschlossenen Firmen bestimmt werden, die sich auf Bezahlschranken stützen, um die schwere Arbeit zu leisten. Dies könnte die offene Innovation ersticken, indem es Entwickler vagen oder erhöhten Haftungsansprüchen für eine weit verbreitete Veröffentlichung aussetzt.

Das war SB1047 in einer Nussschale, zusammen mit ~5 Äquivalenten, die es in dieser Sitzung in den USA inspiriert hat, wie dem RAISE-Gesetz in NY. Wir sollten diesen Ansatz vermeiden. Diese Vorschläge sind – in engen, aber entscheidenden Aspekten – zu weit über das Ziel hinausgeschossen.

Und doch:

#2. Wir müssen die Praktiken der Branche beleuchten, um besser zu verstehen, welche Sorgfalt, oder deren Fehlen, von verschiedenen Firmen angewendet wird. Wenn Entwickler sich zu einer Sicherheits- und Sicherheitsrichtlinie verpflichten, ihre Arbeitsweise zeigen und eine Dokumentation hinterlassen müssen, können wir die Stärke ihrer Ansprüche besser bewerten, auf aufkommende Risiken überwachen und über zukünftige Interventionen entscheiden.

Das ist das EU-AI-Gesetz und der endgültige Verhaltenskodex in einer Nussschale, den sowohl OpenAI als auch Mistral unterstützt haben, und es ist auch die neueste Version von SB53 von @Scott_Wiener.

Wenn wir die Entwicklung von Modellen regulieren wollen, ist das grundsätzlich der bessere Ansatz: Transparenz regulieren – nicht Fähigkeiten, Minderung oder akzeptables Risiko. Es würde zumindest einer US-Jurisdiktion die Aufsichtsbehörde von Brüssel geben und unbeabsichtigte Auswirkungen auf die offene Entwicklung vermeiden.

Um klarzustellen, es gibt immer noch Eisberge vor uns:

> Komplexität. Egal ob Big Tech oder nicht, dies sind belastende Dokumentations- und Berichtspflichten. Taktisch gesprochen, je komplexer, desto anfälliger wird dieses Gesetz.

> Anreize. Die verpflichtende öffentliche Berichterstattung über freiwillige Risikobewertungen schafft einen perversen Anreiz für Entwickler, ihre Modelle zu wenig zu testen und schwierige Risiken zu ignorieren. Entwicklern zu erlauben, ihre Ergebnisse Auditoren oder Behörden anstelle der Öffentlichkeit offenzulegen, könnte helfen, größere Offenheit in ihren internen Bewertungen zu fördern.

> Trojanisches Pferd. Kaliforniens hyperaktive Kultur des „Durchwühlens und Änderens“ kann es schwierig machen, diese Gesetze zu prüfen. Wenn SB53 sich in ein Standardgesetz wie SB1047 oder RAISE verwandelt, sollte es aus den gleichen Gründen wie zuvor zurückgewiesen werden. Je mehr Schmuckstücke zu diesem Weihnachtsbaum hinzugefügt werden, desto umstrittener wird das Gesetz.

> Breite. Das Gesetz wirft ein weites Netz mit weitreichenden Definitionen von katastrophalen Risiken und gefährlichen Fähigkeiten. Für ein "verpflichtendes Berichtswesen / freiwillige Praktiken"-Gesetz funktionieren sie. Wenn dieses Gesetz ein Standardgesetz wäre, wären sie nicht umsetzbar.

Zusammenfassend: Hut ab vor Sen. Wiener für sein durchdachtes Engagement und seine Reaktion auf Feedback im vergangenen Jahr. Es ist erfrischend, ein Gesetz zu sehen, das tatsächlich auf früherer Kritik aufbaut. Es gibt immer noch viele Wege, die dieses Gesetz einschlagen könnte – und es hat sich weit über den ursprünglichen Whistleblowing-Vorschlag hinaus entwickelt – aber die Richtung ist vielversprechend.

5,97K

Arvind Narayanan erneut gepostet

Für diejenigen, die sich fragen, was hier technisch passiert, eine Erklärung:

Wenn es viele Trainingsdaten mit einem bestimmten Stil gibt, wird die Verwendung eines ähnlichen Stils in deinem Prompt das LLM dazu bringen, in diesem Stil zu antworten. In diesem Fall gibt es jede Menge Fanfiction:

🧵

180,2K

Wir selbst sind begeisterte Nutzer von KI in unseren wissenschaftlichen Arbeitsabläufen. Im Alltag fühlt sich das alles sehr aufregend an. Aber die Auswirkungen von KI auf die Wissenschaft als Institution, und nicht auf einzelne Wissenschaftler, sind eine andere Frage, die eine andere Art von Analyse erfordert. Das Schreiben dieses Essays erforderte in vielen Fällen, unsere eigenen Intuitionen zu hinterfragen. Wenn Sie ein Wissenschaftler sind, der ebenfalls begeistert ist, diese Werkzeuge zu nutzen, fordern wir Sie auf, diesen Unterschied im Hinterkopf zu behalten.

Kann KI die Wissenschaft verlangsamen? Konfrontation mit dem Produktions-Fortschritts-Paradoxon

Die Tragödie ist, dass es viele KI-für-Wissenschaft-Werkzeuge gibt, die einen echten Unterschied machen würden, wie KI zur Kennzeichnung potenzieller Fehler im wissenschaftlichen Code. Aber die Labore sind auf andere Dinge fixiert, wie Literaturüberprüfung / "tiefe Forschung". Das ist kein tatsächlicher Engpass, also spielt es keine Rolle, wie viel schneller man es macht. In der Zwischenzeit sind die Risiken, das menschliche Verständnis zu kurzschließen, enorm.

Evals sind Teil des Problems. Es gibt drei Arten von Fragen, die man zu einem Literaturüberprüfungstool stellen kann: Spart es einem Forscher Zeit und liefert Ergebnisse von vergleichbarer Qualität zu bestehenden Werkzeugen? Wie wirkt sich die Nutzung des Werkzeugs auf das Verständnis des Forschers über die Literatur im Vergleich zur traditionellen Suche aus? Was werden die kollektiven Auswirkungen auf die Gemeinschaft sein, wenn das Werkzeug weit verbreitet angenommen wird? Zum Beispiel, werden am Ende alle die gleichen wenigen Arbeiten zitieren?

Derzeit wird nur die erste Frage als Teil dessen betrachtet, was Evaluation bedeutet. Die letzten beiden sind nicht im Umfang, und es gibt nicht einmal etablierte Methoden oder Metriken für eine solche Messung. Das bedeutet, dass die Evaluation von KI-für-Wissenschaft garantiert ein stark unvollständiges und voreingenommenes Bild von der Nützlichkeit dieser Werkzeuge liefert und ihre potenziellen Schäden minimiert.

Letztendlich kommt es auf die durcheinandergebrachten Anreize der KI-für-Wissenschaft-Labore an, insbesondere derjenigen in großen KI-Unternehmen. Sie wollen auffällige „KI entdeckt X!“-Schlagzeilen, damit sie die Erzählung aufrechterhalten können, dass KI die Probleme der Menschheit lösen wird, was ihnen eine günstige politische Behandlung einbringt. Wir halten nicht den Atem an, dass sich dies ändern wird.

Aber ein Bewusstsein dafür, dass etwas ernsthaft falsch ist mit dem aktuellen Kurs, ist ein guter erster Schritt, und das ist das Ziel dieses Essays von @sayashk und mir.

6,35K

Arvind Narayanan erneut gepostet

Neuer Beitrag: Datacenter-Illusionen

Unter den mittelgroßen Mächten hat die VAE die klarste KI-Strategie: ein 'KI-Ölstaat' zu werden mit einem bedeutenden globalen Rechenanteil. Die meisten anderen Länder bauen Rechenzentren, ohne tragfähige Souveränitätsgrenzen anzustreben.

🧵

10K

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten