Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Arvind Narayanan

Princeton CS prof. Direttore @PrincetonCITP. Uso X per condividere le mie ricerche e i miei commenti sull'impatto sociale dell'IA.

LIBRO: Olio di serpente AI. Viste mie.

Arvind Narayanan ha ripubblicato

🧠Nuovo sul blog CITP dallo studente di dottorato Boyi Wei (@wei_boyi) del POLARIS Lab: "La 'Bolla' del Rischio: Migliorare le Valutazioni per gli Agenti di Cybersecurity Offensiva"

Leggi come gli avversari possono adattare e modificare modelli open-source per eludere le misure di sicurezza. 👇

2,97K

Tornando ai tempi della scuola di specializzazione, quando ho capito come funziona realmente il "mercato delle idee", mi è sembrato di aver trovato i codici per barare in una carriera di ricerca. Oggi, queste sono le cose più importanti che insegno agli studenti, più di qualsiasi cosa relativa al contenuto della nostra ricerca.

Una breve prefazione: quando parlo di successo nella ricerca non intendo pubblicare molti articoli. La maggior parte degli articoli pubblicati raccoglie polvere perché ci sono troppi studi in qualsiasi campo perché le persone prestino attenzione. E soprattutto, data la facilità di pubblicare preprint, la ricerca non deve essere ufficialmente pubblicata per avere successo. Quindi, mentre le pubblicazioni possono essere un prerequisito per l'avanzamento di carriera, non dovrebbero essere l'obiettivo. Per me, il successo nella ricerca è l'autorialità di idee che influenzano i tuoi pari e rendono il mondo un posto migliore.

Quindi, l'intuizione di base è che ci sono troppe idee che entrano nel mercato delle idee, e dobbiamo capire quali di esse finiscono per essere influenti. La buona notizia è che la qualità conta: a parità di condizioni, una ricerca migliore avrà più successo. La cattiva notizia è che la qualità è solo debolmente correlata al successo, e ci sono molti altri fattori che contano.

Innanzitutto, dai a te stesso più opportunità. Il ruolo della fortuna è un tema ricorrente nei miei consigli di carriera. È vero che la fortuna conta molto nel determinare quali articoli hanno successo, ma ciò non significa rassegnarsi ad essa. Puoi aumentare la tua "superficie di fortuna".

Ad esempio, se pubblichi sempre preprint, hai più possibilità che il tuo lavoro venga notato: una volta con il preprint e una volta con la pubblicazione (inoltre, se sei in un campo con grandi ritardi di pubblicazione, puoi assicurarti che la ricerca non venga anticipata o diventi irrilevante nel momento in cui esce).

Più in generale, tratta i progetti di ricerca come startup: accetta che ci sia una variabilità molto alta nei risultati, con alcuni progetti che sono 10x o 100x più riusciti di altri. Questo significa provare molte cose diverse, prendere grandi rischi, essere disposti a perseguire ciò che i tuoi pari considerano cattive idee, ma con un'idea di perché potresti avere successo dove altri prima di te hanno fallito. Sai qualcosa che gli altri non sanno, o loro sanno qualcosa che tu non sai? E se scopri che è quest'ultima, devi essere disposto a chiudere rapidamente il progetto, senza cadere nella trappola del costo irrimediabile.

Per essere chiari, il successo non dipende solo dalla fortuna: la qualità e la profondità contano molto. E ci vogliono alcuni anni di ricerca per approfondire un argomento. Ma trascorrere alcuni anni a ricercare un argomento prima di pubblicare qualsiasi cosa è estremamente rischioso, soprattutto all'inizio della tua carriera. La soluzione è semplice: persegui progetti, non problemi.

I progetti sono agende di ricerca a lungo termine che durano 3-5 anni o più. Un progetto produttivo potrebbe facilmente produrre una dozzina o più di articoli (a seconda del campo). Perché scegliere progetti invece di problemi? Se il tuo metodo è saltare da un problema all'altro, gli articoli risultanti saranno probabilmente superficiali e potrebbero non avere molto impatto. E in secondo luogo, se sei già conosciuto per articoli su un argomento particolare, le persone sono più propense a prestare attenzione ai tuoi futuri articoli su quell'argomento. (Sì, la reputazione dell'autore conta molto. Qualsiasi nozione egalitaria di come le persone scelgono cosa leggere è un mito.)

Per riassumere, di solito lavoro su 2-3 progetti a lungo termine alla volta, e all'interno di ogni progetto ci sono molti problemi in fase di indagine e molti articoli prodotti a vari stadi della pipeline.

La parte più difficile è sapere quando terminare un progetto. Nel momento in cui stai considerando un nuovo progetto, stai confrontando qualcosa che richiederà alcuni anni per realizzarsi davvero con un argomento in cui sei già altamente produttivo. Ma devi terminare qualcosa per fare spazio a qualcosa di nuovo. Abbandonare al momento giusto sembra sempre abbandonare troppo presto. Se segui il tuo istinto, rimarrai nella stessa area di ricerca per troppo tempo.

Infine, costruisci la tua distribuzione. In passato, la pubblicazione ufficiale di un articolo serviva a due scopi: dare credibilità che deriva dalla revisione paritaria e distribuire l'articolo ai tuoi pari. Ora queste due funzioni sono state completamente separate. La pubblicazione porta ancora credibilità, ma la distribuzione è quasi interamente nelle tue mani!

Ecco perché i social media contano così tanto. Sfortunatamente, i social media introducono incentivi malsani a esagerare i tuoi risultati, quindi trovo che blog/newsletter e video di lunga durata siano canali molto migliori. Siamo in una seconda età dell'oro del blogging e c'è una carenza estrema di persone che possono spiegare ricerche all'avanguardia dalle loro discipline in modo accessibile ma senza semplificarle come nei comunicati stampa o negli articoli di notizie. Non è mai troppo presto: ho iniziato un blog durante il mio dottorato e ha giocato un ruolo importante nella diffusione della mia ricerca dottorale, sia all'interno della mia comunità di ricerca che al di fuori di essa.

Riepilogo

* Il successo nella ricerca non significa solo pubblicazione

* Il mercato delle idee è saturo

* Dai a te stesso più opportunità

* Scegli progetti, non problemi

* Tratta i progetti come startup

* Costruisci la tua distribuzione.

39,6K

Arvind Narayanan ha ripubblicato

Gli esperti sul disturbo dismorfico corporeo hanno avvertito che le persone che ne soffrono sono diventate sempre più dipendenti dai chatbot AI per valutare i propri difetti percepiti e raccomandare interventi di chirurgia estetica. "Sta quasi emergendo in ogni singola seduta," mi dice un terapeuta.

106,83K

Se confrontassimo le capacità dell'IA con quelle degli esseri umani senza accesso a strumenti, come internet, probabilmente scopriremmo che l'IA ha già superato gli esseri umani in molti o nella maggior parte dei compiti cognitivi che svolgiamo al lavoro. Ma ovviamente questo non è un confronto utile e non ci dice molto sugli impatti economici dell'IA. Non siamo nulla senza i nostri strumenti.

Eppure, molte previsioni sull'impatto dell'"AGI" si basano su confronti ipotetici tra umani e IA in cui gli esseri umani hanno accesso a internet ma non all'IA. Questo tipo di confronto è altrettanto irrilevante.

La vera domanda è umani + IA contro IA da sola. In un tale confronto, l'IA non supererà le coppie umani-IA, tranne che in ambiti ristretti e computazionalmente pesanti come i giochi, dove la velocità è fondamentale e avere un umano in gioco rallenta solo le cose.*

Quindi, se l'IA sostituirà o meno gli esseri umani dipende da fattori oltre l'accuratezza: cose come responsabilità, la capacità di gestire gli sconosciuti sconosciuti e le potenziali preferenze dei clienti e di altri lavoratori di interagire con un umano, tutto pesato rispetto al costo di impiegare un umano.

Questo non significa che l'IA non sposterà posti di lavoro. Ma guardare ai benchmark delle capacità e passare direttamente a affermazioni sulla perdita di posti di lavoro è completamente ingenuo.

* Ci sono molti studi in cui i lavoratori sovrascrivono erroneamente l'IA troppo spesso, ma questo è perché non hanno ricevuto alcuna formazione su quando sovrascrivere e quando non farlo, che è un'abilità essenziale nei flussi di lavoro abilitati all'IA.

12,61K

Arvind Narayanan ha ripubblicato

SB1047 era una cattiva idea. Ma l'ultimo SB53 del Sen. Wiener è sulla strada giusta, ed è importante riconoscere i progressi. Ecco il mio ragionamento.

Il mio approccio alla regolamentazione di tecnologie nuove come i modelli è: non sappiamo come definire una mitigazione e una garanzia "buone", ma lo sapremo quando—e se—lo vedremo.

Ci sono due implicazioni.

#1. Non dovremmo prescrivere soglie di rischio o standard di cura per lo sviluppo dei modelli. Non possiamo concordare sui rischi che contano, su come misurarli o su quanto sia troppo. L'unica guida per sviluppatori, regolatori e tribunali è un insieme di pratiche nascenti determinate principalmente da aziende a codice chiuso che si affidano a paywall per fare il lavoro pesante. Farlo potrebbe frenare l'innovazione aperta esponendo gli sviluppatori a responsabilità vaghe o elevate per il rilascio diffuso.

Questo era SB1047 in poche parole, insieme a ~5 equivalenti che ha ispirato in tutto il paese in questa sessione, come il RAISE Act a NY. Dovremmo evitare questo approccio. Queste proposte sono—in aspetti ristretti ma cruciali—troppo oltre le loro possibilità.

Eppure:

#2. Dobbiamo far luce sulle pratiche del settore per comprendere meglio la diligenza, o la mancanza di essa, applicata da diverse aziende. Se gli sviluppatori devono impegnarsi a una politica di sicurezza e protezione, mostrare il loro operato e lasciare una traccia cartacea, possiamo valutare meglio la solidità delle loro affermazioni, monitorare i rischi emergenti e decidere su future interventi.

Questo è l'AI Act dell'UE e il Codice di Pratica finale in poche parole, che sia OpenAI che Mistral hanno sostenuto, ed è anche l'ultima versione del SB53 di @Scott_Wiener.

Se dobbiamo regolare lo sviluppo dei modelli, questo è fondamentalmente l'approccio migliore: regolare la trasparenza—non le capacità, le mitigazioni o il rischio accettabile. Darebbe almeno a una giurisdizione statunitense l'autorità di supervisione di Bruxelles, e eviterebbe effetti indesiderati sullo sviluppo aperto.

Per essere chiari, ci sono ancora iceberg davanti:

> Complessità. Che si tratti di Big Tech o meno, questi sono obblighi di documentazione e reporting gravosi. Parlando tatticamente, più è complesso, più vulnerabile diventerà questo progetto di legge.

> Incentivi. La segnalazione pubblica obbligatoria delle valutazioni di rischio volontarie crea un incentivo perverso per gli sviluppatori a testare meno i loro modelli e a chiudere un occhio sui rischi difficili. Permettere agli sviluppatori di divulgare i loro risultati a revisori o agenzie piuttosto che pubblicamente potrebbe aiutare a promuovere una maggiore franchezza nelle loro valutazioni interne.

> Cavallo di Troia. La cultura iperattiva di modifica e emendamento della California può rendere difficile esaminare questi progetti di legge. Se SB53 si trasforma in un progetto di legge sugli standard di cura come SB1047 o RAISE, dovrebbe essere respinto per le stesse ragioni di prima. Più decorazioni vengono aggiunte a questo albero di Natale, più il progetto di legge diventa controverso.

> Ampiezza. Il progetto di legge lancia una rete ampia con definizioni espansive di rischio catastrofico e capacità pericolosa. Per un progetto di legge "di reporting obbligatorio / pratiche volontarie", funzionano. Se questo progetto di legge fosse un progetto di legge sugli standard di cura, sarebbero inattuabili.

In sintesi: cappello a Sen. Wiener per aver coinvolto e risposto in modo ponderato ai feedback nell'ultimo anno. È rinfrescante vedere un progetto di legge che costruisce effettivamente su critiche precedenti. Ci sono ancora molti percorsi che questo progetto di legge potrebbe prendere—e si è evoluto ben oltre la proposta originale di whistleblowing—ma la traiettoria è promettente.

5,97K

Arvind Narayanan ha ripubblicato

Per coloro che si chiedono cosa stia succedendo qui tecnicamente, una spiegazione:

Quando ci sono molti dati di addestramento con uno stile particolare, utilizzare uno stile simile nel tuo prompt farà sì che il LLM risponda in quello stile. In questo caso, ci sono TANTISSIMI fanfic:

🧵

180,22K

Noi stessi siamo utenti entusiasti dell'IA nei nostri flussi di lavoro scientifici. Giorno dopo giorno, tutto sembra molto emozionante. Ma l'impatto dell'IA sulla scienza come istituzione, piuttosto che sugli scienziati individuali, è una questione diversa che richiede un'analisi differente. Scrivere questo saggio ha richiesto di combattere le nostre stesse intuizioni in molti casi. Se sei uno scienziato che è altrettanto entusiasta di utilizzare questi strumenti, ti esortiamo a tenere a mente questa differenza.

L'IA potrebbe rallentare la scienza? Affrontare il paradosso della produzione e del progresso.

La tragedia è che ci sono molti strumenti di IA per la scienza che farebbero una vera differenza, come l'IA per segnalare potenziali errori nel codice scientifico. Ma i laboratori sono fissati su altre cose come la revisione della letteratura / "ricerca approfondita". Questo non è un vero collo di bottiglia, quindi non importa quanto più veloce lo rendi. Nel frattempo, i rischi di cortocircuitare la comprensione umana sono enormi.

Le valutazioni sono parte del problema. Ci sono tre tipi di domande che si possono porre su uno strumento di revisione della letteratura: Risparmia tempo a un ricercatore e produce risultati di qualità comparabile rispetto agli strumenti esistenti? Come influisce l'uso dello strumento sulla comprensione della letteratura da parte del ricercatore rispetto alla ricerca tradizionale? Quali saranno gli impatti collettivi sulla comunità se lo strumento venisse adottato su larga scala? Ad esempio, tutti finiranno per citare gli stessi pochi articoli?

Attualmente, solo la prima domanda è considerata parte di ciò che significa valutazione. Le ultime due sono fuori portata, e non ci sono nemmeno metodi o metriche stabilite per tale misurazione. Ciò significa che la valutazione dell'IA per la scienza è garantita a fornire un quadro altamente incompleto e distorto dell'utilità di questi strumenti e a minimizzare i loro potenziali danni.

In definitiva, tutto si riduce agli incentivi distorti dei laboratori di IA per la scienza, specialmente quelli delle grandi aziende di IA. Vogliono titoli accattivanti "L'IA scopre X!" in modo da poter sostenere la narrazione che l'IA risolverà i problemi dell'umanità, il che garantisce loro un trattamento politico favorevole. Non ci aspettiamo che questo cambi.

Ma una consapevolezza che qualcosa non va seriamente con l'attuale traiettoria è un buon primo passo, e questo è l'obiettivo di questo saggio di @sayashk e me.

6,35K

Arvind Narayanan ha ripubblicato

Nuovo Post: Delusioni dei Datacenter

Tra le potenze medie, gli Emirati Arabi Uniti hanno la strategia di intelligenza artificiale più chiara: diventare uno "stato petrolifero dell'IA" con una quota significativa di calcolo globale. La maggior parte degli altri paesi sta costruendo datacenter senza mirare a soglie di sovranità praticabili.

🧵

10K

Arvind Narayanan ha ripubblicato

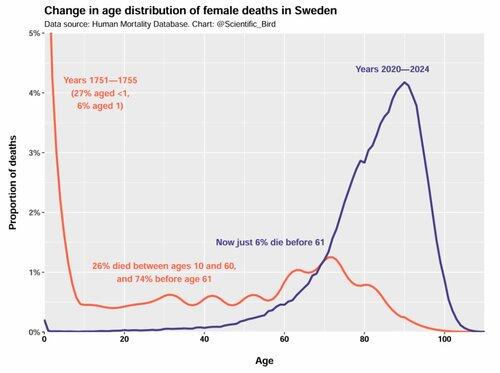

Nel XVIII secolo, c'era una reale possibilità di morte in qualsiasi momento della vita, e non c'era un grande picco in età avanzata.

Non si trattava solo di una maggiore mortalità infantile: l'intera distribuzione era completamente diversa.

Ottimo grafico di @Scientific_Bird.

131,95K

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari