Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Arvind Narayanan

Princeton CS prof. Directeur @PrincetonCITP. J’utilise X pour partager mes recherches et mes commentaires sur l’impact sociétal de l’IA.

LIVRE : Huile de serpent AI. Vues les miennes.

Arvind Narayanan a reposté

🧠Nouveau sur le blog du CITP de l'étudiant en doctorat Boyi Wei (@wei_boyi) du laboratoire POLARIS : "La 'Bulle' de Risque : Améliorer les Évaluations pour les Agents de Cybersécurité Offensifs"

Lisez comment les adversaires peuvent adapter et modifier des modèles open-source pour contourner les protections. 👇

2,61K

De retour à l'école doctorale, quand j'ai réalisé comment le "marché des idées" fonctionne réellement, j'avais l'impression d'avoir trouvé les codes de triche pour une carrière en recherche. Aujourd'hui, c'est la chose la plus importante que j'enseigne aux étudiants, plus que tout ce qui est lié à la substance de notre recherche.

Une brève préface : quand je parle de succès en recherche, je ne veux pas dire publier beaucoup d'articles. La plupart des articles publiés prennent la poussière parce qu'il y a trop de recherches dans n'importe quel domaine pour que les gens y prêtent attention. Et surtout, étant donné la facilité de publier des prépublications, la recherche n'a pas besoin d'être officiellement publiée pour être réussie. Donc, bien que les publications puissent être un préalable à l'avancement de carrière, elles ne devraient pas être l'objectif. Pour moi, le succès en recherche est l'autorité d'idées qui influencent vos pairs et rendent le monde meilleur.

Ainsi, l'idée de base est qu'il y a trop d'idées entrant sur le marché des idées, et nous devons comprendre lesquelles finissent par être influentes. La bonne nouvelle est que la qualité compte — toutes choses étant égales par ailleurs, une meilleure recherche sera plus réussie. La mauvaise nouvelle est que la qualité est seulement faiblement corrélée avec le succès, et il y a de nombreux autres facteurs qui comptent.

Tout d'abord, donnez-vous plusieurs chances d'atteindre votre objectif. Le rôle de la chance est un thème récurrent de mes conseils de carrière. Il est vrai que la chance compte beaucoup dans la détermination des articles qui réussissent, mais cela ne signifie pas que vous devez vous y résigner. Vous pouvez augmenter votre "surface de chance".

Par exemple, si vous publiez toujours des prépublications, vous avez plusieurs occasions que votre travail soit remarqué : une fois avec la prépublication et une fois avec la publication (de plus, si vous êtes dans un domaine avec de grands délais de publication, vous pouvez vous assurer que la recherche n'est pas devancée ou devenue irrélevante au moment où elle sort).

Plus généralement, traitez les projets de recherche comme des startups — acceptez qu'il y ait une très grande variance dans les résultats, certains projets étant 10x ou 100x plus réussis que d'autres. Cela signifie essayer beaucoup de choses différentes, prendre de grands risques, être prêt à poursuivre ce que vos pairs considèrent comme de mauvaises idées, mais avec une idée de pourquoi vous pourriez potentiellement réussir là où d'autres avant vous ont échoué. Savez-vous quelque chose que les autres ne savent pas, ou savent-ils quelque chose que vous ne savez pas ? Et si vous découvrez que c'est la seconde option, vous devez être prêt à abandonner le projet rapidement, sans tomber dans le piège de la logique des coûts irrécupérables.

Pour être clair, le succès n'est pas uniquement dû à la chance — la qualité et la profondeur comptent beaucoup. Et il faut quelques années de recherche pour approfondir un sujet. Mais passer quelques années à rechercher un sujet avant de publier quoi que ce soit est extrêmement risqué, surtout au début de votre carrière. La solution est simple : poursuivez des projets, pas des problèmes.

Les projets sont des agendas de recherche à long terme qui durent 3 à 5 ans ou plus. Un projet productif pourrait facilement produire une douzaine ou plus d'articles (selon le domaine). Pourquoi choisir des projets plutôt que des problèmes ? Si votre méthode consiste à passer d'un problème à l'autre, les articles résultants seront probablement quelque peu superficiels et pourraient ne pas avoir beaucoup d'impact. Et deuxièmement, si vous êtes déjà connu pour des articles sur un sujet particulier, les gens sont plus susceptibles de prêter attention à vos futurs articles sur ce sujet. (Oui, la réputation de l'auteur compte beaucoup. Toute notion égalitaire de la façon dont les gens choisissent ce qu'ils lisent est un mythe.)

Pour résumer, je travaille généralement sur 2 à 3 projets à long terme à la fois, et au sein de chaque projet, il y a de nombreux problèmes en cours d'investigation et de nombreux articles produits à divers stades de la chaîne.

La partie la plus difficile est de savoir quand mettre fin à un projet. Au moment où vous envisagez un nouveau projet, vous comparez quelque chose qui prendra quelques années à vraiment se concrétiser avec un sujet où vous êtes déjà très productif. Mais vous devez mettre fin à quelque chose pour faire de la place à quelque chose de nouveau. Abandonner au bon moment donne toujours l'impression d'abandonner trop tôt. Si vous suivez votre instinct, vous resterez dans le même domaine de recherche beaucoup trop longtemps.

Enfin, construisez votre propre distribution. Dans le passé, la publication officielle d'un article servait deux objectifs : lui donner la crédibilité qui vient de l'évaluation par les pairs, et distribuer l'article à vos pairs. Maintenant, ces deux fonctions ont été complètement séparées. La publication apporte toujours de la crédibilité, mais la distribution dépend presque entièrement de vous !

C'est pourquoi les réseaux sociaux comptent tant. Malheureusement, les réseaux sociaux introduisent des incitations malsaines à exagérer vos résultats, donc je trouve que les blogs/newsletters et les vidéos longues sont de bien meilleures chaînes. Nous sommes dans un deuxième âge d'or du blogging et il y a une extrême pénurie de personnes capables d'expliquer des recherches de pointe de leurs disciplines de manière accessible sans les simplifier comme dans les communiqués de presse ou les articles d'actualité. Il n'est jamais trop tôt — j'ai commencé un blog pendant mon doctorat et cela a joué un grand rôle dans la diffusion de ma recherche doctorale, tant au sein de ma communauté de recherche qu'en dehors.

36,36K

Arvind Narayanan a reposté

Des experts sur le trouble dysmorphique corporel ont averti que les personnes qui en souffrent deviennent de plus en plus dépendantes des chatbots IA pour évaluer leurs défauts perçus et recommander des interventions esthétiques. "Cela apparaît presque dans chaque séance", me dit un thérapeute.

106,83K

Si nous comparions les capacités de l'IA à celles des humains sans accès à des outils, comme Internet, nous constaterions probablement que l'IA a déjà surpassé les humains dans de nombreuses tâches cognitives que nous effectuons au travail. Mais bien sûr, ce n'est pas une comparaison utile et cela ne nous dit pas grand-chose sur les impacts économiques de l'IA. Nous ne sommes rien sans nos outils.

Et pourtant, de nombreuses prédictions sur l'impact de "l'AGI" sont basées sur des comparaisons hypothétiques entre humains et IA dans lesquelles les humains ont accès à Internet mais pas à l'IA. Ce type de comparaison est tout aussi irrélevant.

La vraie question est : humains + IA contre IA seule. Dans une telle comparaison, l'IA ne va pas surpasser les paires humain-IA, sauf dans des domaines étroits et computationnellement lourds comme les jeux où la vitesse est primordiale et la présence d'un humain ne fait que ralentir les choses.*

Donc, que l'IA remplace ou non les humains dépend de facteurs au-delà de la précision — des choses comme la responsabilité, la capacité à gérer des inconnues inconnues, et les préférences potentielles des clients et d'autres travailleurs à interagir avec un humain, le tout pesé contre le coût d'employer un humain.

Cela ne veut pas dire que l'IA ne va pas déplacer des emplois. Mais regarder les références de capacité et aller directement aux affirmations sur la perte d'emplois est complètement naïf.

* Il existe de nombreuses études où les travailleurs contournent incorrectement l'IA trop souvent, mais c'est parce qu'ils n'ont reçu aucune formation sur quand contourner et quand ne pas le faire, ce qui est une compétence essentielle dans les flux de travail activés par l'IA.

12,61K

Arvind Narayanan a reposté

SB1047 était une mauvaise idée. Mais le dernier SB53 du Sénateur Wiener est sur la bonne voie, et il est important de souligner les progrès. Voici mon raisonnement.

Mon approche pour réguler des technologies nouvelles comme les modèles est la suivante : nous ne savons pas comment définir une atténuation et une assurance "bonnes", mais nous le saurons quand—et si—nous le verrons.

Il y a deux implications.

#1. Nous ne devrions pas prescrire des seuils de risque ou des normes de soins pour le développement de modèles. Nous ne pouvons pas nous mettre d'accord sur les risques qui comptent, comment les mesurer, ou combien est trop. La seule orientation pour les développeurs, les régulateurs et les tribunaux est un ensemble de pratiques naissantes déterminées principalement par des entreprises à code fermé s'appuyant sur des paywalls pour faire le gros du travail. Cela pourrait freiner l'innovation ouverte en exposant les développeurs à une responsabilité vague ou accrue pour une diffusion généralisée.

C'était SB1047 en résumé, ainsi que ~5 équivalents qu'il a inspirés à travers les États-Unis cette session, comme le RAISE Act à New York. Nous devrions éviter cette approche. Ces propositions sont—dans des aspects étroits mais cruciaux—trop loin de la réalité.

Et pourtant :

#2. Nous devons mettre en lumière les pratiques de l'industrie pour mieux comprendre la diligence, ou son absence, appliquée par différentes entreprises. Si les développeurs doivent s'engager à une politique de sécurité et de sûreté, montrer leur travail, et laisser une trace écrite, nous pouvons mieux évaluer la force de leurs revendications, surveiller les risques émergents, et décider d'une intervention future.

C'est l'Acte sur l'IA de l'UE et le Code de Pratique final en résumé, que OpenAI et Mistral ont tous deux soutenus, et c'est aussi la dernière version du SB53 de @Scott_Wiener.

Si nous allons réguler le développement de modèles, c'est fondamentalement la meilleure approche : réguler la transparence—et non les capacités, les atténuations, ou le risque acceptable. Cela donnerait à au moins une juridiction américaine l'autorité de surveillance de Bruxelles, et cela éviterait des effets indésirables sur le développement ouvert.

Pour être clair, il y a encore des icebergs devant :

> Complexité. Que ce soit Big Tech ou non, ce sont des obligations de documentation et de reporting lourdes. Tactiquement parlant, plus c'est complexe, plus ce projet de loi deviendra vulnérable.

> Incitations. Le reporting public obligatoire des évaluations de risque volontaires crée une incitation perverse pour les développeurs à sous-tester leurs modèles, et à fermer les yeux sur des risques difficiles. Permettre aux développeurs de divulguer leurs résultats à des auditeurs ou des agences plutôt que publiquement pourrait aider à promouvoir une plus grande franchise dans leurs évaluations internes.

> Cheval de Troie. La culture hyperactive de Californie de modification et d'amendement peut rendre difficile l'examen de ces projets de loi. Si le SB53 se transforme en un projet de loi sur les normes de soins comme le SB1047 ou le RAISE, il devrait être rejeté pour les mêmes raisons qu'auparavant. Plus il y a de décorations ajoutées à cet arbre de Noël, plus le projet de loi devient contentieux.

> Ampleur. Le projet de loi jette un large filet avec des définitions expansives de risque catastrophique et de capacité dangereuse. Pour un projet de loi "reporting obligatoire / pratiques volontaires", cela fonctionne. Si ce projet de loi était un projet de loi sur les normes de soins, il serait irréalisable.

En résumé : chapeau bas au Sénateur Wiener pour avoir engagé et répondu de manière réfléchie aux retours au cours de l'année passée. C'est rafraîchissant de voir un projet de loi qui s'appuie réellement sur des critiques antérieures. Il y a encore de nombreux chemins que ce projet de loi pourrait emprunter—et il a évolué bien au-delà de la proposition originale de dénonciation—mais la trajectoire est prometteuse.

5,97K

Arvind Narayanan a reposté

Pour ceux qui se demandent ce qui se passe ici techniquement, une explication :

Lorsqu'il y a beaucoup de données d'entraînement avec un style particulier, utiliser un style similaire dans votre prompt déclenchera le LLM pour répondre dans ce style. Dans ce cas, il y a ÉNORMÉMENT de fanfic :

🧵

180,2K

Nous sommes nous-mêmes des utilisateurs enthousiastes de l'IA dans nos workflows scientifiques. Au quotidien, tout cela semble très excitant. Mais l'impact de l'IA sur la science en tant qu'institution, plutôt que sur les scientifiques individuels, est une question différente qui nécessite une analyse différente. Écrire cet essai a nécessité de lutter contre nos propres intuitions dans de nombreux cas. Si vous êtes un scientifique qui est également enthousiaste à l'idée d'utiliser ces outils, nous vous exhortons à garder cette différence à l'esprit.

L'IA pourrait-elle ralentir la science ? Confrontation au paradoxe de la production et du progrès.

La tragédie est qu'il existe de nombreux outils d'IA pour la science qui feraient une réelle différence, comme l'IA pour signaler les erreurs potentielles dans le code scientifique. Mais les laboratoires sont fixés sur d'autres choses comme la revue de littérature / "recherche approfondie". Ce n'est pas un véritable goulot d'étranglement, donc peu importe à quelle vitesse vous le rendez. Pendant ce temps, les risques de court-circuiter la compréhension humaine sont énormes.

Les évaluations font partie du problème. Il y a trois types de questions que l'on peut poser sur un outil de revue de littérature : Est-ce qu'il fait gagner du temps à un chercheur et produit des résultats de qualité comparable à ceux des outils existants ? Comment l'utilisation de l'outil impacte-t-elle la compréhension de la littérature par le chercheur par rapport à une recherche traditionnelle ? Quels seront les impacts collectifs sur la communauté si l'outil était largement adopté ? Par exemple, tout le monde finira-t-il par citer les mêmes quelques articles ?

Actuellement, seule la première question est considérée comme faisant partie de ce que signifie l'évaluation. Les deux dernières sont hors de portée, et il n'existe même pas de méthodes ou de métriques établies pour une telle mesure. Cela signifie que l'évaluation de l'IA pour la science est garantie de fournir une image très incomplète et biaisée de l'utilité de ces outils et de minimiser leurs dommages potentiels.

En fin de compte, cela revient aux incitations détraquées des laboratoires d'IA pour la science, en particulier ceux des grandes entreprises d'IA. Ils veulent des titres accrocheurs "L'IA découvre X !" afin de maintenir le récit selon lequel l'IA résoudra les problèmes de l'humanité, ce qui leur procure un traitement politique favorable. Nous ne retenons pas notre souffle en attendant que cela change.

Mais une prise de conscience qu'il y a quelque chose de sérieusement erroné dans la trajectoire actuelle est un bon premier pas, et c'est l'objectif de cet essai par @sayashk et moi.

6,35K

Arvind Narayanan a reposté

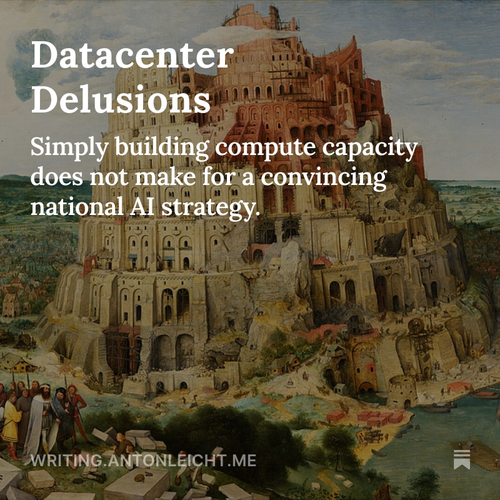

Nouveau post : Illusions des datacenters

Parmi les puissances intermédiaires, les Émirats Arabes Unis ont la stratégie d'IA la plus claire : devenir un "État pétrolier de l'IA" avec une part de calcul mondial significative. La plupart des autres pays construisent des datacenters sans viser des seuils de souveraineté viables.

🧵

10K

Arvind Narayanan a reposté

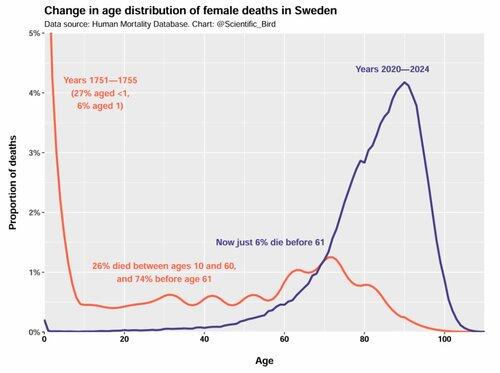

Au 18ème siècle, il y avait un véritable risque de mort à tout moment de la vie, et il n'y avait pas de pic important dans la vieillesse.

Ce n'était pas seulement une mortalité infantile plus élevée - toute la distribution était complètement différente.

Super graphique par @Scientific_Bird.

131,95K

Meilleurs

Classement

Favoris

Tendance on-chain

Tendance sur X

Récents financements de premier plan

Les plus notables