Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Arvind Narayanan

Princeton CS prof. Diretor @PrincetonCITP. Eu uso X para compartilhar minha pesquisa e comentário sobre o impacto social da IA.

LIVRO: AI Snake Oil. Vistas minhas.

A minha experiência com o ChatGPT Agent até agora: não consegui encontrar casos de uso que _não_ possam ser tratados pela Deep Research e que possam ser completados com sucesso pelo Agent sem encontrar obstáculos como formulários web problemáticos ou restrições de acesso.

Estou certo de que encontrarei alguns usos, mas acabará por ser uma pequena fração das tarefas que surgem nos meus fluxos de trabalho.

Se este for o caso, não fará sentido tentar realizar novas tarefas usando o Agent, a menos que seja uma tarefa que, de outra forma, eu gastaria horas a fazer (ou que precisaria repetir diariamente). Se a minha expectativa é que o Agent terá sucesso com uma probabilidade de 5%, e leva de 10 a 20 minutos a tentar arduamente antes de desistir, não vale a pena o meu tempo sequer descobrir se o Agent consegue fazê-lo. Eu só o usaria se, de alguma forma, já soubesse que é uma tarefa que o Agent pode lidar.

Dado tudo isto, continuo a pensar que agentes específicos para tarefas serão mais bem-sucedidos no futuro previsível.

1,31K

Arvind Narayanan republicou

🧠Novo no Blog CITP do estudante de doutoramento Boyi Wei (@wei_boyi) do Laboratório POLARIS: "A 'Bolha' do Risco: Melhorando Avaliações para Agentes de Cibersegurança Ofensiva"

Leia sobre como os adversários podem adaptar e modificar modelos de código aberto para contornar salvaguardas. 👇

2,97K

De volta à escola de pós-graduação, quando percebi como o "mercado de ideias" realmente funciona, senti como se tivesse encontrado os códigos de trapaça para uma carreira em pesquisa. Hoje, isso é a coisa mais importante que ensino aos alunos, mais do que qualquer coisa relacionada ao conteúdo da nossa pesquisa.

Uma rápida introdução: quando falo sobre sucesso em pesquisa, não me refiro a publicar muitos artigos. A maioria dos artigos publicados acumula poeira porque há muita pesquisa em qualquer campo para que as pessoas prestem atenção. E especialmente dado a facilidade de publicar pré-impressões, a pesquisa não precisa ser oficialmente publicada para ser bem-sucedida. Portanto, enquanto as publicações podem ser um pré-requisito para o avanço na carreira, elas não devem ser o objetivo. Para mim, o sucesso em pesquisa é a autoria de ideias que influenciam seus pares e tornam o mundo um lugar melhor.

Assim, a ideia básica é que há muitas ideias entrando no mercado de ideias, e precisamos entender quais acabam sendo influentes. A boa notícia é que a qualidade importa — outras coisas sendo iguais, uma pesquisa melhor será mais bem-sucedida. A má notícia é que a qualidade está apenas fracamente correlacionada com o sucesso, e há muitos outros fatores que importam.

Primeiro, dê a si mesmo várias chances de marcar um gol. O papel da sorte é um tema regular dos meus conselhos de carreira. É verdade que a sorte importa muito na determinação de quais artigos são bem-sucedidos, mas isso não significa se resignar a isso. Você pode aumentar sua "superfície de sorte".

Por exemplo, se você sempre publica pré-impressões, você tem várias chances para que seu trabalho seja notado: uma vez com a pré-impressão e uma vez com a publicação (além de, se você estiver em um campo com grandes atrasos de publicação, você pode garantir que a pesquisa não seja antecipada ou irrelevante quando for publicada).

De maneira mais geral, trate projetos de pesquisa como startups — aceite que há uma variância muito alta nos resultados, com alguns projetos sendo 10x ou 100x mais bem-sucedidos do que outros. Isso significa tentar muitas coisas diferentes, fazer grandes apostas, estar disposto a perseguir o que seus pares consideram ser más ideias, mas com alguma ideia de por que você pode potencialmente ter sucesso onde outros falharam antes de você. Você sabe algo que os outros não sabem, ou eles sabem algo que você não sabe? E se você descobrir que é o último, você precisa estar disposto a abandonar o projeto rapidamente, sem cair na falácia do custo afundado.

Para ser claro, o sucesso não se resume apenas à sorte — qualidade e profundidade importam muito. E leva alguns anos de pesquisa para se aprofundar em um tópico. Mas passar alguns anos pesquisando um tópico antes de publicar qualquer coisa é extremamente arriscado, especialmente no início da sua carreira. A solução é simples: persiga projetos, não problemas.

Projetos são agendas de pesquisa de longo prazo que duram de 3 a 5 anos ou mais. Um projeto produtivo poderia facilmente produzir uma dúzia ou mais de artigos (dependendo do campo). Por que escolher projetos em vez de problemas? Se seu método é pular de problema em problema, os artigos resultantes provavelmente serão um tanto superficiais e podem não ter muito impacto. E, em segundo lugar, se você já é conhecido por artigos sobre um determinado tópico, as pessoas são mais propensas a prestar atenção aos seus futuros artigos sobre esse tópico. (Sim, a reputação do autor importa muito. Qualquer noção igualitária de como as pessoas escolhem o que ler é um mito.)

Para recapitular, eu geralmente trabalho em 2-3 projetos de longo prazo ao mesmo tempo, e dentro de cada projeto há muitos problemas sendo investigados e muitos artigos sendo produzidos em várias etapas do processo.

A parte mais difícil é saber quando encerrar um projeto. No momento em que você está considerando um novo projeto, você está comparando algo que levará alguns anos para realmente se concretizar com um tópico onde você já é altamente produtivo. Mas você tem que encerrar algo para abrir espaço para algo novo. Desistir no momento certo sempre parece que você está desistindo muito cedo. Se você seguir sua intuição, ficará na mesma área de pesquisa por tempo demais.

Finalmente, construa sua própria distribuição. No passado, a publicação oficial de um artigo servia a dois propósitos: dar-lhe a credibilidade que vem da revisão por pares e distribuir o artigo para seus pares. Agora essas duas funções foram completamente separadas. A publicação ainda traz credibilidade, mas a distribuição é quase inteiramente sua!

É por isso que as redes sociais importam tanto. Infelizmente, as redes sociais introduzem incentivos não saudáveis para exagerar suas descobertas, então eu acho que blogs/newsletters e vídeos de longa duração são canais muito melhores. Estamos em uma segunda era de ouro do blogging e há uma extrema escassez de pessoas que podem explicar pesquisas de ponta de suas disciplinas de uma maneira acessível, mas sem simplificá-las como em comunicados de imprensa ou artigos de notícias. Nunca é cedo demais — eu comecei um blog durante meu doutorado e ele desempenhou um grande papel na divulgação da minha pesquisa de doutorado, tanto dentro da minha comunidade de pesquisa quanto fora dela.

Resumo

* O sucesso em pesquisa não significa apenas publicação

* O mercado de ideias está saturado

* Dê a si mesmo várias chances de marcar um gol

* Escolha projetos, não problemas

* Trate projetos como startups

* Construa sua própria distribuição.

39,61K

Arvind Narayanan republicou

Especialistas em transtorno dismórfico corporal alertaram que as pessoas que lutam com isso se tornaram cada vez mais dependentes de chatbots de IA para avaliar suas falhas percebidas e recomendar cirurgias estéticas. "Está quase a aparecer em todas as sessões", diz-me um terapeuta.

106,83K

Se comparássemos as capacidades da IA com as dos humanos sem acesso a ferramentas, como a internet, provavelmente descobriríamos que a IA já supera os humanos em muitas ou na maioria das tarefas cognitivas que realizamos no trabalho. Mas, claro, esta não é uma comparação útil e não nos diz muito sobre os impactos económicos da IA. Não somos nada sem as nossas ferramentas.

E ainda assim, muitas previsões sobre o impacto da "AGI" baseiam-se em comparações hipotéticas entre humanos e IA nas quais os humanos têm acesso à internet, mas não têm acesso à IA. Este tipo de comparação é igualmente irrelevante.

A verdadeira questão é humanos + IA vs IA sozinha. Numa comparação desse tipo, a IA não vai superar pares humanos-IA, exceto em domínios estreitos e computacionalmente pesados, como jogos, onde a velocidade é primordial e ter um humano na equação apenas atrasa as coisas.*

Portanto, se a IA substituir ou não os humanos depende de fatores além da precisão — coisas como responsabilidade, a capacidade de lidar com incógnitas desconhecidas e as potenciais preferências de clientes e outros trabalhadores em interagir com um humano, tudo ponderado em relação ao custo de empregar um humano.

Isso não quer dizer que a IA não vá deslocar empregos. Mas olhar para benchmarks de capacidade e ir diretamente para alegações sobre perda de empregos é completamente ingênuo.

* Existem muitos estudos onde os trabalhadores anulam a IA incorretamente com muita frequência, mas isso se deve ao fato de não terem recebido formação sobre quando anular e quando não anular, o que é uma habilidade essencial em fluxos de trabalho habilitados por IA.

12,62K

Arvind Narayanan republicou

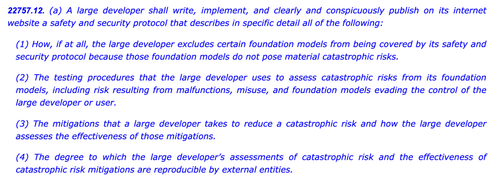

O SB1047 foi uma má ideia. Mas o mais recente SB53 do Sen. Wiener está no caminho certo, e é importante reconhecer o progresso. Aqui está o meu raciocínio.

A minha abordagem para regular tecnologias novas como modelos é: não sabemos como definir uma mitigação e garantia "boas", mas saberemos quando—e se—virmos.

Há duas implicações.

#1. Não devemos prescrever limiares de risco ou padrões de cuidado para o desenvolvimento de modelos. Não conseguimos concordar sobre os riscos que importam, como medi-los ou quanto é demais. A única orientação para desenvolvedores, reguladores e tribunais é um conjunto de práticas incipientes determinadas principalmente por empresas de código fechado que dependem de paywalls para fazer o trabalho pesado. Fazer isso poderia inibir a inovação aberta ao expor os desenvolvedores a uma responsabilidade vaga ou aumentada pela liberação generalizada.

Isso foi o SB1047 em resumo, junto com cerca de 5 equivalentes que inspirou em todo os EUA nesta sessão, como o RAISE Act em NY. Devemos evitar essa abordagem. Essas propostas são—em aspectos estreitos, mas cruciais—demasiado ambiciosas.

E ainda assim:

#2. Precisamos iluminar as práticas da indústria para entender melhor a diligência, ou a falta dela, aplicada por diferentes empresas. Se os desenvolvedores tiverem que se comprometer com uma política de segurança e proteção, mostrar seu trabalho e deixar um rastro documental, poderemos avaliar melhor a força de suas alegações, monitorar riscos emergentes e decidir sobre intervenções futuras.

Isso é o que o Ato de IA da UE e o Código de Prática final resumem, que tanto a OpenAI quanto a Mistral endossaram, e é também a versão mais recente do SB53 do @Scott_Wiener.

Se vamos regular o desenvolvimento de modelos, essa é fundamentalmente a melhor abordagem: regular a transparência—não capacidades, mitigações ou risco aceitável. Isso daria pelo menos uma jurisdição dos EUA a autoridade de supervisão de Bruxelas, e evitaria efeitos indesejados no desenvolvimento aberto.

Para ser claro, ainda há icebergs à frente:

> Complexidade. Seja Big Tech ou não, estas são obrigações de documentação e relatório onerosas. Taticamente falando, quanto mais complexa, mais vulnerável este projeto se tornará.

> Incentivos. O relatório público obrigatório de avaliações de risco voluntárias cria um incentivo perverso para os desenvolvedores subtestarem seus modelos e fecharem os olhos para riscos difíceis. Permitir que os desenvolvedores divulguem seus resultados a auditores ou agências em vez de publicamente pode ajudar a promover maior sinceridade em suas avaliações internas.

> Cavalo de Troia. A cultura hiperativa de alteração e emenda da Califórnia pode dificultar a verificação desses projetos. Se o SB53 se transformar em um projeto de padrão de cuidado como o SB1047 ou o RAISE, deve ser rejeitado pelas mesmas razões de antes. Quanto mais enfeites forem adicionados a esta árvore de Natal, mais contencioso será o projeto.

> Amplitude. O projeto lança uma rede ampla com definições expansivas de risco catastrófico e capacidade perigosa. Para um projeto de "relatório obrigatório / práticas voluntárias", eles funcionam. Se este projeto fosse um projeto de padrão de cuidado, seriam inviáveis.

Em suma: parabéns ao Sen. Wiener por se envolver e responder de forma ponderada ao feedback ao longo do último ano. É refrescante ver um projeto que realmente se baseia em críticas anteriores. Ainda há muitos caminhos que este projeto pode seguir—e ele evoluiu muito além da proposta original de denúncia—mas a trajetória é promissora.

5,97K

Arvind Narayanan republicou

Novo Post: Delírios de Datacenters

Entre as potências médias, os EAU têm a estratégia de IA mais clara: tornar-se um 'estado do petróleo da IA' com uma participação significativa no computação global. A maioria dos outros países está a construir datacenters sem visar limiares de soberania viáveis.

🧵

10,01K

Top

Classificação

Favoritos

Tendências on-chain

Popular no X

Principais financiamentos atuais

Mais notável