Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

宝玉

Prompt Engineer, dedicato all'apprendimento e alla diffusione di conoscenze sull'intelligenza artificiale, l'ingegneria del software e la gestione dell'ingegneria.

Oggi c'è una notizia molto discussa su Hacker News: il tasso di disoccupazione in California è salito al 5,5%, il più alto negli Stati Uniti, e il settore tecnologico sta affrontando difficoltà: "Il mercato del lavoro è troppo crudele".

> Secondo i dati pubblicati venerdì dal governo statale, il tasso di disoccupazione in California a luglio è salito al 5,5%, il più alto tra tutti gli stati americani. Questo è dovuto alla continua debolezza del settore tecnologico e di altri posti di lavoro d'ufficio, insieme a un mercato del lavoro stagnante.

La notizia attribuisce questo alla debolezza del settore tecnologico, poiché questo settore gioca un ruolo cruciale nell'economia californiana. La notizia ha suscitato vivaci discussioni nella comunità di Hacker News, dove le persone hanno analizzato le cause profonde da diverse prospettive, rivelando una complessità ben oltre quanto indicato nel titolo.

Ritengo che la discussione sopra riportata riassuma bene perché attualmente il settore tecnologico sta vivendo una crisi occupazionale.

1. Prima di tutto, il punto centrale è: le molteplici conseguenze della fine dell'"era dei tassi zero"

Questo è il punto di vista più diffuso e profondo nella discussione. Molti credono che le difficoltà attuali del settore tecnologico non siano causate da un singolo fattore, ma siano il risultato di una reazione a catena scatenata dalla fine dell'era della "politica dei tassi zero" (ZIRP, Zero Interest Rate Policy) degli ultimi dieci anni.

- Scoppio della bolla dei capitali: dal 2012 al 2022, i tassi di interesse estremamente bassi hanno reso il capitale eccezionalmente economico. Un'enorme quantità di investimenti di rischio (VC) è affluita nel settore tecnologico, generando innumerevoli modelli di business che dipendevano dalla "bruciatura di denaro", in particolare per le criptovalute (Crypto) e le aziende del metaverso (Metaverse) prive di valore reale. Con l'aumento dei tassi da parte della Federal Reserve, l'era del capitale a buon mercato è finita, portando alla rottura delle catene di approvvigionamento di queste aziende, causando licenziamenti e chiusure in massa.

- Disequilibrio tra domanda e offerta di talenti: durante l'era ZIRP, il mito degli alti salari nel settore tecnologico ha attratto un gran numero di talenti. I programmi di informatica (CS) delle università hanno ampliato notevolmente le loro iscrizioni, i boot camp di programmazione sono spuntati ovunque, e insieme all'immigrazione tecnologica, l'offerta di ingegneri software è aumentata drasticamente in dieci anni. Tuttavia, con il ritiro del capitale, la domanda (soprattutto da parte delle startup) è crollata, causando un grave eccesso di offerta di talenti.

- Effetti a catena su settori come la biotecnologia: settori come la biotecnologia (Biotech), che dipendono anch'essi da investimenti a lungo termine e ad alto rischio, hanno subito gravi danni. Questi settori sono ancora più dipendenti dal capitale a buon mercato rispetto al settore software. Con la fine della ZIRP, i fondi VC si sono gradualmente esauriti, e le startup, esauriti i "fondi di corsa" (runway), non sono riuscite a ottenere nuovi finanziamenti, costrette a licenziare o chiudere.

> (di tqi): "A mio avviso, è ancora presto per dire che l'AI ha un impatto sostanziale sulle assunzioni delle aziende software. Una spiegazione più ragionevole è che tra il 2012 e il 2022, l'offerta di ingegneri software è aumentata drasticamente... mentre dalla parte della domanda, i fondi VC dell'era dei tassi zero sono stati principalmente investiti in criptovalute e aziende del metaverso che non sono riuscite a prosperare, portando a una mancanza di aziende mature o quotate in grado di assorbire questi talenti."

2. La "spada a doppio taglio" del lavoro remoto: la nuova ondata di esternalizzazione globale

La pandemia di COVID-19 ha diffuso il lavoro remoto (Work From Home, WFH), che all'epoca era visto come una benedizione da molti sviluppatori, ma ora i suoi effetti negativi stanno iniziando a manifestarsi.

- Aprire la strada all'esternalizzazione: quando gli sviluppatori lottano per ottenere il diritto al lavoro completamente remoto, potrebbero non rendersi conto che questo ha anche aperto la porta alle aziende per esternalizzare posti di lavoro in paesi a costo inferiore. Dato che tutti lavorano da remoto, perché un'azienda dovrebbe assumere un ingegnere americano a cinque volte il costo di un ingegnere indiano o dell'Europa dell'Est, altrettanto qualificato?

- Gli uffici "non possono tornare indietro": alcuni commentatori sostengono che le politiche di "ritorno in ufficio" (Return to Office, RTO) promosse dalle aziende tecnologiche siano in parte volte a proteggere i posti di lavoro locali. Una volta dimostrato che il lavoro può essere svolto al 100% da remoto, può essere svolto ovunque nel mondo, e il vantaggio salariale degli ingegneri americani non esisterà più.

- Dibattito sulla qualità dell'esternalizzazione: ci sono anche coloro che controbattono che l'esternalizzazione è in corso da decenni e che lo sviluppo software di alta qualità richiede ancora talenti locali di alto livello, poiché problemi come i costi di comunicazione, le differenze di fuso orario e le differenze culturali sono difficili da risolvere. Tuttavia, gli utenti a favore dell'esternalizzazione sostengono che, con la maturazione degli strumenti di collaborazione remota e il miglioramento dei modelli di gestione, questi ostacoli stanno gradualmente venendo superati.

> (di aurareturn): "Dico su HN dal 2022: tutti gli sviluppatori nordamericani che supportano il lavoro completamente remoto, quando la vostra azienda deciderà di sostituirvi con persone all'estero, rimarrete sorpresi. Dato che tutti lavorano da remoto, perché un'azienda dovrebbe pagare cinque volte di più per assumere voi, piuttosto che un dipendente all'estero più laborioso e meno lamentoso?... Gli ordini di ritorno in ufficio, a lungo termine, potrebbero salvaguardare la vostra carriera."

3. Il ruolo dell'AI: strumento di produttività, scusa per i licenziamenti, o "vampiro" del capitale?

La discussione sul ruolo dell'intelligenza artificiale (AI) in questa ondata di disoccupazione presenta complessità e divergenze.

- Effetti di sostituzione diretta limitati: la maggior parte delle persone concorda sul fatto che l'attuale AI non può ancora sostituire completamente ingegneri software esperti. Tuttavia, ha già iniziato a sostituire alcuni lavori di livello inferiore e ripetitivi, come alcune piccole attività di consulenza. Alcuni consulenti hanno riferito che i clienti non li contattano più perché possono risolvere piccoli bug con ChatGPT.

- "Scusa perfetta" per i licenziamenti: un'opinione comune è che l'AI sia diventata la "scusa perfetta" per le aziende per licenziare e ridurre i costi. Anche se la causa principale dei licenziamenti è la recessione economica o le decisioni della direzione, le aziende sono felici di presentarlo come un aggiustamento strategico per "abbracciare l'AI e migliorare l'efficienza".

- "Buco nero" del capitale: l'AI ha svolto un altro ruolo chiave: ha assorbito i pochi investimenti di rischio rimasti sul mercato, che avrebbero potuto fluire in altri settori tecnologici. I VC ora sono quasi interessati solo a progetti AI, il che aggrava le difficoltà di finanziamento per le startup non AI.

4. La "zona di ruggine" del settore tecnologico? Preoccupazioni strutturali per il futuro

Alcuni discussant hanno espresso preoccupazioni per il futuro da una prospettiva più macro, paragonando il settore tecnologico alla "zona di ruggine" dell'industria manifatturiera, che un tempo era fiorente e ora è in declino.

- Ripetizione della perdita di posti di lavoro: proprio come gli Stati Uniti hanno esternalizzato l'industria manifatturiera in Cina, ora i lavori IT e di sviluppo software stanno migrando in massa verso India, America Latina e Europa dell'Est. Questo potrebbe portare a una disoccupazione strutturale a lungo termine per gli ingegneri software, un tempo ben retribuiti.

- Impatti politici e sociali: se un gran numero di posti di lavoro tecnologici di classe media scomparisse, potrebbero sorgere nuovi problemi sociali e politici, proprio come il declino della "zona di ruggine" continua a influenzare il panorama politico americano.

- Controversie sulle politiche di immigrazione e visti (H1B/O1): una parte della discussione ha puntato il dito contro i visti di lavoro come l'H1B, ritenendoli abusati, abbassando i salari degli ingegneri locali e intensificando la competizione. Altri difendono strenuamente l'immigrazione tecnologica, sostenendo che sono proprio questi talenti di alto livello provenienti da tutto il mondo (come i laureati dell'Università di Waterloo) a costituire la base dell'innovazione nella Silicon Valley.

5. Cambiamenti nella gestione aziendale e nella cultura: l'"effetto Musk"

Un punto interessante è che il massiccio licenziamento di Musk su Twitter (ora X) ha avuto un effetto dimostrativo.

- Razionalizzazione dei licenziamenti: quando Musk ha licenziato oltre il 75% dei dipendenti di Twitter, il prodotto ha continuato a funzionare, il che ha portato molti CEO a riflettere: "Se lui può farlo, perché non posso farlo anch'io?" Questo ha infranto la mentalità precedente delle aziende tecnologiche secondo cui "più talenti ci sono, meglio è", rendendo i licenziamenti di massa più facilmente accettabili sia psicologicamente che commercialmente.

6. Fattori politici e normativi: controversie sulle modifiche fiscali

Un aspetto tecnico ma di grande impatto riguarda le modifiche alla legislazione fiscale americana.

- Regole di ammortamento delle spese di R&D (Sezione 174): nella legge fiscale riformata del 2017 dell'amministrazione Trump (TCJA), c'era una disposizione che richiedeva alle aziende di ammortizzare le spese di ricerca e sviluppo (R&D), come i salari per lo sviluppo software, in cinque anni a partire dal 2022, invece di poterli dedurre integralmente nell'anno in cui sono stati sostenuti. Questo ha aumentato notevolmente il carico fiscale per le aziende tecnologiche (soprattutto le startup), riducendo la loro volontà di assumere negli Stati Uniti.

- Ruolo correttivo delle recenti leggi: la recente approvazione della "legge per ricostruire un futuro migliore" (Build Back Better, BBB) ha parzialmente corretto questo problema, consentendo nuovamente la deduzione immediata delle spese di R&D domestiche. Alcuni commentatori ritengono di aver percepito un miglioramento nel mercato del lavoro intorno a luglio, il che potrebbe essere correlato a questo.

In conclusione

Dalla discussione emerge che le ragioni della crisi occupazionale nel settore tecnologico californiano sono piuttosto complesse e non possono essere attribuite a un singolo fattore, né possono essere semplicemente riassunte come "l'AI che sostituisce gli esseri umani" o "una recessione ciclica del settore", ma sono il risultato di una serie di fattori intrecciati, tra cui la fine dell'era dei tassi zero, la ristrutturazione del mercato del lavoro globale portata dal lavoro remoto, l'impatto duplice dell'AI come nuova tecnologia e magnete di capitale, e le variazioni di politiche fiscali specifiche.

Non so quando riusciremo a uscire da questa situazione difficile? O forse le ragioni non si limitano a quelle discusse sopra.

58,75K

Traduzione: Perché i grandi modelli linguistici non possono realmente costruire software

Autore: Conrad Irwin

Una delle cose su cui ho speso molto tempo è stata l'intervista a ingegneri del software. Questo è chiaramente un compito arduo, e non posso dire di avere un trucco speciale; ma questa esperienza mi ha davvero dato il tempo di riflettere su cosa faccia effettivamente un ingegnere del software efficiente.

Il ciclo centrale dell'ingegneria del software

Quando osservi un vero esperto, scopri che esegue sempre in loop i seguenti passaggi:

* Costruire un modello mentale sui requisiti.

* Scrivere (si spera?!) codice che soddisfi i requisiti.

* Costruire un modello mentale sul comportamento reale del codice.

* Scoprire le differenze tra i due e poi aggiornare il codice (o i requisiti).

Ci sono molti modi per completare questi passaggi, ma la forza degli ingegneri efficienti sta nella loro capacità di costruire e mantenere modelli mentali chiari.

Come si comportano i grandi modelli linguistici?

A dire il vero, i grandi modelli linguistici sono piuttosto bravi a scrivere codice. Quando indichi dove sia il problema, sono anche bravi ad aggiornare il codice. Possono fare tutto ciò che farebbe un ingegnere umano: leggere codice, scrivere e eseguire test, aggiungere log e (probabilmente) usare un debugger.

Ma ciò che non possono fare è mantenere un modello mentale chiaro.

I grandi modelli linguistici si trovano intrappolati in una confusione infinita: presumono che il codice che scrivono funzioni davvero; quando i test falliscono, possono solo indovinare se riparare il codice o il test; quando si sentono frustrati, semplicemente cancellano tutto e ricominciano.

Questo è esattamente l'opposto delle caratteristiche che mi aspetto da un ingegnere.

Gli ingegneri del software lavorano e testano contemporaneamente. Quando un test fallisce, possono confrontare il loro modello mentale per decidere se riparare il codice o il test, o raccogliere ulteriori informazioni prima di prendere una decisione. Quando si sentono frustrati, possono cercare aiuto parlando con qualcuno. Anche se a volte cancellano tutto e ricominciano, lo fanno solo dopo aver acquisito una comprensione più chiara del problema.

Ma andrà tutto bene, giusto?

Con l'aumento delle capacità dei modelli, cambierà questa situazione? Forse?? Ma penso che ciò richieda un cambiamento fondamentale nel modo in cui i modelli costruiscono e ottimizzano. Il modello di cui ha bisogno l'ingegneria del software non è solo in grado di generare codice.

Quando una persona incontra un problema, può temporaneamente mettere da parte tutto il contesto, concentrarsi sulla risoluzione del problema attuale e poi riprendere i pensieri precedenti, tornando al grande problema in corso. Possono anche passare agevolmente tra la visione d'insieme e i dettagli, ignorando temporaneamente i dettagli per concentrarsi sul tutto, e approfondire i particolari quando necessario. Non diventeremo più efficienti semplicemente riempiendo la nostra "finestra di contesto" con più parole; questo ci farebbe solo impazzire.

Anche se possiamo gestire enormi quantità di contesto, sappiamo che attualmente questi modelli generativi presentano diversi problemi gravi che influenzano direttamente la loro capacità di mantenere un modello mentale chiaro:

* Omissione di contesto: i modelli non sono bravi a scoprire informazioni contestuali trascurate.

* Pregiudizio di recente: quando gestiscono la finestra di contesto, sono gravemente influenzati da un pregiudizio di recente.

* Illusione: spesso "fantasticano" dettagli che non dovrebbero esistere.

Questi problemi potrebbero non essere insormontabili, e i ricercatori stanno lavorando per dare ai modelli una memoria, in modo che possano esercitare tecniche di pensiero simili alle nostre. Ma sfortunatamente, al momento, non possono realmente comprendere cosa stia accadendo (oltre un certo livello di complessità).

Non possono costruire software perché non possono mantenere simultaneamente due "modelli mentali" simili, scoprire le differenze e decidere se aggiornare il codice o i requisiti.

Quindi, cosa fare adesso?

È chiaro che i grandi modelli linguistici sono utili per gli ingegneri del software. Possono generare codice rapidamente e si comportano bene nell'integrare requisiti e documentazione. Per alcuni compiti, questo è già sufficiente: i requisiti sono abbastanza chiari, il problema è abbastanza semplice, possono farlo in un colpo solo.

Detto ciò, per qualsiasi compito con un po' di complessità, non possono mantenere abbastanza contesto in modo sufficientemente preciso per produrre iterativamente una soluzione praticabile. Tu, come ingegnere del software, devi comunque assicurarti che i requisiti siano chiari e che il codice realizzi realmente le funzionalità che dichiara di avere.

In Zed, crediamo che in futuro gli esseri umani e gli agenti AI possano collaborare per costruire software. Tuttavia, siamo fermamente convinti (almeno per ora) che tu sia il conducente al volante, mentre i grandi modelli linguistici sono solo un altro strumento a tua disposizione.

62,82K

宝玉 ha ripubblicato

Ieri sono andato a parlare alla conferenza dei product manager di CSDN.

Tre mesi fa, quando gli amici di CSDN mi hanno invitato a fare un intervento alla conferenza dei product manager, in realtà volevo rifiutare.

Il motivo è che la mia startup è stata fondata solo sei mesi fa e non ho molte intuizioni da condividere con tutti.

Tuttavia, gli amici di CSDN hanno detto che non c'era problema, la conferenza era tra tre mesi, c'era tempo a sufficienza e potevo anche condividere alcune esperienze sui prodotti precedenti.

Per coincidenza, la settimana scorsa, dopo il lancio di FlowSpeech, il nostro prodotto ha avuto un ottimo riscontro, il MRR è aumentato di tre volte e l'ARR ha superato un piccolo obiettivo, e cosa più importante, i nostri utenti hanno guadagnato soldi veri utilizzando il prodotto, il che è la migliore prova della nostra forza del prodotto.

Quindi ieri, durante il mio intervento, ho scherzato dicendo che il valore di questa presentazione è aumentato vertiginosamente, quindi vi prego di ascoltare attentamente.

37,39K

“Come contadino, compro solo cibo biologico; come professionista dell'AI, guardo solo contenuti non generati da AI”😅

马东锡 NLP 🇸🇪15 ago, 16:12

Non so come siete voi, ma come professionista dell'AI, ho un rifiuto istintivo per tutto ciò che è generato da AI.

Quando rivedo il codice, se penso che sia stato scritto da un'AI, scrivo direttamente LGTM.

Quando leggo articoli, se percepisco che sono generati da AI, chiudo immediatamente.

Se l'interfaccia di un sito web sembra generata da AI, chiudo subito.

Se un podcast è generato da AI, chiudo immediatamente.

Se un video breve è generato da AI, lo scarto subito e lo sostituisco con video di venditori di auto usate o di riparazione di zoccoli di asini.

Penso che lasciare che i contenuti generati da AI ingannino la mia dopamina e le endorfine sia una mancanza di responsabilità verso il mio corpo e la mia mente.

I contenuti generati da AI hanno certamente valore, ma solo come intermediari tra l'input e l'output finale dell'umanità, non dovrebbero e non possono circolare a lungo come forma finale.

62,01K

Vibe Coding è un termine fuorviante e pessimo, il suo significato principale è quello di utilizzare l'IA per lo sviluppo di prototipi, che può aiutare a definire rapidamente i requisiti del prodotto. Nello sviluppo software, il codice per lo sviluppo di prototipi è solitamente usa e getta; quando si sviluppa ufficialmente un prodotto, è necessario riprogettare il sistema, riscrivere il codice e implementarlo. Anche i risultati di Vibe Coding sono simili: dopo aver definito i requisiti, è comunque necessario riprogettare e sviluppare nuovamente.

铁锤人14 ago, 21:07

Si stima che molte persone non sappiano cosa sia il vibe coding?

Questo termine è stato creato dal guru dell'intelligenza artificiale Andre Karpathy,

quando descrivi un problema all'AI e poi essa scrive da sola il codice.

Si applica solo a quei semplici progetti del fine settimana che puoi usare solo tu.

Poiché si tratta di un progetto non importante, può agire in base all'istinto, senza dover realmente pianificare o testare.

👇 È qui che inizia il sogno.

48,07K

Nell'ingegneria contestuale, l'agente deve utilizzare strumenti e interagire con l'ambiente per ottenere dati che completino il contesto.

dontbesilent14 ago, 05:13

Ho capito improvvisamente cosa sono claude code e comet, e perché l'agent appare in CLI e nel browser, diventando la scelta principale.

La posizione in cui appare l'agent è molto importante!

Gli sviluppatori amano usare claude code perché possono controllare il proprio codice tramite CLI; il codice è in realtà il contesto per comunicare con il grande modello. Con il codice, posso parlare di meno, e il lavoro dell'agent modifica direttamente i file sul mio computer.

Tuttavia, oggi ho fatto un giro e ho scoperto che le persone che fanno media non possono usarlo, perché non hanno nulla nel computer; il contenuto principale è tutto nelle app e nei browser.

Ma claude code è difficile da ottenere per le cose nel browser e nelle app, quindi il problema principale non è se uso sonnet o opus, ma piuttosto che questo agent non dovrebbe apparire nella riga di comando.

Questo agent dovrebbe apparire nel browser! Ad esempio, il flusso di lavoro coze che Douyin continua a promuovere per estrarre dati da Xiaohongshu, si può semplicemente usare comet e il gioco è fatto.

Per le persone che fanno media, comet è il vero claude code, perché l'agent per i creatori di contenuti deve apparire nel browser.

Rispetto al vecchio browser dia, sembra molto stupido; quello non è un agent, è un LLM.

Se si inserisce solo un LLM nel browser, penso che sia quasi privo di significato.

15,11K

Tutorial di autoapprendimento in informatica TeachYourselfCS

Se sei un ingegnere autodidatta o hai appena terminato un corso di programmazione, è fondamentale che tu studi informatica. Fortunatamente, non è necessario spendere anni e una somma considerevole per ottenere una laurea: puoi ottenere un'istruzione di livello mondiale semplicemente contando su te stesso💸.

Su Internet, ci sono molte risorse di apprendimento, ma ci sono anche molte informazioni di scarsa qualità. Ciò di cui hai bisogno non è un elenco di "200+ corsi online gratuiti", ma le risposte alle seguenti domande:

Quali materie dovresti studiare e perché?

Quali sono i migliori libri o corsi video per queste materie?

In questa guida, cerchiamo di fornire risposte certe a queste domande.

Deedy14 ago, 09:59

"Insegnati la Scienza Informatica" è la migliore risorsa per imparare CS.

Dopo 2 settimane di coding vibrazionale, le persone non tecniche sentono il dolore. "Vorrei davvero essere tecnico. Non so proprio come procedere."

Ci vogliono circa 1000 ore su 9 argomenti per comprendere la CS con una certa profondità.

152,08K

宝玉 ha ripubblicato

Sono arrivati amici~ Ho guadagnato solo 20 yuan con 3 milioni di utenti: la falsa prosperità degli strumenti AI - ListenHub

Raccontare barzellette, chi non sa farlo? Prima molte persone erano molto interessate ai casi che ho condiviso su Hardland Hacker, quindi ho creato un podcast di barzellette usando @oran_ge su listenhub. Venite ad ascoltare~

29,23K

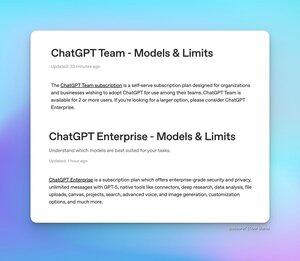

Molti amici sono interessati ai limiti di utilizzo della versione Team (Team) e della versione Enterprise (Enterprise) di ChatGPT. Ora, l'ufficio ha pubblicato due nuovi articoli di domande frequenti (FAQ) che spiegano la situazione.

* Versione Team di ChatGPT - L'uso di GPT-5 e GPT-4o è illimitato, ma ci sono i seguenti limiti specifici per le diverse versioni del modello:

* 200 richieste di pensiero (Thinking) GPT-5 al giorno

* 2800 richieste di pensiero mini (Thinking mini) GPT-5 a settimana

* 15 richieste di GPT-5 Pro al mese

* 500 richieste di GPT-4.1 ogni 3 ore

* 300 richieste di o4-mini e o3 al giorno

* Versione Enterprise di ChatGPT - L'uso di GPT-5, GPT-4o e GPT-4.1-mini è illimitato, ma ci sono i seguenti limiti specifici per le diverse versioni del modello:

* 200 richieste di pensiero (Thinking) GPT-5 a settimana

* 15 richieste di GPT-5 Pro al mese

* 20 richieste di GPT-4.5 a settimana

* 500 richieste di GPT-4.1 ogni 3 ore

* 300 richieste di o4-mini al giorno

* 100 richieste di o4-mini-high al giorno

* 100 richieste di o3 a settimana

* 15 richieste di o3-pro al mese

L'articolo FAQ menziona anche che attualmente i limiti del modello di pensiero (Thinking) GPT-5 sono temporanei e in realtà sono più alti rispetto ai limiti a lungo termine elencati sopra.

Tibor Blaho14 ago, 03:17

Per tutti coloro che chiedono riguardo ai limiti di ChatGPT Team & Enterprise - ci sono 2 nuovi articoli FAQ

- ChatGPT Team - GPT-5 e GPT-4o illimitati, 200 richieste di pensiero GPT-5/giorno, 2800 richieste mini di pensiero GPT-5/settimana, 15 richieste Pro GPT-5/mese, 500 richieste GPT-4.1/3 ore, 300 richieste o4-mini e o3/giorno

- ChatGPT Enterprise - GPT-5, GPT-4o e GPT-4.1-mini illimitati, 200 richieste di pensiero GPT-5/settimana, 15 richieste Pro GPT-5/mese, 20 richieste GPT-4.5/settimana, 500 richieste GPT-4.1/3 ore, 300 richieste o4-mini/giorno, 100 richieste o4-mini-high/giorno, 100 richieste o3/settimana, 15 richieste o3-pro/mese

L'articolo FAQ menziona che i limiti di pensiero GPT-5 sono temporaneamente più alti rispetto alle tariffe a lungo termine mostrate sopra.

15,53K

Questo è vero: è meglio dire cosa si dovrebbe fare piuttosto che cosa non si dovrebbe fare nei prompt. I modelli di grandi dimensioni sono simili agli esseri umani in questo, più si cerca di vietare qualcosa, più è facile attirare l'attenzione su di esso.

素人极客-Amateur Geek13 ago, 23:50

Quando vuoi che il modello non faccia qualcosa,

cerca di non scriverlo direttamente!!!

Cerca di non scriverlo direttamente!!!

Cerca di non scriverlo direttamente!!!

Qui ti spiego brevemente alcuni metodi:

1. Se devi scriverlo, non superare le due righe.

2. Trasforma il "non fare" in "fare". Non scrivere frasi sbagliate — devi controllare frase per frase, assicurandoti che ogni frase abbia un'introduzione, una transizione e un collegamento.

3. Il contenuto vietato può passare da non apparire a apparire più volte. Alcune cose non si ricordano se le dici una sola volta. Quando andavo a scuola, il mio insegnante di giapponese diceva che le aziende giapponesi hanno una caratteristica particolare: ripetono instancabilmente una cosa semplice per non farti dimenticare, anche le cose più piccole, se ripetute, verranno ricordate. Puoi vietare all'inizio, nel mezzo, nei punti correlati e anche alla fine.

4. Se il divieto è di non fare, aggiungi un passaggio: completa un'azione in due fasi, aggiungendo alla fine una frase che ti chieda se ci sono elementi vietati. Ti invierò gli elementi vietati e poi inizieremo a filtrare gli elementi vietati, assicurandoci che le altre informazioni rimangano invariate.

5. Metti gli elementi vietati al primo passo.

6. Assicurati che i tuoi elementi vietati possano effettivamente vietare. Ad esempio, se non hai definito lo stile del testo, e il testo risulta avere un sapore di AI, allora vietargli di usare un tono da AI non servirà a nulla, perché non sa nemmeno quale tono sta usando!

63,87K

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari