Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

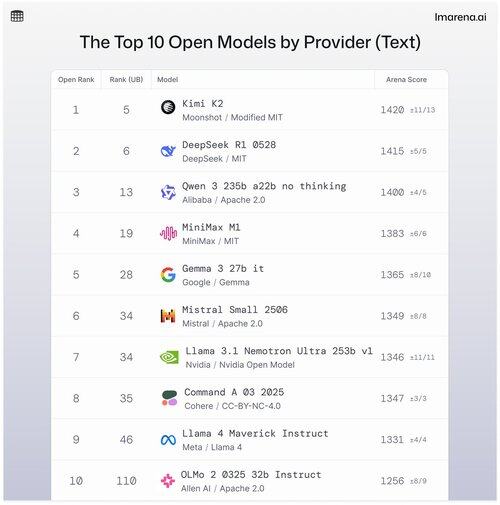

🧵Os 10 principais modelos abertos por provedor

Embora os modelos proprietários geralmente estejam no topo das paradas, os modelos abertos também são emparelhados no modo de batalha e classificados em nossas tabelas de classificação públicas.

Aqui estão os 10 primeiros quando empilhados por modelo aberto superior por provedor.

- # 1 Kimi K2 (MIT modificado) @Kimi_Moonshot

- # 2 DeepSeek R1 0528 (MIT) @deepseek_ai

- # 3 Qwen 235b a22b sem pensar (Apache 2.0) @alibaba_qwen

- #4 MiniMax M1 (MIT) @minimax_ai

- #5 Gemma 3 27b it (Gemma) @googledeepmind

- # 6 Mistral Small Ultra (Apache 2.0) @mistral_ai

- #7 Llama 3.1 Nemotron Ultra 253b v1 (Modelo Nvidia Open) @nvidia

- # 8 Comando A (Cohere) @cohere

- #9 Lhama 4 Maverick Instruct (Lhama 4) @aiatmeta

- #10 OLMo 2 32b Instruir (Apache 2.0) @allen_ai

Veja o tópico para saber um pouco mais sobre os 5 primeiros desta lista 👇

Kimi K2 - #1 na Arena Aberta!

Se você está prestando atenção aos modelos de código aberto, este novo modelo da empresa de IA em ascensão, Moonshot AI, está fazendo ondas como um dos LLMs de código aberto mais impressionantes até hoje. Nossa comunidade nos diz que eles também amam a maneira como Kimi K2 responde: Kimi é bem-humorado sem soar muito robótico.

O Kimi K2 é construído em uma arquitetura de mistura de especialistas (MoE), com um total de 1 trilhão de parâmetros, dos quais 32 bilhões estão ativos durante qualquer inferência. Esse design ajuda o modelo a equilibrar a eficiência e o desempenho sob demanda.

O principal modelo aberto do DeepSeek, DeepSeek R1-0528, ocupa a posição #2

R1-0528 é uma versão refinada de instruções do R1 e o melhor modelo de bate-papo aberto #2 de acordo com a comunidade. Forte em tarefas de diálogo e raciocínio de vários turnos.

R1 (linha de base) é o original, ainda sólido, mas agora um pouco atrás das variantes de ajuste mais recentes.

V3-0324 é um modelo MoE com parâmetros totais de 236B, mas ativa apenas alguns especialistas por prompt. Isso o torna poderoso e eficiente. Ele tem um bom desempenho em tarefas de instrução, raciocínio e multilíngues, mas o formato do prompt é mais importante aqui do que com R1-0528.

Qwen 235b a22b (sem pensar) é o melhor ranking de modelos abertos do Alibaba em # 3

235B-a22b-não-pensar é um modelo bruto sem ajuste de instrução (portanto, "sem pensar").

É ótimo em geração e tem uma classificação alta na comunidade devido ao seu poder de raciocínio bruto.

Alguns outros modelos abertos superiores com nossa comunidade de Alibaba incluem:

As variantes 32B e 30B-a3b são alternativas menores e mais rápidas com desempenho sólido, embora fiquem atrás dos modelos de primeira linha. Com 32B sendo mais denso entre os dois, a comunidade prefere sua precisão a 30B-a3b. 30B-a3b é um modelo MoE que o torna um pouco mais rápido.

O qwq-32b foi projetado especificamente para lidar com problemas complexos de raciocínio e visa igualar o desempenho de modelos maiores como o DeepSeek R1, mas não deixa essa marca quando testado no mundo real.

MiniMax M1 faz a lista com sua classificação de modelo superior em # 4

O M1 também se destaca por sua abordagem única com arquitetura MoE combinada com uma forma de atenção chamada "Lightning Attention", um mecanismo linearizado desenvolvido especificamente para processamento de tokens de alta eficiência.

A abordagem definitivamente chamou a atenção de nossa comunidade por ser muito boa em diálogo, raciocínio e acompanhamento de instruções.

Google DeepMind chega ao #5 com seu modelo aberto superior, Gemma 3 27b it

Gemma 3 é um modelo de linguagem multimodal de peso aberto. O Gemma 3 pode lidar com entradas de texto e imagem, destacando-se em raciocínio, tarefas de contexto longo e aplicativos de linguagem de visão. Nossa comunidade adora como este Gemma melhorou a eficiência da memória e aumentou o suporte para um contexto maior em relação às versões anteriores.

36,93K

Melhores

Classificação

Favoritos