Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

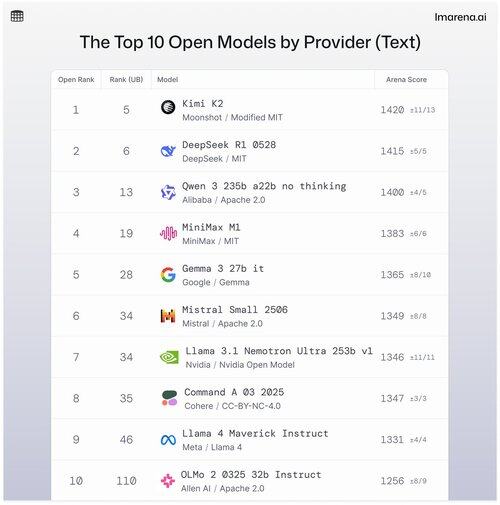

🧵Top 10 modele deschise după furnizor

Deși modelele proprietare sunt adesea în fruntea clasamentelor, modelele deschise sunt, de asemenea, asociate în modul de luptă și clasate în clasamentele noastre publice.

Iată primele 10 atunci când sunt stivuite după modelul deschis de top după furnizor.

- #1 Kimi K2 (MIT modificat) @Kimi_Moonshot

- #2 DeepSeek R1 0528 (MIT) @deepseek_ai

- #3 Qwen 235b a22b fără gândire (Apache 2.0) @alibaba_qwen

- #4 MiniMax M1 (MIT) @minimax_ai

- #5 Gemma 3 27b it (Gemma) @googledeepmind

- #6 Mistral Small Ultra (Apache 2.0) @mistral_ai

- #7 Llama 3.1 Nemotron Ultra 253b v1 (Nvidia Open Model) @nvidia

- #8 Comanda A (coerentă) @cohere

- #9 Llama 4 Maverick Instruct (Llama 4) @aiatmeta

- #10 OLMo 2 32b Instruct (Apache 2.0) @allen_ai

Vezi subiectul pentru a afla mai multe despre primele 5 din această listă 👇

Kimi K2 - #1 în arena deschisă!

Dacă ați acordat atenție modelelor open source, acest nou model de la compania AI în ascensiune, Moonshot AI, face valuri ca unul dintre cele mai impresionante LLM-uri open-source de până acum. Comunitatea noastră ne spune că le place și modul în care Kimi K2 răspunde: Kimi este plin de umor fără a părea prea robotic.

Kimi K2 este construit pe o arhitectură de amestec de experți (MoE), cu un total de 1 trilion de parametri, dintre care 32 de miliarde sunt activi în timpul oricărei inferențe date. Acest design ajută modelul să echilibreze eficiența și performanța la cerere.

Cel mai bun model deschis al DeepSeek, DeepSeek R1-0528, ocupă locul #2

R1-0528 este o versiune rafinată a R1 și cel mai bun model de chat deschis #2 conform comunității. Puternic în dialogul cu mai multe ture și sarcinile de raționament.

R1 (linia de bază) este originalul, încă solid, dar acum puțin în urma noilor variante de tuning.

V3-0324 este un model MoE cu parametri totali de 236B, dar activează doar câțiva experți pe prompt. Acest lucru îl face atât puternic, cât și eficient. Se comportă bine în toate sarcinile de instruire, raționament și multilingve, dar formatul prompt contează mai mult aici decât cu R1-0528.

Qwen 235b a22b (fără gândire) este cel mai bun model deschis Alibaba pe locul #3

235B-a22b-no-thinking este un model brut fără reglare a instrucțiunilor (deci "fără gândire").

Este grozav la generare și se clasează foarte bine în comunitate datorită puterii sale brute de raționament.

Alte modele deschise de top cu comunitatea noastră de la Alibaba includ:

Variantele 32B și 30B-a3b sunt alternative mai mici, mai rapide, cu performanțe solide, deși rămân în urma modelelor de top. Având în vedere că 32B este mai dens dintre cele două, comunitatea preferă precizia sa față de 30B-a3b. 30B-a3b este un model MoE, ceea ce îl face puțin mai rapid.

qwq-32b este special conceput pentru a aborda probleme complexe de raționament și își propune să egaleze performanța modelelor mai mari precum DeepSeek R1, dar nu prea face această amprentă atunci când este testat în lumea reală.

MiniMax M1 se află pe listă cu clasamentul modelelor de top pe locul #4

M1 se remarcă și prin abordarea sa unică, cu arhitectura MoE combinată cu o formă de atenție numită "Lightning Attention", un mecanism liniarizat construit special pentru procesarea token-urilor de înaltă eficiență.

Abordarea a atras cu siguranță atenția comunității noastre pentru că este foarte bună la dialog, raționament și urmărirea instrucțiunilor.

Google DeepMind aterizează pe locul #5 cu modelul lor de top deschis, Gemma 3 27b it

Gemma 3 este un model de limbaj multimodal deschis. Gemma 3 poate gestiona atât intrări de text, cât și imagini, excelând în raționament, sarcini cu context lung și aplicații în limbajul viziunii. Comunitatea noastră apreciază modul în care acest Gemma a îmbunătățit eficiența memoriei și a crescut suportul pentru un context mai larg față de versiunile anterioare.

36,95K

Limită superioară

Clasament

Favorite