Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

宝玉

Prompt Engineer, dedikerad till att lära sig och sprida kunskap om AI, mjukvaruteknik och ingenjörsledning.

Idag finns det en nyhet som är mycket populär på Hacker News, nyhetsinnehållet är att Kaliforniens arbetslöshet har stigit till 5,5 %, botten i USA, och teknikindustrin kämpar: "Arbetsmarknaden är för grym".

> Kaliforniens arbetslöshet steg till 5,5 % i juli, den högsta bland någon delstat i USA, enligt uppgifter från delstatsregeringen som offentliggjordes på fredagen. Bakom detta ligger en fortsatt svag sysselsättning inom teknikindustrin och andra kontorsjobb, samt en nedgång på rekryteringsmarknaden.

Nyheterna tillskrev detta till svagheten i tekniksektorn, som är en central del av Kaliforniens ekonomi. Nyheten diskuterades livligt i Hacker News-communityt, och de bakomliggande orsakerna bakom den analyserades från deras egna perspektiv, mycket mer komplexa än vad rubriken antydde.

Jag tycker att den här diskussionen är en bra sammanfattning av varför sysselsättningen inom teknikindustrin just nu är trög.

1. Först och främst är kärnpunkten: säg adjö till de många följderna av "nollränteeran"

Detta är den mest mainstream och djupgående punkten i diskussionen. Många tror att den nuvarande teknikindustrins elände inte orsakas av en enda faktor, utan snarare en dominoeffekt av slutet på nollräntepolitiken (ZIRP) under det senaste decenniet.

- Kapitalbubblan sprack: Från cirka 2012 till 2022 gjorde extremt låga räntor kapital ovanligt billigt. Inflödet av riskkapital (VC) till teknikindustrin har gett upphov till otaliga affärsmodeller som är beroende av "brännande" tillväxt, särskilt krypto- och metaverse-företag som saknar verkligt värde. När Fed höjde räntorna tog eran av billiga pengar slut, och kedjorna av pengar för dessa företag bröts, vilket ledde till många uppsägningar och nedläggningar.

- Obalans mellan utbud och efterfrågan på talanger: Under ZIRP-eran har myten om höga löner i teknikbranschen lockat till sig ett inflöde av talanger. Den massiva expansionen av datavetenskapsprogram (CS) på universitet, blomstringslägren och teknisk invandring har lett till en dramatisk ökning av utbudet av mjukvaruingenjörer under det senaste decenniet. Men i takt med att kapitalet ebbade ut krympte efterfrågesidan, särskilt nystartade företag, kraftigt, vilket skapade ett allvarligt överskott av talanger.

- Spridningseffekter i branscher som bioteknik: Branscher som bioteknik, som också är beroende av långsiktiga högriskinvesteringar, har också drabbats hårt. Dessa branscher är till och med mer beroende av billigt kapital än mjukvaruindustrin. Efter ZIRP:s slut sinade riskkapitalfonderna gradvis, och nystartade företag kunde inte få en ny finansieringsrunda efter att ha fått slut på "runway-fonder" (runway), och var tvungna att säga upp anställda eller gå i konkurs.

> (av tqi): "Enligt min mening är det för tidigt att säga att 'AI' har en betydande inverkan på rekrytering av mjukvaruföretag. En mer trolig förklaring är att mellan 2012 och 2022 ökade talangutbudet för mjukvaruingenjörer avsevärt... På efterfrågesidan investeras VC-fonder i nollränteeran huvudsakligen i nonsenskryptovaluta- och metaverse-företag, varav de flesta inte har lyckats, vilket resulterar i en brist på sena eller nya börsnoterade företag på marknaden som kan absorbera dessa talanger. ”

2. Distansarbetets "tveeggade svärd": en ny våg av global outsourcing

Covid-19-pandemin har populariserat arbete hemifrån (WFH), vilket sågs som en välsignelse av många utvecklare vid den tiden, men nu börjar dess negativa effekter visa sig.

- Banar väg för outsourcing: När utvecklare kämpar för rätten att arbeta helt på distans kanske de inte inser det, vilket också öppnar dörren för företag att lägga ut jobb på entreprenad till lågkostnadsländer. Eftersom alla är på distans, varför inte anställa en indisk eller östeuropeisk ingenjör som bara är 1/5 av en amerikansk ingenjör och är lika bra?

- "Inga Back to Office"-kontor: Vissa kommentatorer anser att den "Return to Office"-politik (RTO) som främjas av teknikföretag delvis syftar till att skydda lokala jobb. När jobbet visar sig vara 100 % avlägset kan det göras var som helst i världen, och lönefördelen för amerikanska ingenjörer kommer inte längre att existera.

- Debatt om outsourcing av kvalitet: Vissa hävdar att outsourcing har pågått i årtionden och att högkvalitativ mjukvaruutveckling fortfarande kräver lokala topptalanger på grund av problem som kommunikationskostnader, tidszonsskillnader och kulturella bakgrunder. De som stöder outsourcingperspektivet anser dock att dessa hinder övervinns i takt med att verktygen för distanssamarbete mognar och ledningsmodellerna förbättras.

> (av aurareturn): "Jag har sagt om HN sedan 2022: alla nordamerikanska utvecklare som stöder helt distansarbete, du kommer att bli förvånad när ditt företag bestämmer sig för att ersätta dig med någon från utlandet. Eftersom allt är avlägset, varför ska företaget anställa dig för 5 gånger priset istället för en utländsk anställd som arbetar hårdare och klagar mindre? ... Att stödja ordern att återvända till kontoret kan rädda din karriär i det långa loppet. ”

3. AI:s roll: Är det ett produktivitetsverktyg, en ursäkt för att säga upp anställda eller en "vampyr"?

När det gäller den roll som artificiell intelligens (AI) spelar i denna våg av förlorade arbetstillfällen finns det en komplex klyfta i diskussionen.

- Begränsad direkt ersättningseffekt: De flesta är överens om att nuvarande AI inte helt kan ersätta erfarna mjukvaruingenjörer. Men det har börjat ersätta vissa juniora och repetitiva uppgifter, till exempel några små konsultuppgifter. En konsult trädde fram och sa att kunden slutade kontakta honom eftersom ChatGPT kunde lösa några mindre buggar.

- Den "perfekta ursäkten" för uppsägningar: En vanlig uppfattning är att AI har blivit den "perfekta ursäkten" för företag att säga upp anställda och minska kostnaderna och öka effektiviteten. Även om grundorsaken till uppsägningar är en ekonomisk nedgång eller ledningsbeslut, paketerar företag det gärna som en strategisk justering för att "omfamna AI och förbättra effektiviteten".

- Kapitalets "svarta hål": AI spelar en annan nyckelroll – den suger bort det enda kvarvarande riskkapitalet på marknaden som kunde ha flödat till andra tekniksektorer. Riskkapitalister är nu nästan uteslutande intresserade av AI-projekt, vilket har förvärrat finansieringssvårigheterna för nystartade företag inom icke-AI-området.

4. Teknikindustrins "rostzon"? Strukturella bekymmer inför framtiden

Vissa paneldeltagare uttryckte oro för framtiden ur ett bredare perspektiv och drog paralleller mellan teknikindustrin och det en gång så ärorika och sedan minskande tillverkningsbältet.

- Upprepade förluster av arbetstillfällen: Precis som USA outsourcade tillverkning till Kina, strömmar nu IT- och mjukvaruutvecklingsjobb till Indien, Latinamerika och Östeuropa i stor skala. Detta kan leda till långsiktig strukturell arbetslöshet för den en gång så välbetalda gruppen av mjukvaruingenjörer.

- Politisk och social påverkan: Om ett betydande antal teknikjobb i medelklassen försvinner kan det utlösa nya sociala och politiska frågor, ungefär som nedgången i rostbältet som fortfarande påverkar det amerikanska politiska landskapet idag.

- Kontrovers om invandring och visumpolitik (H1B/O1): En del av diskussionen pekade finger åt arbetsvisum som H1B och hävdade att de missbrukades, vilket pressade ner lokala ingenjörslöner och ökade konkurrensen. Andra är starka försvarare av kvalificerad migration och hävdar att det är dessa topptalanger från hela världen, till exempel studenter från University of Waterloo, som utgör hörnstenen för innovation i Silicon Valley.

5. Företagsledning och kulturell förändring: "Musk-effekten"

En intressant synpunkt är att Musk har haft en exemplarisk effekt på Twitters (nu X) massiva uppsägningar.

- Rationalisering av uppsägningar: När Musk sade upp mer än 75 % av Twitters anställda var produkten fortfarande funktionell, vilket fick många vd:ar att reflektera: "Eftersom han kan göra det, varför kan inte jag?" Detta bryter tankesättet "mer talang, desto bättre" hos teknikföretag tidigare, vilket gör storskaliga uppsägningar mer acceptabla både psykologiskt och kommersiellt.

6. Politiska och politiska faktorer: Kontrovers om ändringar i skattelagstiftningen

En teknisk men långtgående ledtråd handlar om ändringar i amerikanska skattelagar.

- Avskrivningsregel för FoU-utgifter (avsnitt 174): Det finns en bestämmelse i Trump-administrationens Tax Reform Act (TCJA) från 2017 som kräver att företag skriver av utgifter för forskning och utveckling (FoU), t.ex. löner för programvaruutveckling, i omgångar under fem år från och med 2022, i stället för att dras av helt under innevarande år som tidigare. Detta har kraftigt ökat skattebördan för teknikföretag, särskilt nystartade företag, och avskräckt från anställningsavsikter i USA.

- Återställande effekt av de senaste lagförslagen: Den nyligen antagna BBB-propositionen (Build Back Better) korrigerar delvis detta problem, vilket gör att inhemska FoU-utgifter omedelbart kan dras av igen. Vissa kommentatorer tror att de kände en uppgång på anställningsmarknaden runt juli, vilket kan ha något att göra med det.

Till sist

Att döma av dessa diskussioner är orsakerna till den nuvarande sysselsättningsnedgången i Kaliforniens teknikindustri ganska komplexa, inte orsakade av en enda faktor, och den kan inte heller bara tillskrivas "AI som ersätter människor" eller "cyklisk lågkonjunktur i branschen", utan resultatet av den ekonomiska recessionen efter slutet av nollränteeran, omstruktureringen av den globala arbetsmarknaden till följd av distansarbete, den dubbla effekten av AI som en ny teknik och en kapitalmagnet och förändringar i specifik skattepolitik.

Jag vet inte när jag kommer att ta mig ur den här knipan? Eller så är anledningen inte bara dessa som diskuterats ovan

76,46K

Översättning: Varför stora språkmodeller inte riktigt kan bygga programvara

Av Conrad Irwin

En sak som jag ägnar mycket tid åt är att intervjua mjukvaruingenjörer. Detta är naturligtvis en svår uppgift, och jag vågar inte säga att jag har några knep. Men det gav mig tid att reflektera över vad en effektiv mjukvaruingenjör gör.

Kärnan i programvaruteknik

När du tittar på en sann finsmakare kommer du att se att de alltid utför följande steg i en cykel:

* Bygg en mental modell av behov.

* Skriva (förhoppningsvis?!) ) som genomför kraven.

* Bygg en mental modell av hur din kod faktiskt beter sig.

* Hitta skillnaden mellan de två och uppdatera sedan koden (eller kravet).

Det finns många sätt att utföra dessa steg, men det fina med effektiva ingenjörer är deras förmåga att bygga och underhålla tydliga mentala modeller.

Hur presterar stora språkmodeller?

För att vara rättvis är stora språkmodeller ganska bra på att skriva kod. De gör också ett bra jobb med att uppdatera koden när du påpekar problemet. De kan också göra alla de saker som en riktig ingenjör skulle göra: läsa kod, skriva och köra tester, lägga till loggar och (förmodligen) använda felsökaren.

Men vad de inte kan göra är att upprätthålla en tydlig mental modell.

Stora språkmodeller kommer att hamna i oändlig förvirring: de kommer att anta att koden de skriver faktiskt är användbar; När ett test misslyckas kan de bara gissa om det är en fixkod eller ett test fixat; När de blir frustrerade klipper de helt enkelt ut allt och börjar om.

Detta är raka motsatsen till vad jag skulle förvänta mig av en ingenjör.

Programvaruingenjörer testar medan de arbetar. När ett test misslyckas kan de använda sin mentala modell för att avgöra om de ska åtgärda koden eller testet, eller samla in mer information innan de fattar ett beslut. När de känner sig frustrerade kan de be om hjälp genom att kommunicera med människor. Även om de ibland raderar allt och börjar om, är det ett val som görs efter en tydligare förståelse av problemet.

Men det kommer att bli snart, eller hur?

Kommer detta att förändras i takt med att modellerna blir mer kapabla? Kanske?? Men jag tror att detta kräver en grundläggande förändring av hur modeller byggs och optimeras. Programvaruteknik kräver modeller som är mer än att bara generera kod.

När en person stöter på ett problem kan han eller hon tillfälligt lägga hela sammanhanget åt sidan och fokusera på att lösa det aktuella problemet, och sedan återvända till det stora problemet. De kan också växla mellan den stora bilden och mikrodetaljerna, tillfälligt ignorera detaljerna för att fokusera på helheten och gräva i delarna när det behövs. Vi blir inte mer produktiva bara för att vi klämmer in fler ord i vårt "kontextfönster", det kommer bara att göra oss galna.

Även om vi kan hantera en stor mängd kontext vet vi att dessa generativa modeller för närvarande har flera allvarliga problem som direkt påverkar deras förmåga att upprätthålla tydliga mentala modeller:

* Kontextuellt utelämnande: Modeller är inte bra på att upptäcka förbisedd kontextuell information.

* Recency bias: De är föremål för allvarlig recency bias när de arbetar med kontextfönster.

* Hallucinationer: De "fantiser" ofta om detaljer som inte borde finnas.

Dessa problem kanske inte är oöverstigliga, och forskare arbetar med att lägga till minne till modeller så att de kan utöva liknande tankeförmåga som vi gör. Men tyvärr, för tillfället, kan de (efter att ha gått bortom en viss nivå av komplexitet) inte riktigt förstå vad som verkligen hände.

De kan inte bygga programvara eftersom de inte kan underhålla två liknande "mentala modeller" samtidigt, ta reda på skillnaderna och bestämma om de ska uppdatera kod eller uppdatera kraven.

Så, vad händer nu?

Det är uppenbart att stora språkmodeller är användbara för programvaruingenjörer. De genererar kod snabbt och utmärker sig när det gäller att integrera krav och dokumentation. För vissa uppgifter räcker det: kraven är tillräckligt tydliga, problemen är så enkla att de kan göras över en natt.

Med det sagt, för alla uppgifter av viss komplexitet, kan de inte upprätthålla tillräckligt med kontext exakt för att iterera för att slutligen producera en genomförbar lösning. Som mjukvaruingenjör är du fortfarande ansvarig för att se till att kraven är tydliga och att koden faktiskt levererar vad den påstår sig göra.

På Zed tror vi på en framtid där människor och AI-agenter kan bygga mjukvara tillsammans. Vi är dock övertygade (åtminstone för tillfället) om att det är du som sitter bakom ratten och att stora språkmodeller bara är ytterligare ett verktyg du har nära till hands.

74,71K

宝玉 delade inlägget

Igår var jag på CSDN's Product Manager Conference för att hålla en presentation.

När mina vänner på CSDN bjöd in mig att hålla ett tal på Product Manager Conference för tre månader sedan ville jag faktiskt tacka nej.

Anledningen är att min startup bara har varit etablerad i ett halvår, och jag har inte mycket insikt att dela med mig av till er.

CSDN-vänner sa dock att det inte spelar någon roll, konferensen är fortfarande tre månader bort och det finns fortfarande tid, och vi kan också dela med oss av lite tidigare produkterfarenheter.

Av en slump, efter att vi släppte FlowSpeech förra veckan, exploderade produktryktet, MRR ökade med 3 gånger, ARR bröt också ett litet mål, och ännu viktigare, våra användare tjänade riktiga pengar genom att använda produkten, vilket är det bästa beviset på styrkan i vår produkt.

Så när jag höll ett tal igår, skämtade jag med er om att guldinnehållet i denna PPT idag har skjutit i höjden, snälla lyssna noga.

46,33K

"Som bonde köper jag bara ekologisk mat; Som AI-utövare tittar jag bara på innehåll som inte är AI-genererat." 😅

马东锡 NLP 🇸🇪15 aug. 16:12

Jag vet inte hur det är med dig, men som AI-utövare vägrar jag instinktivt att gå in i något AI-genererat.

När jag granskar koden, när jag känner att den är skriven av AI, skriver jag LGTM direkt.

När du läser en artikel, så länge du märker att den är AI-genererad, stäng av den omedelbart.

Om webbplatsens användargränssnitt ser AI-genererat ut, stäng av det omedelbart.

Om podcasten är AI-genererad, stäng av den omedelbart.

Om den korta videon är AI-genererad, stryk över den omedelbart och ersätt den med en begagnad bilhandlare eller en video av reparation av en åsnas hovar.

Jag känner att det är oansvarigt för min kropp och själ att låta AI-genererat innehåll lura mina dopaminendorfiner.

AI-genererat innehåll är förvisso värdefullt, men det är begränsat till mellanliggande mänsklig input och output, och bör inte och kan inte cirkulera som en slutlig form under lång tid.

62,46K

Vibe Coding är en dålig term och vilseledande, och dess största betydelse är att den använder AI för prototyper, vilket kan hjälpa till att snabbt fastställa produktkrav. Inom programvaruteknik överges vanligtvis koden för prototyputveckling, och systemet måste designas om, kodas och implementeras när produkten officiellt utvecklas.

铁锤人14 aug. 21:07

Det uppskattas att många inte vet vad Vibe Coding är?

Termen myntades av den artificiella intelligensens gud Andre Karpathy,

När du beskriver problemet för AI:n skriver den sin egen kod.

Endast för enkla helgprojekt som bara du kommer att använda

Eftersom det är ett oviktigt projekt kan han agera på sina känslor utan att egentligen behöva planera eller testa.

👇 Det är där drömmarna börjar

48,34K

I kontextteknik måste agenten använda verktyg och miljöer för att hämta data och slutföra kontexten

dontbesilent14 aug. 05:13

Plötsligt förstod jag vad claude-kod och komet handlar om, och varför agenter dyker upp i CLI och webbläsare, och har blivit vanliga val

Var agenten dyker upp spelar roll!

Utvecklare gillar att använda claude-kod eftersom deras kod kan styras via CLI, och koden är faktiskt kontexten för kommunikation med den stora modellen

Men jag slängde runt idag och fann att människor som gör självmedia inte kan använda det, eftersom människor som gör självmedia inte har något i sina datorer alls, och kärninnehållet finns i appar och webbläsare

Claude-kod är dock svårt att få saker i webbläsare och appar, så kärnproblemet är inte om jag använder sonnet eller opus, utan att denna agent inte ska visas i kommandoraden

Den här agenten bör visas i webbläsaren! Till exempel har Douyin sprängt coze-arbetsflödet som fångar Xiaohongshu-data, och det görs direkt med COMET

För dem som sysslar med självmedia är kometen den verkliga claude-koden, eftersom agenten för självmediepersonen måste visas i webbläsaren

Den tidigare dia-webbläsaren var dum jämfört med den tidigare dia-webbläsaren, som inte var en agent, utan en LLM

Om du bara kopplar in en LLM i webbläsaren tror jag att det är lite meningsfullt

15,12K

Datavetenskap Självstudier Tutorial TeachYourselfCS

Om du är en självlärd ingenjör eller tog examen från en programmeringskurs, är det nödvändigt för dig att studera datavetenskap. Lyckligtvis behöver du inte spendera år och mycket pengar på en examen: du kan få en utbildning 💸 i världsklass på egen hand.

På Internet finns det många lärresurser överallt, men essensen och slagget samexisterar. Istället för en lista som "200+ gratis onlinekurser" behöver du svar på frågor som:

Vilka ämnen ska du studera och varför?

Vilken är den bästa boken eller videokursen för dessa ämnen?

I den här guiden försöker vi ge definitiva svar på dessa frågor.

Deedy14 aug. 09:59

"Lär dig själv datavetenskap" är den bästa resursen för att lära sig datavetenskap.

2 veckor in i vibe-kodning och icke-tekniska människor känner smärtan. – Jag önskar verkligen att jag var teknisk. Jag vet bara inte hur jag ska gå vidare."

Det tar ~1000 timmar över 9 ämnen att förstå CS med något djup.

152,09K

宝玉 delade inlägget

Här kommer mina vänner~ Jag tjänar bara 20 yuan för 3 miljoner användare: den falska boomen av AI-verktyg - ListenHub

Vem skulle inte dra ett skämt. Många människor var intresserade av det fall som jag delade med mig av på Hard Ground Hacking, och jag gjorde en podcast specifikt på @oran_ge:s ListenHub. Du kan lyssna på den ~

29,24K

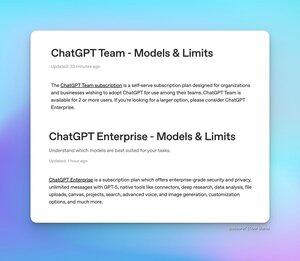

Många vänner är oroade över användningsbegränsningarna för ChatGPT Team och Enterprise, och nu har två nya artiklar med vanliga frågor (FAQ) släppts för att förklara detta.

* ChatGPT Team Edition - GPT-5 och GPT-4o är obegränsade, men det finns följande begränsningar för olika modellversioner:

* 200 GPT-5 Thinking-förfrågningar per dag

* 2800 GPT-5 Tänkande miniförfrågningar per vecka

* 15 GPT-5 Pro-förfrågningar per månad

* 3 GPT-500-förfrågningar var 4,1:e timme

* 300 O4-Mini- och O3-förfrågningar per dag

* ChatGPT Enterprise - GPT-5, GPT-4o och GPT-4.1-mini är obegränsade, men det finns följande begränsningar för olika modellversioner:

* 200 GPT-5 Thinking-förfrågningar per vecka

* 15 GPT-5 Pro-förfrågningar per månad

* 20 GPT-4.5-förfrågningar per vecka

* 3 GPT-500-förfrågningar var 4,1:e timme

* 300 O4-Mini-förfrågningar per dag

* 100 o4-mini-höga förfrågningar per dag

* 100 o3 förfrågningar per vecka

* 15 O3-Pro-förfrågningar per månad

I FAQ-artikeln nämns också att de nuvarande begränsningarna i GPT-5 Thinking-modellen är tillfälliga och faktiskt är högre än de långsiktiga gränser som anges ovan.

Tibor Blaho14 aug. 03:17

För alla som frågar om gränserna för ChatGPT Team & Enterprise - det finns 2 nya FAQ-artiklar

- ChatGPT Team - obegränsat antal GPT-5- och GPT-4o-förfrågningar, 200 GPT-5-tankeförfrågningar/dag, 2800 GPT-5 Thinking mini-förfrågningar/vecka, 15 GPT-5 Pro-förfrågningar/månad, 500 GPT-4.1-förfrågningar/3 timmar, 300 o4-mini- och o3-förfrågningar/dag

- ChatGPT Enterprise - obegränsad GPT-5, GPT-4o och GPT-4.1-mini, 200 GPT-5 Thinking-förfrågningar/vecka, 15 GPT-5 Pro-förfrågningar/månad, 20 GPT-4.5-förfrågningar/vecka, 500 GPT-4.1-förfrågningar/3 timmar, 300 o4-mini-förfrågningar/dag, 100 o4-mini-high förfrågningar/dag, 100 o3-förfrågningar/vecka, 15 o3-pro-förfrågningar/månad

I FAQ-artikeln nämns att GPT-5-tänkandets gränser tillfälligt är högre än de långsiktiga räntorna som visas ovan

15,56K

Detta är sant: mindre i uppmaningen att säga vad man inte ska göra, utan vad man ska göra. Den stora modellen är väldigt lik människor, och ju mer du inte låter den göra det, desto lättare är det att dra till sig uppmärksamhet

素人极客-Amateur Geek13 aug. 23:50

När du vill att modellen ska förbjudas eller inte,

Försök att inte skriva direkt!!

Försök att inte skriva direkt!!

Försök att inte skriva direkt!!

Här är några enkla metoder:

1. Skriv fler än två

2. Vänd det du inte vill ha till vill ha. Skriv inte sjuka meningar - du måste kontrollera mening för mening för att säkerställa föraningar, början och samband före och efter varje mening

3. Förbjudet innehåll från förbjudet till flera framträdanden. Vissa saker kan man inte komma ihåg när man en gång har sagt. När jag gick i skolan sa min japanska lärare att det finns en speciell plats i japanska företag som gör sig besväret att förklara en enkel sak så att du inte glömmer, även de minsta sakerna, om du nämner dem många gånger kommer de att bli ihågkomna. Du kan förbjuda i början, i mitten, där det är relaterat, och i slutet.

4. Förbudet är att inte göra det, lägg sedan till ett steg, slutför en sak i taget, gör det till två steg, lägg till en mening i slutet, låt dig slutföra ovanstående åtgärder, fråga mig om det finns några förbjudna föremål, jag skickar dig de förbjudna föremålen, och sedan börjar vi granska de förbjudna föremålen, och när vi delvis ändrar, se till att annan information förblir oförändrad.

5. Lägg de förbjudna föremålen i det första steget.

6. Ta reda på om dina förbud kan förbjudas. Till exempel, om du inte bestämmer stilen på copywritern, och texten har en AI-smak, är det meningslöst för dig att förbjuda honom från att använda AI-ton, och han vet inte vilken ton han använder!

63,89K

Topp

Rankning

Favoriter

Trendande på kedjan

Trendande på X

Senaste toppfinansieringarna

Mest anmärkningsvärda