熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

“你聽,他依然滔滔不絕,但這一次,我們終於能確認他講了什麼。”

Mira @Mira_Network 也許從來沒想過讓 AI 更像人,它只是想讓 AI 每說一句話,都能留下被可驗證的證據。

讓這個時代最強的“黑箱”,在鏈上成為最透明的存在。

____ 🁢🁢🁢 ____🁢🁢🁢 ____ 🁢🁢🁢 ____ 🁢🁢🁢 ____ 🁢🁢🁢 ____

Mira @Mira_Network :給高速行駛的AI 裝上剎車,而不是添一雙翅膀

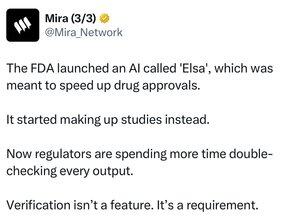

AI 可以說話,可以寫代碼,可以模擬情緒,但它到底能不能被信任?這一點Mira @Mira_Network 來做解決。

Mira 的回答很明確:不是看它說得多像人,而是看它能不能留下“說過這話”是否值得每一個人去推敲。

這正是 Mira @Mira_Network 與絕大多數 AI 項目最大的分歧,它不追逐表現自己有多“聰明”,它反其道而行之,決定構建“可信”底座。

它不信任任何一個模型的表象,而是在底層架構中,為 AI 的每一次動作、每一句回答、每一個判斷,都嵌入可驗證的軌跡。

這不是優化體驗,而是定義“答案”。

____ 🁢🁢🁢 ____🁢🁢🁢 ____ 🁢🁢🁢 ____ 🁢🁢🁢 ____ 🁢🁢🁢 ____

AI 永遠是工具,不是主體。

也許這句話帶著我的主觀臆斷,但它也正是 Mira @Mira_Network 想要重新釐清的底層秩序。

AI 不是你的老闆,不是你的同事,而是你手中一件趁手的工具,更像戰士用來決勝的劍,越鋒利,越需要握在可控的手裏。

它可以高效、可以自洽、可以擬人,但最終必須被監督、必須在鏈上簽名、必須留下證據、必須接受驗證。這不是體驗層的優化,而是一種結構性約束,它不允許 AI 自行生長、脫離規則,而是強制它在人的權限框架下行動。

這正是 Mira @Mira_Network 的設計原點:讓驗證常態化,讓監督成為系統本身的一部分。你或許不需要理解它的模型細節,不必精通它的圖譜結構,但你必須意識到,如果沒有驗證機制,AI 所說的一切就等於沒說,你難斷真假,難辨是非。

____ 🁢🁢🁢 ____🁢🁢🁢 ____ 🁢🁢🁢 ____ 🁢🁢🁢 ____ 🁢🁢🁢 ____

看到這裡如果你認同 AI 是一個需要被限制、被證明、被規訓的技術工具,那你就很難繞過 Mira @Mira_Network 。

因為在它的世界裡,AI 永遠說得出話,也必須擔得起責任,經得起反覆的驗證,最終一句可信的話展現在你面前。

9K

熱門

排行

收藏