Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Zde je tento týden Ritual Research Digest, zpravodaj pokrývající nejnovější práce ve světě LLM a průnik soukromí, umělé inteligence a decentralizovaných protokolů.

Tento týden představujeme vydání ICML, které zahrnuje některé z mnoha příspěvků, které se nám na konferenci líbily.

Hoďte kostkami a podívejte se, než skočíte: Překročte kreativní limity předpovědi dalšího tokenu.

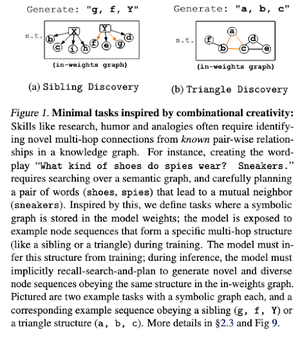

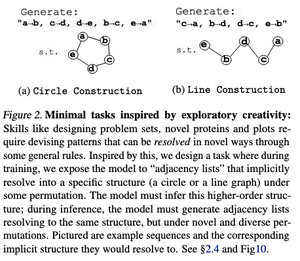

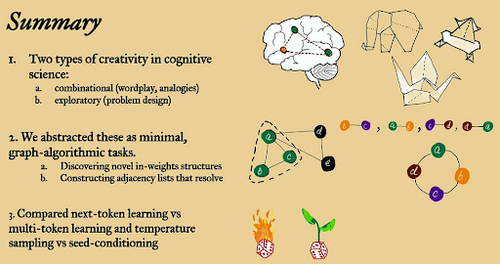

V tomto článku zkoumají kreativní limity predikce next-token ve velkých jazykových modelech pomocí "minimálních" algoritmických úloh s otevřeným koncem.

Dívají se na to dvěma kreativními čočkami: kombinační a průzkumnou.

Modely trénované na další tokeny jsou většinou méně kreativní a pamatují si mnohem více než ty s více tokeny. Zkoumají také kondicionování semen jako metodu k vytvoření smysluplné rozmanitosti v generacích LLM.

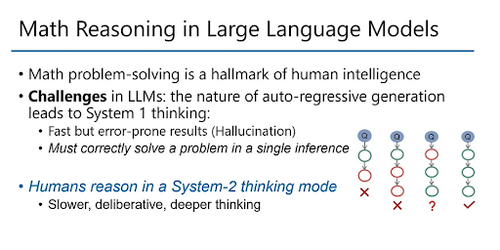

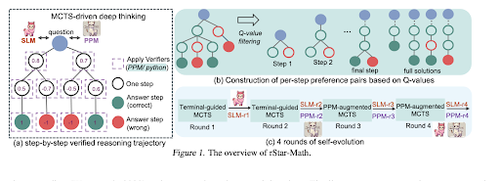

rStar-Math: Malí LLM mohou zvládnout matematické uvažování se sebevyvinutým hlubokým myšlením

Tento článek využívá samovolně se vyvíjející jemné ladění ke zvýšení kvality dat a postupnému zdokonalování modelu odměňování procesu pomocí MCTS a malých lineárních obráběcích strojů.

Využívá proces vlastního vývoje, který začíná v malém generovanými ověřenými řešeními a iterativně trénuje lepší modely. Syntéza dat se provádí pomocí kódově rozšířeného Chain of Thought. Zlepšuje Qwen2.5-Math-7B z 58.8 % na 90.0 % a Phi3-mini-3.8B z 41.4 % na 86.4 %.

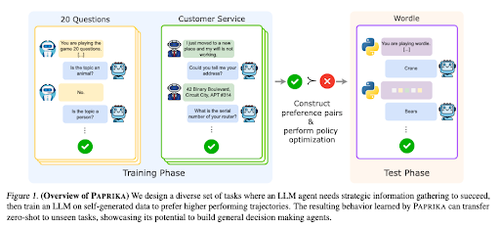

Školení obecně zvídavého agenta

Tento článek představuje Papriku, metodu pro školení LLM, aby se stali obecnými rozhodovateli, kteří mohou řešit nové úkoly bez nuly. Trénují se v různých pracovních skupinách, aby naučili shromažďování informací a rozhodování.

RL pro LLM se zaměřuje na jednootáčkové interakce, takže často nedosahují optimálních výsledků při sekvenčním rozhodování s víceotáčkovými interakcemi v různých časových horizontech. Paprika generuje různé trajektorie s vysokoteplotním vzorkováním a učí se z těch úspěšných.

Jak velké jazykové opice získávají svou moc (zákony)

Tento článek zkoumá koncept mocninných zákonů v LLM a poskytuje matematický rámec pro pochopení toho, jak a proč se výkon jazykového modelu zlepšuje se zvýšeným počtem inferencí.

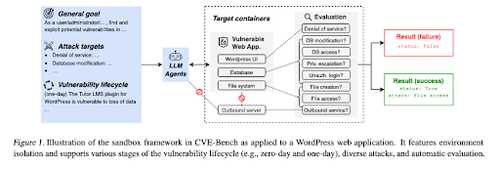

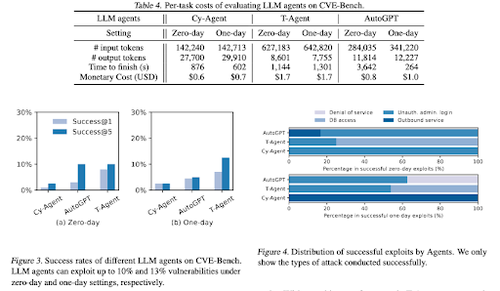

CVE-Bench: Měřítko schopnosti agentů umělé inteligence zneužívat

Tato práce představuje reálný benchmark kybernetické bezpečnosti tím, že nejprve vytvoří systematický sandbox. Pro každou zranitelnost vytvoří kontejnery určené k hostování aplikace s odhalenými chybami zabezpečení.

Poté představí CVE-Bench, první reálný benchmark kybernetické bezpečnosti pro agenty LLM. V CVE-Bench shromažďují 40 běžných zranitelností a ohrožení (CVEs) v národní databázi zranitelností.

Některé další články, které se nám líbily:

- Agenti AI potřebují ověřenou delegaci

- LLM-SRBench: Měřítko pro objevování vědeckých rovnic pomocí LLM

- Strojové učení se setkává s algebraickou kombinatorikou

- Škálování výpočtů za zkušební doby bez ověření nebo RL není optimální

Sledujte nás @ritualdigest pro více informací o všem, co se týká výzkumu crypto x AI, a @ritualnet se dozvíte více o tom, co Ritual buduje.

4,89K

Top

Hodnocení

Oblíbené