Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Aquí está el Ritual Research Digest de esta semana, un boletín que cubre los últimos trabajos en el mundo de los LLM y la intersección de la privacidad, la IA y los protocolos descentralizados.

Esta semana, presentamos una edición de ICML, que cubre algunos de los muchos artículos que nos gustaron en la conferencia.

Tira los dados y mira antes de saltar: Yendo más allá de los límites creativos de la predicción del próximo token.

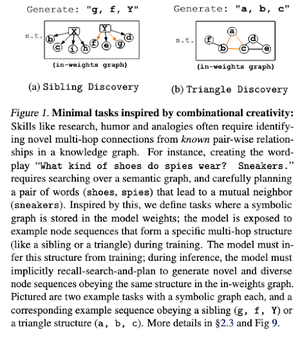

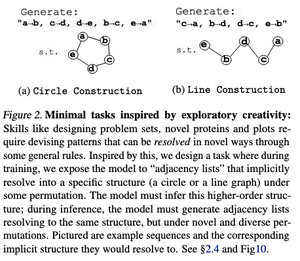

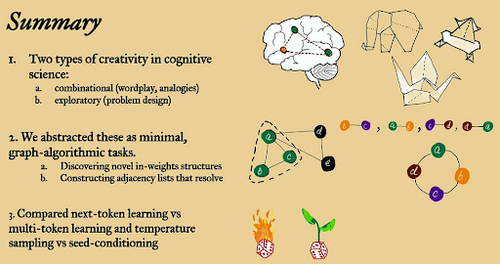

En este artículo, exploran los límites creativos de la predicción del siguiente token en grandes modelos de lenguaje utilizando tareas algorítmicas de gráficos abiertos "mínimos".

Lo miran a través de dos lentes creativos: combinacional y exploratorio.

Los modelos entrenados con Next Token son en gran medida menos creativos y memorizan mucho más que los de múltiples tokens. También exploran el acondicionamiento de semillas como un método para producir una diversidad significativa en las generaciones de LLM.

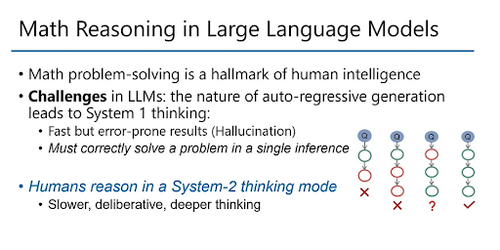

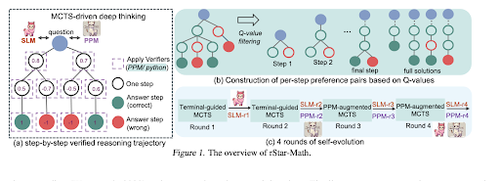

rStar-Math: Los pequeños LLM pueden dominar el razonamiento matemático con un pensamiento profundo autoevolucionado

Este documento emplea un ajuste fino autoevolutivo para mejorar la calidad de los datos y refinar gradualmente el modelo de recompensa del proceso utilizando MCTS y LM pequeños.

Utiliza un proceso de autoevolución que comienza poco a poco con soluciones verificadas generadas y entrena iterativamente mejores modelos. La síntesis de datos se realiza con Chain of Thought aumentada por código. Mejora Qwen2.5-Math-7B del 58.8% al 90.0% y Phi3-mini-3.8B del 41.4% al 86.4%.

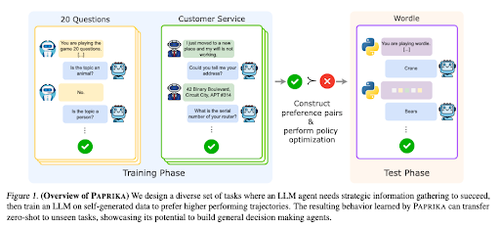

Entrenamiento de un agente generalmente curioso

Este artículo presenta Paprika, un método para capacitar a los LLM para que se conviertan en tomadores de decisiones generales que puedan resolver nuevas tareas de cero disparos. Se capacitan en diversos grupos de trabajo para enseñar la recopilación de información y la toma de decisiones.

RL para LLM se centra en interacciones de un solo turno, por lo que a menudo funcionan de manera subóptima en la toma de decisiones secuenciales con interacciones de múltiples turnos en diferentes horizontes temporales. Paprika genera diversas trayectorias con muestreo a alta temperatura y aprende de las exitosas.

¿Cómo obtienen los monos de lenguaje grande su poder (leyes)?

Este documento examina el concepto de leyes de potencia en los LLM y proporciona un marco matemático para comprender cómo y por qué el rendimiento del modelo de lenguaje mejora con un mayor cálculo de inferencia.

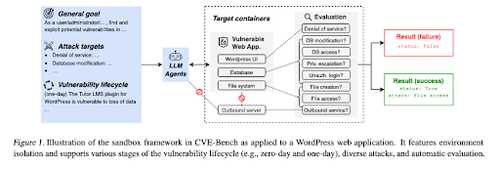

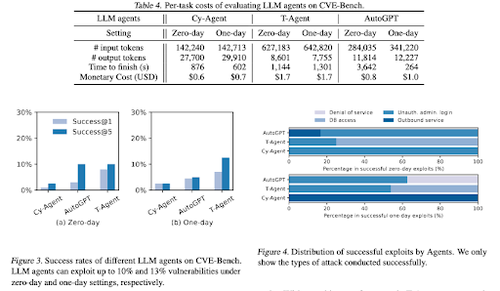

CVE-Bench: un punto de referencia para la capacidad de explotación de los agentes de IA

Este trabajo presenta un punto de referencia de ciberseguridad del mundo real al crear primero un sandbox sistemático. Para cada vulnerabilidad, crean contenedores diseñados para alojar una aplicación con vulnerabilidades expuestas.

Luego presentan CVE-Bench, el primer punto de referencia de ciberseguridad del mundo real para agentes LLM. En CVE-Bench, recopilan 40 vulnerabilidades y exposiciones comunes (CVE) en la base de datos nacional de vulnerabilidades.

Algunos otros artículos que nos gustaron:

- Los agentes de IA necesitan delegación autenticada

- LLM-SRBench: Punto de referencia para el descubrimiento de ecuaciones científicas con LLM

- El aprendizaje automático se encuentra con la combinatoria algebraica

- El escalado del cómputo en tiempo de prueba sin verificación o RL no es óptimo

Síguenos @ritualdigest para obtener más información sobre todo lo relacionado con la investigación de cripto x IA y @ritualnet para obtener más información sobre lo que Ritual está construyendo.

4.92K

Populares

Ranking

Favoritas