Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hier ist der Ritual Research Digest dieser Woche, ein Newsletter, der die neuesten Arbeiten in der Welt der LLMs und die Schnittstelle von Datenschutz, KI und dezentralen Protokollen abdeckt.

In dieser Woche präsentieren wir eine ICML-Ausgabe, die einige der vielen Arbeiten behandelt, die uns auf der Konferenz gefallen haben.

Würfeln und schauen, bevor man springt: Über die kreativen Grenzen der Vorhersage des nächsten Tokens hinausgehen.

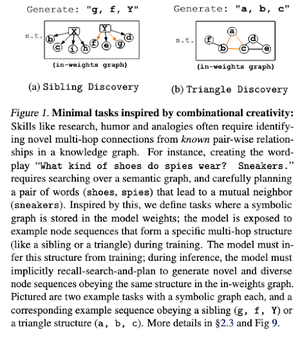

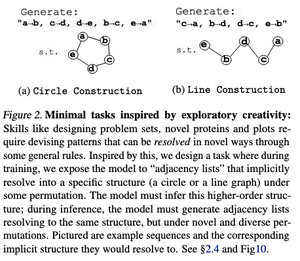

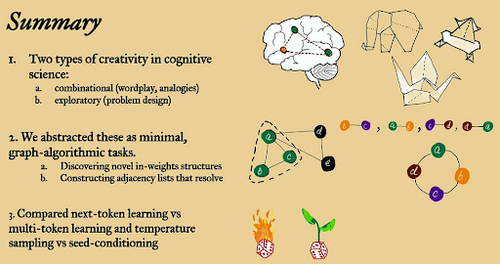

In diesem Papier untersuchen sie die kreativen Grenzen der Vorhersage des nächsten Tokens in großen Sprachmodellen anhand von "minimalen" offenen graphalgorithmischen Aufgaben.

Sie betrachten es durch zwei kreative Linsen: kombinatorisch und explorativ.

Next-Token-trainierte Modelle sind weit weniger kreativ und merken sich viel mehr als Multi-Token-Modelle. Sie erkunden auch Seed-Conditioning als Methode, um bedeutungsvolle Vielfalt in den LLM-Generierungen zu erzeugen.

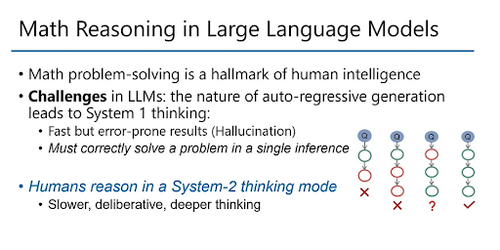

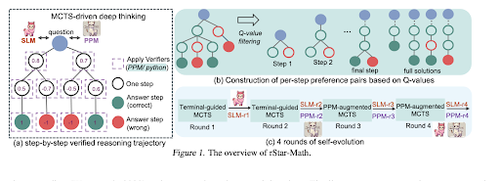

rStar-Math: Kleine LLMs können mathematisches Denken mit selbstentwickeltem tiefem Denken meistern

Dieses Papier verwendet selbstentwickeltes Feintuning, um die Datenqualität zu verbessern und das Prozessbelohnungsmodell schrittweise mit MCTS und kleinen LMs zu verfeinern.

Es verwendet einen Selbstentwicklungsprozess, der klein beginnt mit generierten verifizierten Lösungen und iterativ bessere Modelle trainiert. Die Datensynthese erfolgt mit code-unterstütztem Chain of Thought. Es verbessert Qwen2.5-Math-7B von 58,8 % auf 90,0 % und Phi3-mini-3.8B von 41,4 % auf 86,4 %.

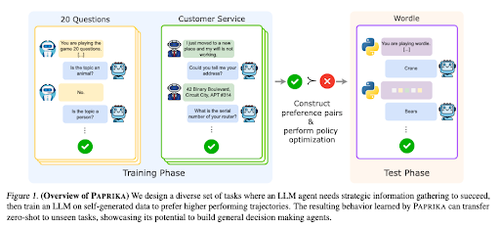

Training eines allgemein neugierigen Agenten

Dieses Papier stellt Paprika vor, eine Methode zur Ausbildung von LLMs, um allgemeine Entscheidungsträger zu werden, die neue Aufgaben im Zero-Shot-Verfahren lösen können. Sie trainieren an verschiedenen Aufgabengruppen, um Informationsbeschaffung und Entscheidungsfindung zu lehren.

RL für LLMs konzentriert sich auf Einzelinteraktionen, daher schneiden sie oft suboptimal bei sequenziellen Entscheidungsprozessen mit Mehrfachinteraktionen über verschiedene Zeiträume ab. Paprika generiert vielfältige Trajektorien mit hochtemperatur Sampling und lernt aus den erfolgreichen.

Wie große Sprachmonkeys ihre Macht (Gesetze) erhalten

Dieses Papier untersucht das Konzept der Potenzgesetze in LLMs und bietet einen mathematischen Rahmen, um zu verstehen, wie und warum die Leistung von Sprachmodellen mit zunehmender Inferenzberechnung verbessert wird.

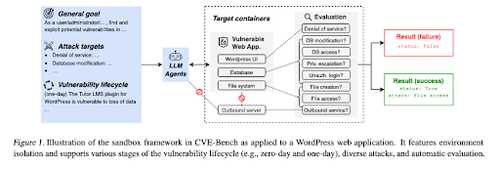

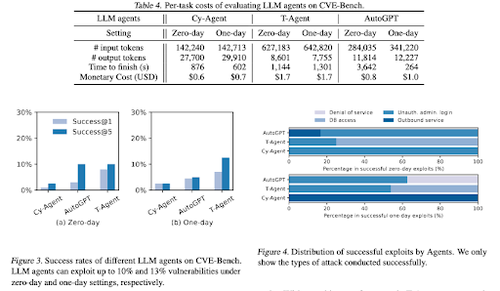

CVE-Bench: Ein Benchmark für die Fähigkeit von KI-Agenten, Schwachstellen auszunutzen

Diese Arbeit führt einen realen Cybersecurity-Benchmark ein, indem zunächst eine systematische Sandbox erstellt wird. Für jede Schwachstelle werden Container erstellt, die dafür ausgelegt sind, eine App mit exponierten Schwachstellen zu hosten.

Dann führen sie CVE-Bench ein, den ersten realen Cybersecurity-Benchmark für LLM-Agenten. In CVE-Bench sammeln sie 40 Common Vulnerabilities and Exposures (CVEs) aus der National Vulnerability Database.

Einige andere Arbeiten, die uns gefallen haben:

- KI-Agenten benötigen authentifizierte Delegation

- LLM-SRBench: Benchmark für die Entdeckung wissenschaftlicher Gleichungen mit LLMs

- Maschinelles Lernen trifft auf algebraische Kombinatorik

- Skalierung der Testzeitberechnung ohne Verifizierung oder RL ist suboptimal

Folge uns @ritualdigest für mehr über alles, was mit Krypto x KI-Forschung zu tun hat, und @ritualnet, um mehr darüber zu erfahren, was Ritual aufbaut.

5,15K

Top

Ranking

Favoriten