Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ecco il Digest di Ricerca Rituale di questa settimana, una newsletter che copre gli ultimi lavori nel mondo degli LLM e l'intersezione tra privacy, AI e protocolli decentralizzati.

Questa settimana, presentiamo un'edizione ICML, che copre alcuni dei tanti articoli che ci sono piaciuti alla conferenza.

Lancia i dadi e guarda prima di saltare: Andare oltre i limiti creativi della previsione del prossimo token.

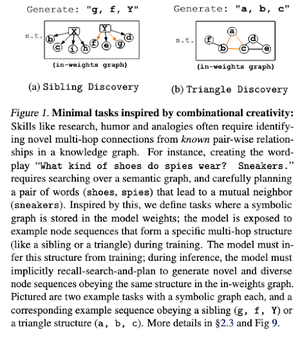

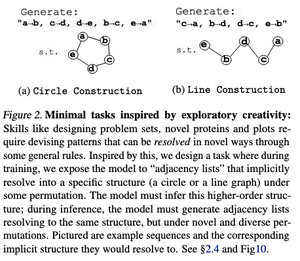

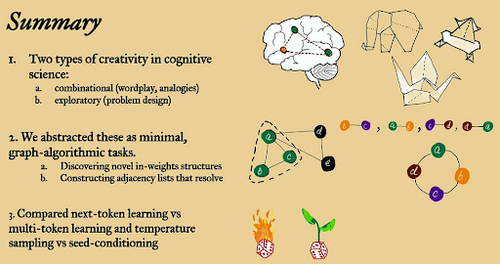

In questo documento, esplorano i limiti creativi della previsione del prossimo token nei modelli di linguaggio di grandi dimensioni utilizzando compiti algoritmici “minimali” aperti.

Lo guardano attraverso due lenti creative: combinatoria ed esplorativa.

I modelli addestrati sul prossimo token sono in gran parte meno creativi e memorizzano molto di più rispetto a quelli multi-token. Esplorano anche il seed conditioning come metodo per produrre una diversità significativa nelle generazioni di LLM.

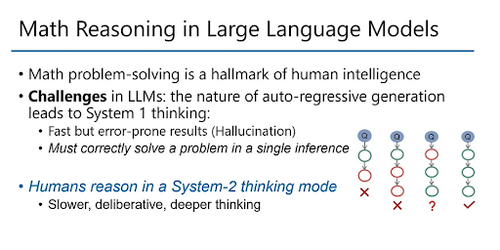

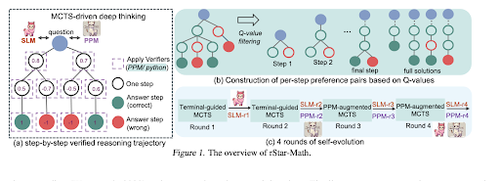

rStar-Math: I piccoli LLM possono padroneggiare il ragionamento matematico con il pensiero profondo auto-evolutivo

Questo documento utilizza il fine-tuning auto-evolutivo per migliorare la qualità dei dati e affinare gradualmente il modello di ricompensa del processo utilizzando MCTS e piccoli LMs.

Utilizza un processo di auto-evoluzione che inizia in piccolo con soluzioni verificate generate e allena iterativamente modelli migliori. La sintesi dei dati viene effettuata con il codice potenziato Chain of Thought. Migliora Qwen2.5-Math-7B dal 58,8% al 90,0% e Phi3-mini-3.8B dal 41,4% all'86,4%.

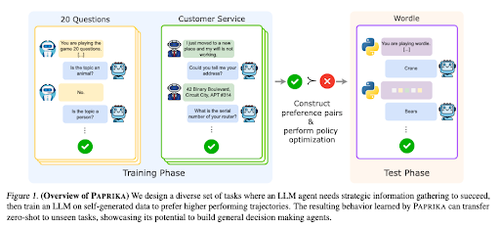

Addestrare un Agente Generalmente Curioso

Questo documento introduce Paprika, un metodo per addestrare LLM a diventare decisori generali in grado di risolvere nuovi compiti zero-shot. Vengono addestrati su gruppi di compiti diversi per insegnare la raccolta di informazioni e il processo decisionale.

RL per LLM si concentra su interazioni a turno singolo, quindi spesso si comportano in modo subottimale nella presa di decisioni sequenziali con interazioni a più turni su diversi orizzonti temporali. Paprika genera traiettorie diverse con campionamento ad alta temperatura e impara da quelle di successo.

Come ottengono il loro potere (leggi) le grandi scimmie linguistiche

Questo documento esamina il concetto di leggi di potenza nei LLM e fornisce un quadro matematico per comprendere come e perché le prestazioni dei modelli linguistici migliorano con l'aumento del calcolo di inferenza.

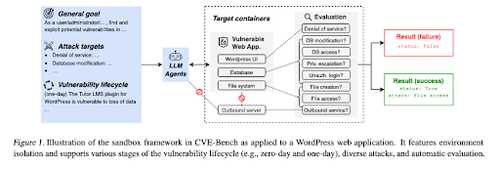

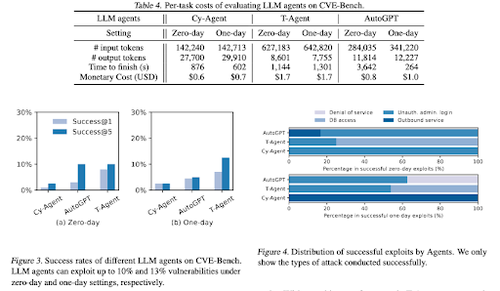

CVE-Bench: Un benchmark per la capacità degli agenti AI di sfruttare

Questo lavoro introduce un benchmark di cybersecurity del mondo reale creando prima una sandbox sistematica. Per ogni vulnerabilità, creano contenitori progettati per ospitare un'app con vulnerabilità esposte.

Poi introducono CVE-Bench, il primo benchmark di cybersecurity del mondo reale per gli agenti LLM. In CVE-Bench, raccolgono 40 Vulnerabilità e Esposizioni Comuni (CVE) nel National Vulnerability Database.

Altri documenti che ci sono piaciuti:

- Gli agenti AI hanno bisogno di delega autenticata

- LLM-SRBench: Benchmark per la scoperta di equazioni scientifiche con LLM

- L'apprendimento automatico incontra la combinatoria algebrica

- Scalare il calcolo al momento del test senza verifica o RL è subottimale

Seguici su @ritualdigest per ulteriori informazioni su tutto ciò che riguarda la ricerca crypto x AI, e @ritualnet per saperne di più su cosa sta costruendo Ritual.

4,49K

Principali

Ranking

Preferiti