Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Voici le Digest de Recherche Ritual de cette semaine, une newsletter couvrant les derniers travaux dans le monde des LLM et l'intersection de la vie privée, de l'IA et des protocoles décentralisés.

Cette semaine, nous vous présentons une édition ICML, couvrant certains des nombreux articles que nous avons appréciés lors de la conférence.

Lancez les dés et regardez avant de sauter : Aller au-delà des limites créatives de la prédiction du prochain jeton.

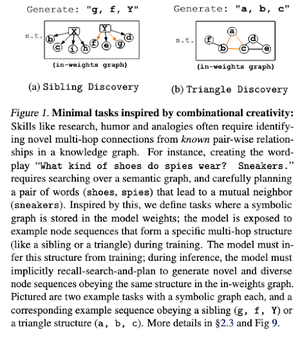

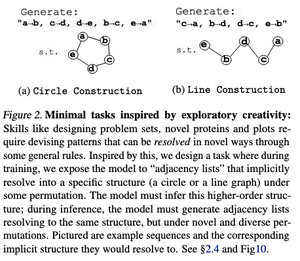

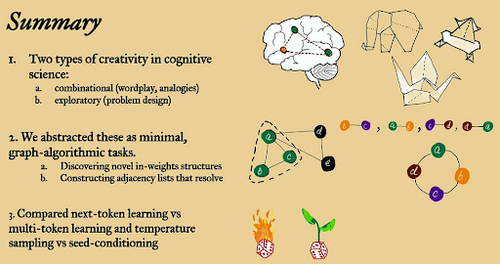

Dans cet article, ils explorent les limites créatives de la prédiction du prochain jeton dans les grands modèles de langage en utilisant des tâches algorithmiques « minimales » ouvertes.

Ils l'examinent à travers deux lentilles créatives : combinatoire et exploratoire.

Les modèles entraînés sur le prochain jeton sont largement moins créatifs et mémorisent beaucoup plus que ceux à plusieurs jetons. Ils explorent également le conditionnement de semences comme méthode pour produire une diversité significative dans les générations de LLM.

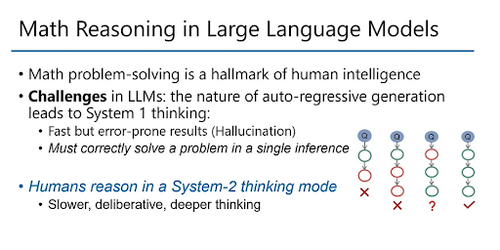

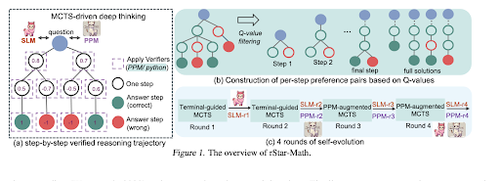

rStar-Math : Les petits LLM peuvent maîtriser le raisonnement mathématique grâce à une réflexion profonde auto-évolutive

Cet article utilise un ajustement fin auto-évolutif pour améliorer la qualité des données et affiner progressivement le modèle de récompense du processus en utilisant MCTS et de petits LMs.

Il utilise un processus d'auto-évolution qui commence petit avec des solutions vérifiées générées et entraîne itérativement de meilleurs modèles. La synthèse des données est réalisée avec un code augmenté de la Chaîne de Pensée. Cela améliore Qwen2.5-Math-7B de 58,8 % à 90,0 % et Phi3-mini-3.8B de 41,4 % à 86,4 %.

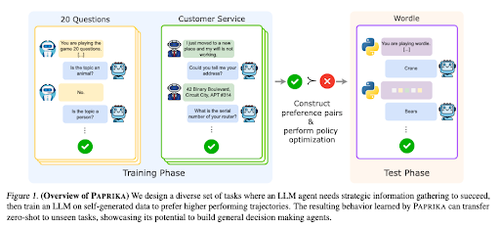

Former un agent généralement curieux

Cet article présente Paprika, une méthode pour former des LLM à devenir des décideurs généraux capables de résoudre de nouvelles tâches sans aucune préparation. Ils s'entraînent sur des groupes de tâches divers pour enseigner la collecte d'informations et la prise de décision.

L'apprentissage par renforcement (RL) pour les modèles de langage de grande taille (LLMs) se concentre sur des interactions à un seul tour, ce qui les amène souvent à performer de manière sous-optimale dans la prise de décision séquentielle avec des interactions à plusieurs tours sur différents horizons temporels. Paprika génère des trajectoires diverses avec un échantillonnage à haute température et apprend des trajectoires réussies.

Comment les grands singes linguistiques obtiennent-ils leur pouvoir (lois)

Cet article examine le concept de lois de puissance dans les LLM et fournit un cadre mathématique pour comprendre comment et pourquoi la performance des modèles linguistiques s'améliore avec l'augmentation des capacités de calcul d'inférence.

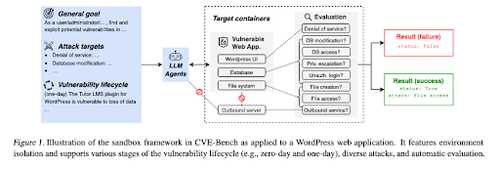

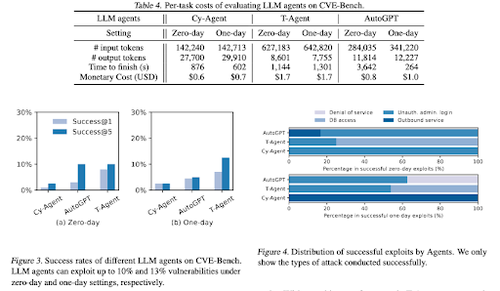

CVE-Bench : Un benchmark pour la capacité des agents IA à exploiter

Ce travail introduit un benchmark de cybersécurité du monde réel en créant d'abord un bac à sable systématique. Pour chaque vulnérabilité, ils créent des conteneurs conçus pour héberger une application avec des vulnérabilités exposées.

Ensuite, ils introduisent CVE-Bench, le premier véritable benchmark de cybersécurité pour les agents LLM. Dans CVE-Bench, ils collectent 40 Vulnérabilités et Expositions Communes (CVE) dans la Base de Données Nationale des Vulnérabilités.

D'autres articles que nous avons aimés :

- Les agents IA ont besoin de délégation authentifiée

- LLM-SRBench : Benchmark pour la découverte d'équations scientifiques avec des LLM

- L'apprentissage automatique rencontre la combinatoire algébrique

- L'augmentation de la puissance de calcul au moment du test sans vérification ni RL est sous-optimale

Suivez-nous @ritualdigest pour en savoir plus sur tout ce qui concerne la recherche crypto x IA, et @ritualnet pour en apprendre davantage sur ce que Ritual est en train de construire.

5,16K

Meilleurs

Classement

Favoris