Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Berikut adalah Ritual Research Digest minggu ini, buletin yang mencakup pekerjaan terbaru di dunia LLM dan persimpangan privasi, AI, dan protokol terdesentralisasi.

Minggu ini, kami menyajikan edisi ICML, yang mencakup beberapa dari banyak makalah yang kami sukai di konferensi tersebut.

Lempar dadu & lihat sebelum Anda melompat: Melampaui batas kreatif prediksi token berikutnya.

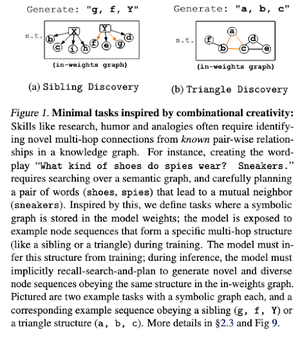

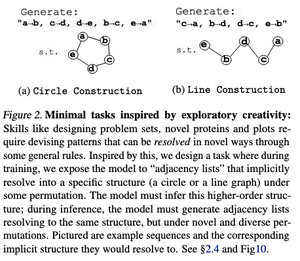

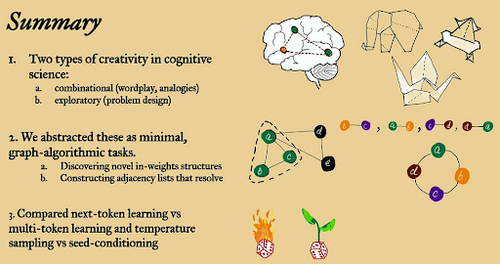

Dalam makalah ini, mereka mengeksplorasi batas kreatif prediksi token berikutnya dalam model bahasa besar menggunakan tugas algoritmik grafik terbuka "minimal".

Mereka melihatnya melalui dua lensa kreatif: kombinasi dan eksplorasi.

Model yang dilatih token berikutnya sebagian besar kurang kreatif & menghafal lebih banyak daripada model multi-token. Mereka juga mengeksplorasi pengkondisian benih sebagai metode untuk menghasilkan keragaman yang bermakna pada generasi LLM.

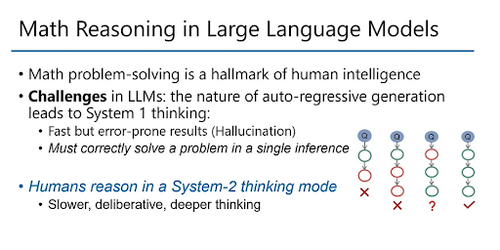

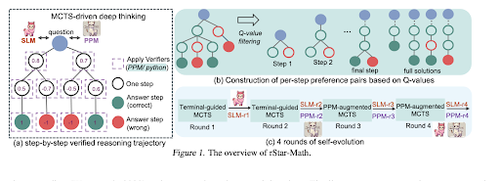

rStar-Math: LLM Kecil Dapat Menguasai Penalaran Matematika dengan Pemikiran Mendalam yang Berkembang Sendiri

Makalah ini menggunakan penyempurnaan yang berkembang sendiri untuk meningkatkan kualitas data dan secara bertahap menyempurnakan model penghargaan proses menggunakan MCTS dan LM kecil.

Ini menggunakan proses evolusi diri yang dimulai dari yang kecil dengan solusi terverifikasi yang dihasilkan dan secara berulang melatih model yang lebih baik. Sintesis data dilakukan dengan Rantai Pemikiran yang ditambah kode. Ini meningkatkan Qwen2.5-Math-7B dari 58.8% menjadi 90.0% dan Phi3-mini-3.8B dari 41.4% menjadi 86.4%.

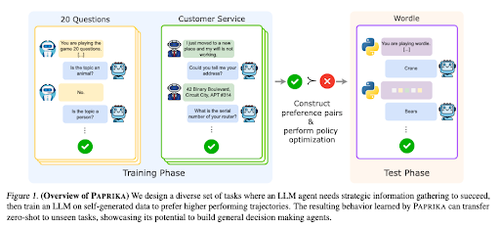

Melatih Agen yang Umumnya Ingin Tahu

Makalah ini memperkenalkan Paprika, metode untuk melatih LLM untuk menjadi pembuat keputusan umum yang dapat menyelesaikan tugas baru tanpa tembakan. Mereka melatih kelompok tugas yang beragam untuk mengajarkan pengumpulan informasi dan pengambilan keputusan.

RL untuk LLM berfokus pada interaksi satu putaran, sehingga mereka sering bekerja secara sub-optimal pada pengambilan keputusan berurutan dengan interaksi beberapa putaran selama cakrawala waktu yang berbeda. Paprika menghasilkan lintasan yang beragam dengan pengambilan sampel suhu tinggi dan belajar dari yang berhasil.

Bagaimana Monyet Bahasa Besar Mendapatkan Kekuatannya (Hukum)

Makalah ini mengkaji konsep hukum daya dalam LLM dan memberikan kerangka matematika untuk memahami bagaimana dan mengapa kinerja model bahasa meningkat dengan peningkatan komputasi inferensi.

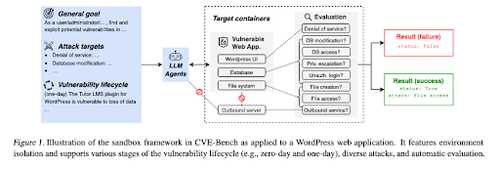

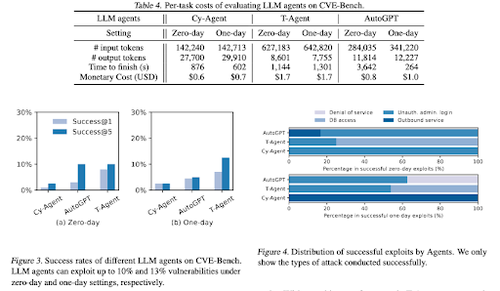

CVE-Bench: Tolok Ukur untuk Kemampuan Agen AI untuk Mengeksploitasi

Pekerjaan ini memperkenalkan tolok ukur keamanan siber dunia nyata dengan terlebih dahulu membuat kotak pasir sistematis. Untuk setiap kerentanan, mereka membuat penampung yang dirancang untuk menghosting aplikasi dengan kerentanan yang terbuka.

Kemudian mereka memperkenalkan CVE-Bench, tolok ukur keamanan siber dunia nyata pertama untuk agen LLM. Di CVE-Bench, mereka mengumpulkan 40 Kerentanan dan Eksposur Umum (CVE) di Database Kerentanan Nasional.

Beberapa makalah lain yang kami sukai:

- Agen AI Membutuhkan Delegasi Terautentikasi

- LLM-SRBench: Tolok Ukur untuk Penemuan Persamaan Ilmiah dengan LLM

- Pembelajaran Mesin bertemu dengan Kombinatorika Aljabar

- Penskalaan Komputasi Waktu Pengujian Tanpa Verifikasi atau RL Suboptimal

Ikuti kami @ritualdigest untuk informasi lebih lanjut tentang semua hal tentang penelitian crypto x AI, dan @ritualnet untuk mempelajari lebih lanjut tentang apa yang sedang dibangun Ritual.

4,9K

Teratas

Peringkat

Favorit