トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

今週の Ritual Research Digest は、LLM の世界の最新研究と、プライバシー、AI、分散型プロトコルの交差点を取り上げたニュースレターです。

今週は、会議で気に入った多くの論文のいくつかを取り上げたICML版を紹介します。

サイコロを振って、飛び込む前に見てください:次のトークン予測の創造的な限界を超えます。

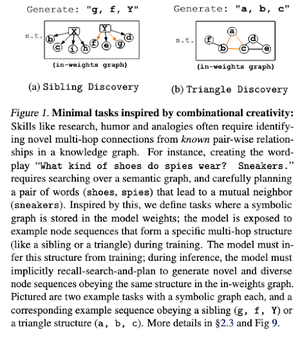

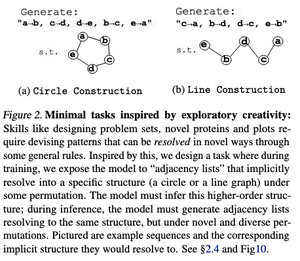

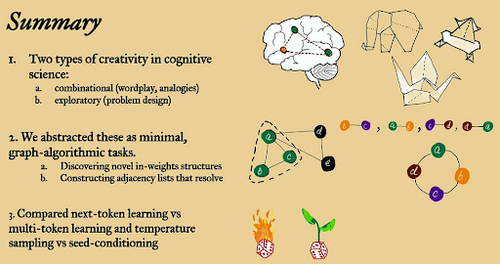

この論文では、「最小限の」オープンエンドグラフアルゴリズムタスクを使用して、大規模言語モデルにおけるネクストトークン予測の創造的な限界を探ります。

彼らは、組み合わせと探索という 2 つの創造的なレンズを通してそれを見ています。

ネクストトークントレーニングモデルは、マルチトークンモデルよりも創造性が低く、はるかに多くを記憶します。彼らはまた、LLM 世代に有意義な多様性を生み出す方法としてシード条件付けを研究しています。

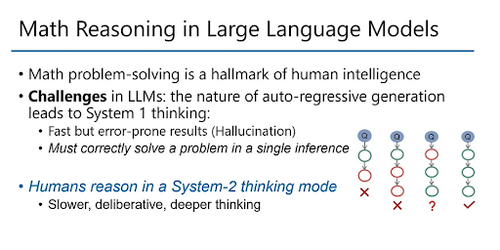

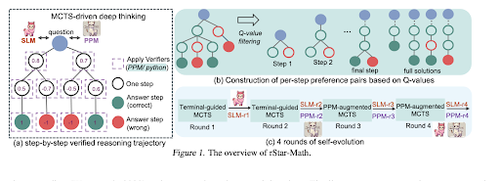

rStar-Math: 小規模な LLM は、自己進化した深い思考で数学の推論を習得できます

本論文では、自己進化型微調整を採用してデータ品質を向上させ、MCTSと小型LMを用いたプロセス報酬モデルを徐々に改良する。

生成された検証済みソリューションから小規模に開始し、より優れたモデルを反復的にトレーニングする自己進化プロセスを使用します。データ合成は、コード拡張された Chain of Thought を使用して行われます。Qwen2.5-Math-7B を 58.8% から 90.0% に、Phi3-mini-3.8B を 41.4% から 86.4% に改善します。

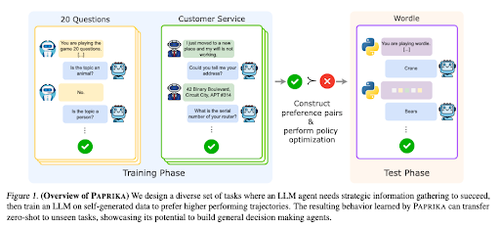

一般的に好奇心旺盛なエージェントのトレーニング

本稿では、LLMを育成し、新しいタスクをゼロショットで解決できる一般的な意思決定者に育成する方法であるPaprikaについて紹介します。彼らは、情報収集と意思決定を教えるために、多様なタスクグループでトレーニングを行います。

LLM の RL は 1 ターンの相互作用に焦点を当てているため、異なる期間にわたる複数ターンの相互作用による連続的な意思決定では最適とは言えないことがよくあります。パプリカは高温サンプリングで多様な軌道を生成し、成功した軌道から学びます。

大型言語サルはどのようにして力を得るのか(法則)

このホワイトペーパーでは、LLM におけるべき乗則の概念を検討し、推論計算の増加によって言語モデルのパフォーマンスがどのように、そしてなぜ向上するかを理解するための数学的フレームワークを提供します。

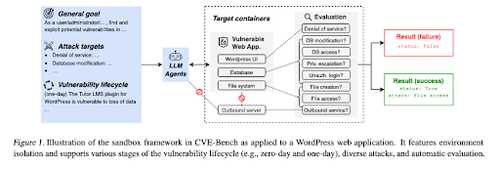

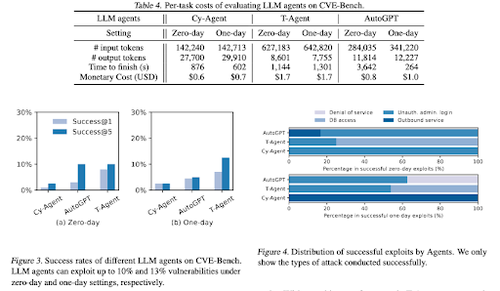

CVE-Bench: AI エージェントの悪用能力のベンチマーク

この作業では、最初に体系的なサンドボックスを作成することにより、実際のサイバーセキュリティベンチマークを導入します。脆弱性ごとに、脆弱性が公開されているアプリをホストするように設計されたコンテナを作成します。

次に、LLM エージェント向けの最初の現実世界のサイバーセキュリティ ベンチマークである CVE-Bench を導入します。CVE-Benchでは、National Vulnerability Databaseに40のCommon Vulnerabilities and Exposures(CVE)を収集します。

私たちが気に入った他のいくつかの論文:

- AI エージェントには認証された委任が必要です

- LLM-SRBench: LLM による科学方程式発見のベンチマーク

- 機械学習と代数的組み合わせ論の出会い

- 検証または RL なしでテスト時コンピューティングをスケーリングすることは最適ではありません

私たちをフォローしてください @ritualdigest 暗号通貨 x AI 研究に関するすべての詳細と、@ritualnet Ritualが構築しているものについて詳しく学びましょう。

5.15K

トップ

ランキング

お気に入り