熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

這是本週的 Ritual Research Digest,這是一份涵蓋 LLM 世界及隱私、人工智慧和去中心化協議交集的最新研究的通訊。

本週,我們呈現 ICML 版本,涵蓋了我們在會議上喜歡的一些論文。

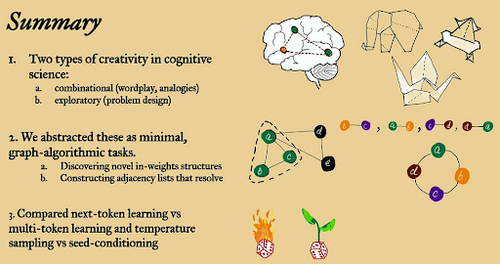

擲骰子並在跳躍前先看看:超越下一個標記預測的創意極限。

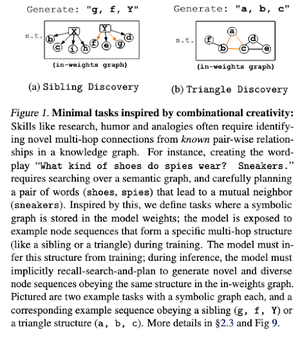

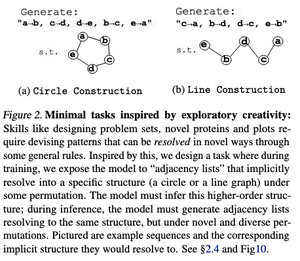

在這篇論文中,他們探討了大型語言模型中下一個標記預測的創意極限,使用了「最小」的開放式圖形算法任務。

他們通過兩種創意視角來看待它:組合性和探索性。

下一個標記訓練的模型在創造力上大多較低,並且比多標記模型記憶更多。它們還探索種子條件作為在大型語言模型生成中產生有意義多樣性的一種方法。

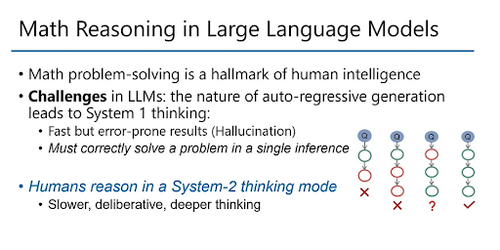

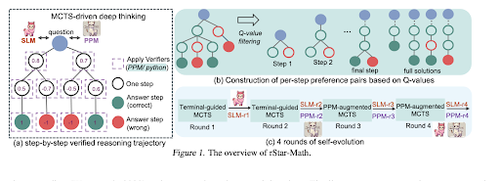

rStar-Math:小型 LLM 可以通過自我演化的深度思考掌握數學推理

本文利用自我演化的微調來提高數據質量,並使用 MCTS 和小型 LMs 逐步完善過程獎勵模型。

它使用自我演化過程,從生成的驗證解決方案開始,逐步訓練更好的模型。數據合成是通過增強的思維鏈代碼完成的。它將 Qwen2.5-Math-7B 的準確率從 58.8% 提高到 90.0%,將 Phi3-mini-3.8B 的準確率從 41.4% 提高到 86.4%。

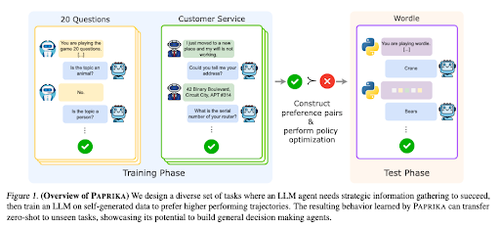

訓練一個普遍好奇的代理人

本文介紹了Paprika,一種訓練大型語言模型(LLMs)成為通用決策者的方法,能夠零樣本解決新任務。他們在多樣的任務組上進行訓練,以教導信息收集和決策能力。

RL for LLMs 專注於單回合互動,因此它們在不同時間範圍內的多回合互動的序列決策上表現通常不佳。Paprika 通過高溫取樣生成多樣的軌跡,並從成功的軌跡中學習。

大型語言模型如何獲得其能力(法則)

本文探討了大型語言模型中的能力法則概念,並提供了一個數學框架,以理解語言模型性能如何以及為何隨著推理計算的增加而改善。

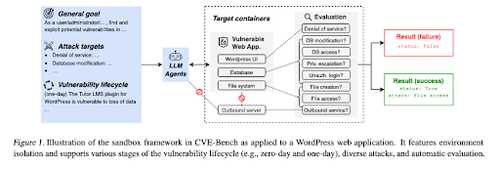

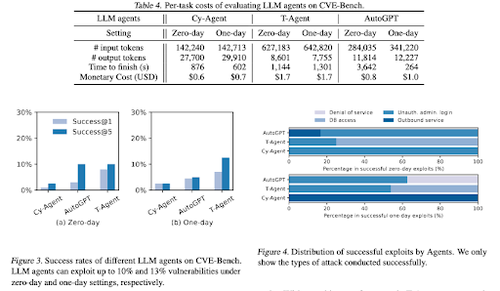

CVE-Bench:AI代理利用能力的基準測試

這項工作通過首先創建一個系統化的沙盒,介紹了一個現實世界的網絡安全基準。對於每個漏洞,他們創建了設計用於承載具有暴露漏洞的應用程序的容器。

然後他們介紹了 CVE-Bench,這是針對 LLM 代理的第一個現實世界的網絡安全基準。在 CVE-Bench 中,他們收集了國家漏洞數據庫中的 40 個常見漏洞和暴露 (CVE)。

我們喜歡的其他一些論文:

- AI 代理需要經過身份驗證的委託

- LLM-SRBench:用於科學方程發現的基準測試

- 機器學習與代數組合學相遇

- 在沒有驗證或強化學習的情況下擴展測試時間計算是次優的

關注我們 @ritualdigest 獲取更多有關加密貨幣與人工智慧研究的資訊,並且 @ritualnet 了解 Ritual 正在構建的內容。

4.92K

熱門

排行

收藏