热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

这是本周的仪式研究摘要,涵盖了LLM领域以及隐私、人工智能和去中心化协议交汇处的最新工作。

本周,我们呈现了ICML特别版,涵盖了我们在会议上喜欢的一些论文。

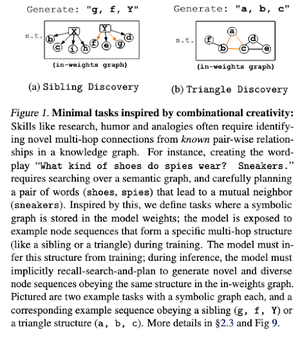

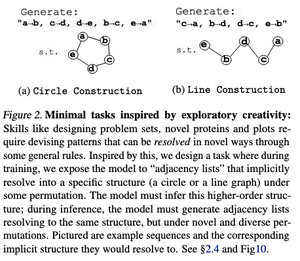

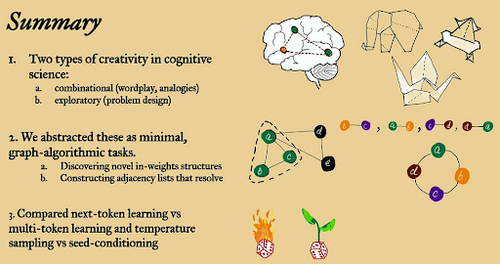

掷骰子,三思而后行:超越下一个标记预测的创造性极限。

在本文中,他们探讨了在大型语言模型中使用“最小”开放式图算法任务的下一个标记预测的创造性极限。

他们通过两种创造性的视角来看待它:组合性和探索性。

下一个令牌训练的模型在创造性上大大不如多令牌模型,并且记忆的内容也更多。它们还探索种子条件作为在大型语言模型生成中产生有意义多样性的一种方法。

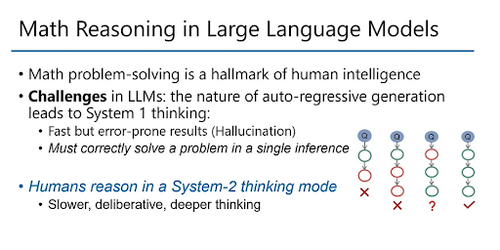

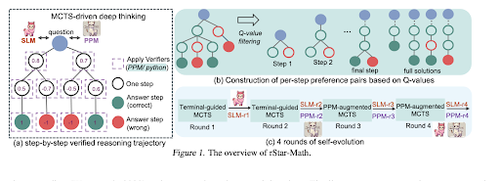

rStar-Math:小型LLM可以通过自我进化的深度思考掌握数学推理

本文采用自我进化微调来提高数据质量,并使用MCTS和小型LM逐步完善过程奖励模型。

它使用自我进化过程,从生成的验证解决方案开始,逐步训练更好的模型。数据合成是通过代码增强的思维链完成的。它将Qwen2.5-Math-7B的准确率从58.8%提高到90.0%,将Phi3-mini-3.8B的准确率从41.4%提高到86.4%。

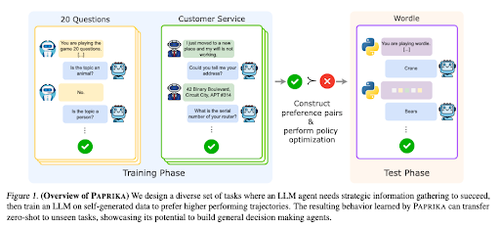

训练一个普遍好奇的智能体

本文介绍了Paprika,这是一种训练大型语言模型(LLMs)成为通用决策者的方法,能够零-shot解决新任务。他们在多样化的任务组上进行训练,以教授信息收集和决策能力。

RL(强化学习)针对LLMs(大型语言模型)专注于单轮交互,因此在不同时间范围内的多轮交互的顺序决策中,它们的表现往往不尽如人意。Paprika通过高温采样生成多样化的轨迹,并从成功的轨迹中学习。

大型语言模型如何获得它们的能力(幂律)

本文探讨了大型语言模型中的幂律概念,并提供了一个数学框架,以理解语言模型性能如何以及为何随着推理计算的增加而提高。

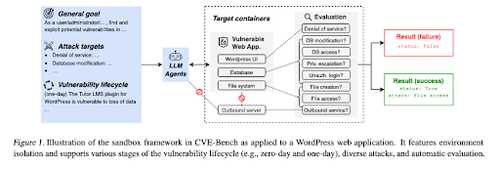

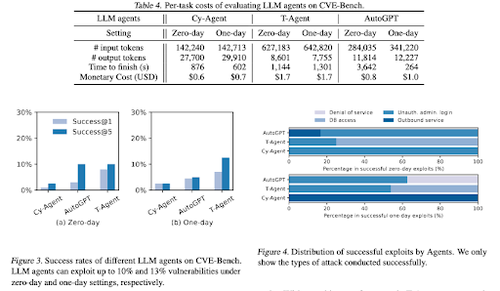

CVE-Bench:AI代理利用能力的基准测试

这项工作通过首先创建一个系统化的沙箱,引入了一个现实世界的网络安全基准。对于每个漏洞,他们创建了旨在托管具有暴露漏洞的应用程序的容器。

然后他们推出了CVE-Bench,这是第一个针对LLM代理的真实世界网络安全基准。在CVE-Bench中,他们收集了国家漏洞数据库中的40个常见漏洞和暴露(CVE)。

我们喜欢的一些其他论文:

- AI代理需要经过认证的委托

- LLM-SRBench:使用LLM进行科学方程发现的基准

- 机器学习与代数组合学相遇

- 在没有验证或强化学习的情况下扩展测试时间计算是次优的

关注我们 @ritualdigest,获取更多关于加密货币与人工智能研究的内容,另外关注 @ritualnet,了解 Ritual 正在构建的内容。

4.49K

热门

排行

收藏