Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Seth Ginns

Mitra Pengelola @coinfund_io. Mantan Investor Ekuitas di Jennison Associates; IBD di Credit Suisse

Pendapat pribadi. Bukan saran investasi

Konvergensi mempercepat

@HyperliquidX DAT mengumumkan ini dipimpin oleh Atlas Merchant Capital (Bob Diamond, CEO Fmr, Barclays) dengan partisipasi D1 Capital (Dan Sundheim, Fmr, CIO Viking). Presiden Fed Fmr Boston Eric Rosengren diperkirakan akan bergabung dengan dewan

Seth Ginns13 Jul, 19.19

Ya, perusahaan treasury harus diperdagangkan dengan premi terhadap NAB

Apa?

🧵

10,39K

Seth Ginns memposting ulang

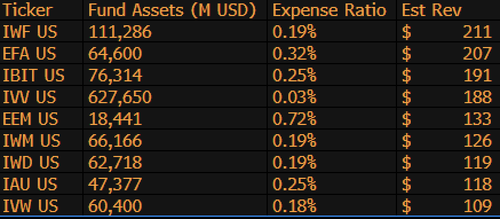

$IBIT sekarang menjadi ETF penghasil pendapatan tertinggi ke-3 untuk BlackRock dari 1.197 dana, dan hanya berjarak $9 miliar dari menjadi #1. Hanya statistik gila lainnya untuk ETF berusia 1,5 tahun (secara harfiah bayi). Berikut daftar 10 Teratas untuk BLK (selain itu, bagaimana dengan $IWF yang terlupakan di posisi teratas, siapa yang tahu?)

107,98K

Seth Ginns memposting ulang

Stablecoin akan secara drastis mengubah cara lembaga keuangan mendekati kripto, dan Kepala Investasi Likuid CoinFund @sethginns baru-baru ini bergabung dengan @thebenkeadyshow untuk berbicara tentang keyakinannya dalam jumlah kasus ⬇️ penggunaan mereka yang terus meningkat

845

Pemungutan suara pada RUU stablecoin Senat hari ini pukul 16:30 ET

Senate Cloakroom17 Jun 2025

Pada pukul 16:30, Senat diperkirakan akan melanjutkan ke dua pemungutan suara tentang hal-hal berikut:

1. (Jika penutupan diminta) Konfirmasi Kalender Eksekutif #98 Olivia Trusty untuk menjadi Anggota Komisi Komunikasi Federal selama sisa masa jabatan yang berakhir pada 30 Juni 2025.

2. Pengesahan Cal. #66, S.1582, Undang-Undang GENIUS, sebagaimana telah diubah.

746

Seth Ginns memposting ulang

Hasil onchain tetap di luar jangkauan kebanyakan orang. Meskipun tidak memiliki izin, kompleksitasnya membuat banyak orang enggan berpartisipasi.

Melalui kemitraan erat kami dengan @Veda_labs, kompleksitas Plasma ini akan diabstraksi untuk membawa hasil yang berkelanjutan bagi massa.

33,71K

Seth Ginns memposting ulang

Prediksi cepat.

2025: Model parameter 100B+ dilatih pada d-network.

2026: Model 50B+ *multi-modal* pertama dilatih pada GPU sukarelawan.

2027-8: Semua yang lain sama, model kompetitif padat GPT-3 175B direproduksi.

2030+: Lari terdesentralisasi "perbatasan" sejati, param 1T+.

3,66K

Seth Ginns memposting ulang

Pemikiran/prediksi dalam pelatihan AI terdesentralisasi, 2025.

1. Satu hal yang perlu dikatakan adalah kita pasti berada di dunia yang berbeda dengan pelatihan AI terdesentralisasi daripada 18 bulan yang lalu. Saat itu, pelatihan terdesentralisasi tidak mungkin dan sekarang sudah ada di pasar dan menjadi lapangan.

2. Jangan salah, tujuan akhir dari d-training adalah untuk melatih model perbatasan yang kompetitif di d-network. Dengan demikian, kami baru berada di awal perjalanan kompetitif kami, tetapi kami bergerak cepat.

3. Sekarang menjadi konsensus bahwa kita dapat melatih dan melatih model multi-miliar parameter (sebagian besar LLM, sebagian besar arsitektur transformator) pada d-network. Keadaan seni saat ini hingga ~100B, ujung atasnya sudah terlihat tetapi belum ditampilkan.

4. Sekarang sudah menjadi konsensus bahwa kita dapat melatih model parameter <10B pada d-network dengan cukup layak. Ada juga studi kasus spesifik (terutama dari @gensynai @PrimeIntellect @NousResearch) di mana parameter 10B, 32B, 40B telah atau sedang dilatih. Kawanan pasca-pelatihan @gensynai beroperasi pada model parameter hingga 72B.

5. Inovasi @PluralisHQ sekarang telah membatalkan "kemustahilan" pra-pelatihan yang dapat diskalakan pada d-network dengan menghilangkan kemacetan inefisiensi komunikasi. Namun, FLOP mentah, keandalan, dan verifikasibilitas tetap menjadi hambatan untuk jenis jaringan ini - masalah yang sangat dapat dipecahkan tetapi akan membutuhkan waktu untuk diselesaikan secara teknis. Dengan Protocol Learning dari Pluralis seperti yang ada, saya pikir kita mencapai model ~100B pada jangka waktu 6-12 bulan.

6. Bagaimana kita mendapatkan dari model parameter 100B hingga 300B? Saya pikir kita perlu menemukan cara untuk memisahkan parameter secara efektif dan lancar dan menjaga memori perangkat individu relatif rendah (misalnya memori <32GB per perangkat). Saya pikir kita perlu mencapai 20 EFlops dalam jaringan; itu berarti sesuatu seperti 10-20K perangkat konsumen yang berjalan selama 4-6 minggu dalam pelatihan.

Secara keseluruhan, d-training siap menjadi ruang yang sangat menarik. Beberapa inovasinya sudah dipertimbangkan untuk aplikasi AI yang luas.

4,14K

Teratas

Peringkat

Favorit

Trending onchain

Trending di X

Pendanaan teratas terbaru

Paling terkenal