Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Seth Ginns

Managing Partner @coinfund_io. Ex investitore azionario presso Jennison Associates; IBD presso Credit Suisse

Opinioni personali. Non è un consiglio di investimento

Convergenza in accelerazione

@HyperliquidX DAT ha annunciato questa mattina guidata da Atlas Merchant Capital (Bob Diamond ex CEO di Barclays) con la partecipazione di D1 Capital (Dan Sundheim ex CIO di Viking). L'ex presidente della Fed di Boston Eric Rosengren dovrebbe unirsi al consiglio.

Seth Ginns13 lug, 19:19

Sì, le società di tesoreria dovrebbero scambiare a un premio rispetto al NAV

Cosa?

🧵

10,39K

Seth Ginns ha ripubblicato

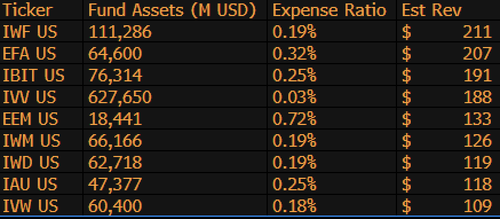

$IBIT è ora il terzo ETF con il maggior fatturato per BlackRock su 1.197 fondi, ed è solo a $9 miliardi dal diventare #1. Un'altra statistica pazzesca per un ETF di 1,5 anni (letteralmente un neonato). Ecco la lista dei primi 10 per BLK (a proposito, che dire del dimenticabile $IWF al primo posto, chi lo sapeva?)

107,99K

Seth Ginns ha ripubblicato

Le stablecoin cambieranno drasticamente il modo in cui le istituzioni finanziarie si approcciano alle criptovalute, e il responsabile degli investimenti liquidi di CoinFund @sethginns è recentemente intervenuto nel @thebenkeadyshow per parlare della sua convinzione nel crescente numero di casi d'uso ⬇️

845

Vota oggi sul progetto di legge sui stablecoin al Senato alle 16:30 ET

Senate Cloakroom17 giu 2025

Alle 16:30, si prevede che il Senato proceda a due votazioni per appello nominale sui seguenti punti:

1. (Se viene invocata la chiusura) Conferma del Calendario Esecutivo #98 Olivia Trusty come Membro della Federal Communications Commission per il resto del mandato che scade il 30 giugno 2025.

2. Approvazione del Cal. #66, S.1582, GENIUS Act, come emendato.

747

Seth Ginns ha ripubblicato

I rendimenti onchain rimangono fuori portata per la maggior parte delle persone. Nonostante siano senza permessi, la loro complessità scoraggia molti dal partecipare.

Grazie alla nostra stretta collaborazione con @Veda_labs, queste complessità su Plasma saranno semplificate per portare rendimenti sostenibili alle masse.

33,71K

Seth Ginns ha ripubblicato

Previsioni rapide.

2025: modello con oltre 100 miliardi di parametri addestrato su d-reti.

2026: Primo modello *multi-modale* con oltre 50 miliardi addestrato su GPU volontarie.

2027-8: Tutto il resto uguale, modello competitivo denso GPT-3 175B riprodotto.

2030+: Una vera corsa decentralizzata "frontier", oltre 1 trilione di parametri.

3,66K

Seth Ginns ha ripubblicato

Pensieri/previsioni sul training AI decentralizzato, 2025.

1. Una cosa da dire è che siamo sicuramente in un mondo diverso con il training AI decentralizzato rispetto a 18 mesi fa. All'epoca, il training decentralizzato era impossibile e ora è sul mercato ed è un campo.

2. Non fraintendete, l'obiettivo finale del d-training è addestrare modelli competitivi e all'avanguardia su reti decentralizzate. Pertanto, siamo solo all'inizio del nostro viaggio competitivo, ma stiamo procedendo rapidamente.

3. Ora c'è consenso sul fatto che possiamo pre-addestrare e post-addestrare modelli con miliardi di parametri (per lo più LLM, per lo più architetture transformer) su reti decentralizzate. Lo stato dell'arte attuale è fino a ~100B, la parte alta è in vista ma non è stata mostrata.

4. Ora c'è consenso sul fatto che possiamo addestrare modelli con meno di 10B parametri su reti decentralizzate in modo abbastanza fattibile. Ci sono stati anche casi studio specifici (principalmente da @gensynai @PrimeIntellect @NousResearch) in cui sono stati o stanno venendo addestrati modelli con 10B, 32B, 40B parametri. Il sistema di post-training di @gensynai opera su modelli fino a 72B parametri.

5. L'innovazione di @PluralisHQ ha ora invalidato l'"impossibilità" del pre-training scalabile su reti decentralizzate rimuovendo il collo di bottiglia dell'inefficienza comunicativa. Tuttavia, le FLOPs grezze, l'affidabilità e la verificabilità rimangono colli di bottiglia per questi tipi di reti -- problemi che sono molto risolvibili ma richiederanno del tempo per essere risolti tecnicamente. Con il Protocol Learning di Pluralis così com'è, penso che arriveremo a modelli di ~100B in un arco di tempo di 6-12 mesi.

6. Come possiamo passare da modelli di 100B a 300B parametri? Penso che dobbiamo trovare modi per frammentare i parametri in modo efficace e fluido e mantenere la memoria dei singoli dispositivi relativamente bassa (ad es. <32GB di memoria per dispositivo). Penso che dobbiamo arrivare a 20 EFlops in una rete; ciò significa qualcosa come 10-20K dispositivi consumer in funzione per 4-6 settimane durante un training.

In generale, il d-training è pronto per essere uno spazio molto entusiasmante. Alcune delle sue innovazioni sono già considerate per ampie applicazioni AI.

4,14K

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari