Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Seth Ginns

Administrerende partner @coinfund_io. tidligere aksjeinvestor hos Jennison Associates; IBD hos Credit Suisse

Personlige meninger. Ikke investeringsråd

Konvergensen akselererer

@HyperliquidX DAT kunngjorde dette ledet av Atlas Merchant Capital (Bob Diamond FMR, administrerende direktør Barclays) med D1 Capital-deltakelse (Dan Sundheim, FMR, CIO, Viking). Fmr Boston Fed-president Eric Rosengren forventes å bli med i styret

Seth Ginns13. juli, 19:19

Ja, finansselskaper bør handle til en premie til NAV

Hva?

🧵

10,37K

Seth Ginns lagt ut på nytt

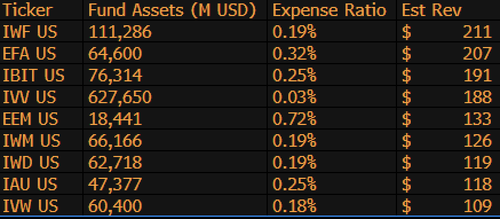

$IBIT er nå den 3rd høyeste inntektsgenererende ETFen for BlackRock av 1,197 fond, og er bare $9b unna å være #1. Bare nok en vanvittig statistikk for en 1,5 år gammel (bokstavelig talt et spedbarn) ETF. Her er topp 10-liste for BLK (bortsett fra, hva med den forglemmelige $IWF på topplasseringen, hvem visste det?)

107,98K

Avstemning om Senatets stablecoin-lovforslag i dag kl. 16:30 ET

Senate Cloakroom17. juni 2025

Klokken 16.30 forventes Senatet å gå videre til to avstemninger ved navneopprop om følgende:

1. (Hvis cloture påberopes) Bekreftelse av Executive Calendar #98 Olivia Trusty til å være medlem av Federal Communications Commission for resten av perioden som utløper 30.

2. Vedtak av Cal. #66, S.1582, GENIUS Act, som endret.

722

Seth Ginns lagt ut på nytt

Onchain-avlinger er fortsatt utenfor rekkevidde for de fleste. Til tross for at de er tillatelsesløse, fraråder kompleksiteten mange å delta.

Gjennom vårt nære partnerskap med @Veda_labs vil disse kompleksitetene på Plasma bli abstrahert bort for å bringe bærekraftig utbytte til massene.

33,7K

Seth Ginns lagt ut på nytt

Tanker/spådommer i desentralisert AI-opplæring, 2025.

1. En ting å si er at vi definitivt er i en annen verden med desentralisert AI-opplæring enn vi var for 18 måneder siden. Den gang var desentralisert opplæring umulig, og nå er det i markedet og er et felt.

2. Gjør ingen feil, sluttmålet med d-trening er å trene konkurransedyktige, grensemodeller på d-nettverk. Som sådan er vi bare i starten av vår konkurransereise, men vi beveger oss raskt.

3. Det er nå konsensus om at vi kan forhåndstrene og ettertrene multi-milliarder parametermodeller (for det meste LLM-er, for det meste transformatorarkitekturer) på d-nettverk. Den nåværende teknologien er opptil ~100B, hvis øvre ende er i sikte, men ikke har blitt vist.

4. Det er nå konsensus om at vi kan trene <10B-parametermodeller på d-nettverk ganske mulig. Det har også vært spesifikke casestudier (primært fra @gensynai @PrimeIntellect @NousResearch) der 10B, 32B, 40B parametere har blitt eller blir trent. @gensynai sverm etter trening opererer på opptil 72B parametermodeller.

5. Den @PluralisHQ innovasjonen har nå ugyldiggjort "umuligheten" av skalerbar forhåndsopplæring på d-nettverk ved å fjerne flaskehalsen for kommunikasjonsineffektivitet. Imidlertid er rå FLOP-er, pålitelighet og verifiserbarhet fortsatt flaskehalser for denne typen nettverk - problemer som er svært løselige, men som vil ta litt tid å løse teknisk. Med Protocol Learning from Pluralis slik det står, tror jeg vi kommer til ~100B modeller på 6-12 måneders tidsramme.

6. Hvordan kommer vi fra 100B til 300B parametermodeller? Jeg tror vi må finne måter å effektivt og flytende fragmentere parametere og holde individuelt enhetsminne relativt lavt (f.eks. <32 GB minne per enhet). Jeg tror vi må komme til 20 EFlops i et nettverk; det betyr noe sånt som 10-20K forbrukerenheter som kjører i 4-6 uker på en trening.

Totalt sett er d-trening klar til å bli et veldig spennende rom. Noen av innovasjonene vurderes allerede for brede AI-applikasjoner.

4,14K

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til