Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

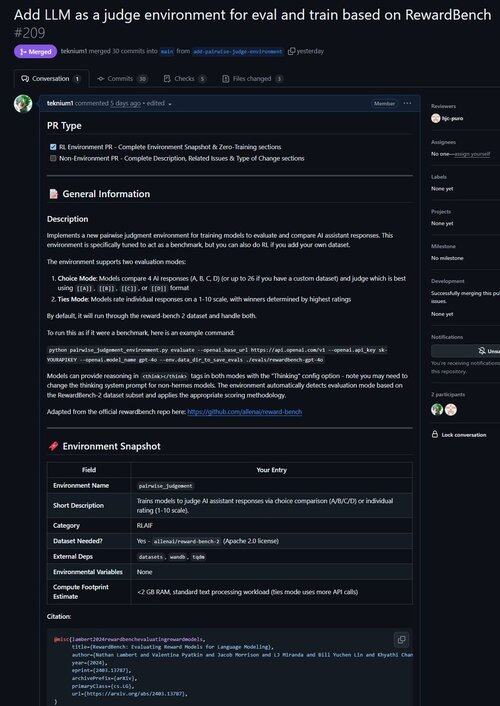

Только что объединил PR для среды, чтобы улучшить LLM в качестве Судьи, а также оценить модели по их способности делать суждения!

Знали ли вы, что все проверяемые RL-среды почти эквивалентны бенчмаркам (и наоборот!)? Поэтому мы добавили команду evaluate в базу Atropos, и теперь вы можете запускать бенчмарки через среды Atropos.

Мы были разочарованы работой с таким количеством устаревших или непригодных бенчмарк-фреймворков, поэтому мы реализовали режим только для оценки в Atropos, нашем фреймворке RL-сред.

Таким образом, нашим первым портом из внешних сред стал Reward-Bench от @natolambert!

Примечание: в данный момент он поддерживает только генеративные модели вознаграждений (обычные LLM Судьи).

Посмотрите PR здесь:

20,54K

Топ

Рейтинг

Избранное