Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

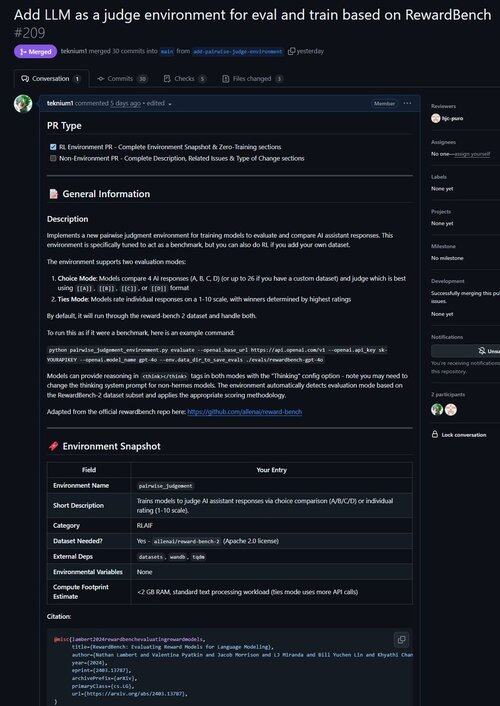

Acabámos de fundir um PR para um ambiente que melhora o LLM como Juiz, bem como avalia modelos na sua capacidade de fazer julgamentos!

Sabia que todos os ambientes RL verificáveis são quase equivalentes a benchmarks (e vice-versa!)? Por isso, adicionámos um comando de avaliação à base do Atropos e agora pode executar benchmarks através dos ambientes do Atropos.

Ficámos frustrados por trabalhar com tantos frameworks de benchmark que estavam desatualizados ou inutilizáveis, por isso implementámos um modo apenas de avaliação no Atropos, o nosso framework de ambientes RL.

Assim, o nosso primeiro porto a partir dos nossos ambientes existentes foi o Reward-Bench do @natolambert!

Nota: neste momento, apenas suporta modelos de recompensa generativa (Juízes LLM regulares).

Veja o PR aqui:

20,54K

Top

Classificação

Favoritos