Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

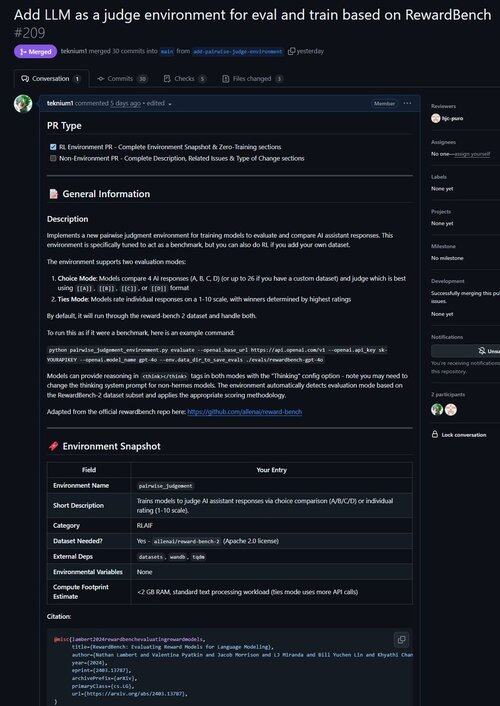

Ik heb zojuist een PR samengevoegd voor een omgeving om LLM te verbeteren als rechter en om modellen te evalueren op hun vermogen om oordelen te vellen!

Wist je dat alle verifieerbare RL-omgevingen bijna gelijkwaardig zijn aan benchmarks (en vice versa!)? Dus we hebben een evalueercommando toegevoegd aan de basis van Atropos en nu kun je benchmarks uitvoeren via Atropos-omgevingen.

We raakten gefrustreerd door het werken met zoveel verouderde of onbruikbare benchmarkframeworks, dus hebben we een evaluatiemodus zonder evaluatie geïmplementeerd in Atropos, ons RL-omgevingenframework.

Dus onze eerste poort van buiten onze bestaande omgevingen was @natolambert's Reward-Bench!

Opmerking: het ondersteunt op dit moment alleen generatieve beloningsmodellen (gewone LLM-rechters).

Bekijk de PR hier:

20,54K

Boven

Positie

Favorieten