Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

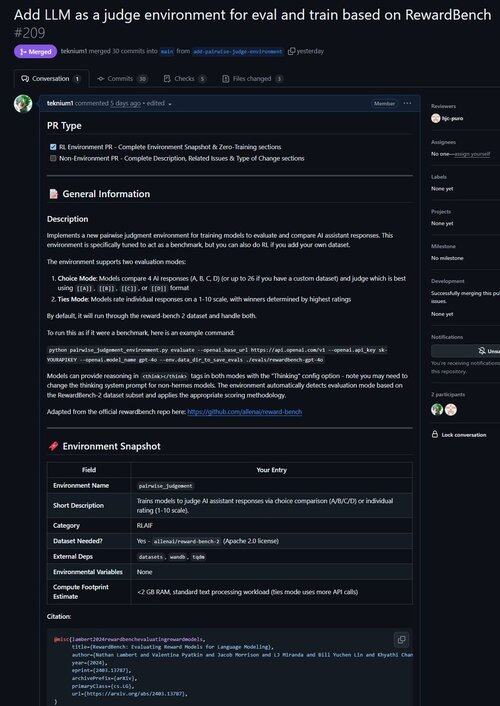

Właśnie połączyłem PR dla środowiska, aby poprawić LLM jako Sędziego oraz oceniać modele pod kątem ich zdolności do wydawania wyroków!

Czy wiesz, że wszystkie weryfikowalne środowiska RL są niemal równoważne benchmarkom (i odwrotnie!)? Dlatego dodaliśmy polecenie oceny do podstawy Atropos i teraz możesz uruchamiać benchmarki przez środowiska Atropos.

Byliśmy sfrustrowani pracą z tak wieloma przestarzałymi lub nieużywalnymi frameworkami benchmarkowymi, więc wdrożyliśmy tryb tylko do oceny w Atropos, naszym frameworku środowisk RL.

Naszym pierwszym portem z zewnątrz naszych istniejących środowisk był Reward-Bench @natolambert!

Uwaga: obecnie obsługuje tylko generatywne modele nagród (zwykli Sędziowie LLM).

Sprawdź PR tutaj:

20,54K

Najlepsze

Ranking

Ulubione