Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

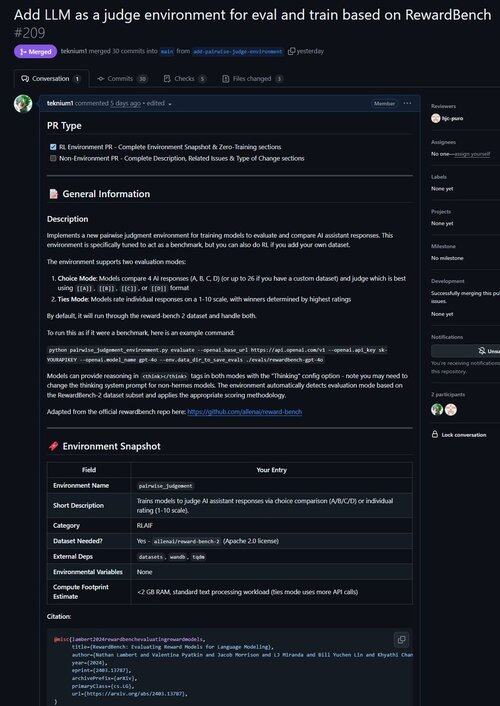

Právě jsem sloučil PR pro prostředí pro zlepšení LLM jako soudce a také hodnocení modelů na jejich schopnosti dělat úsudky!

Věděli jste, že všechna ověřitelná prostředí RL jsou téměř ekvivalentní benchmarkům (a naopak!)? Proto jsme do základu Atroposu přidali příkaz evaluate a nyní můžete spouštět benchmarky v prostředích Atropos.

Byli jsme frustrovaní z práce s tolika benchmarkovými frameworky, které byly zastaralé nebo nepoužitelné, a tak jsme implementovali režim pouze pro vyhodnocení do Atroposu, našeho frameworku RL prostředí.

Takže náš první port mimo naše stávající prostředí byl @natolambert's Reward-Bench!

Poznámka: v současné době podporuje pouze modely generativních odměn (běžné porotce LLM).

Podívejte se na PR zde:

20,53K

Top

Hodnocení

Oblíbené