Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

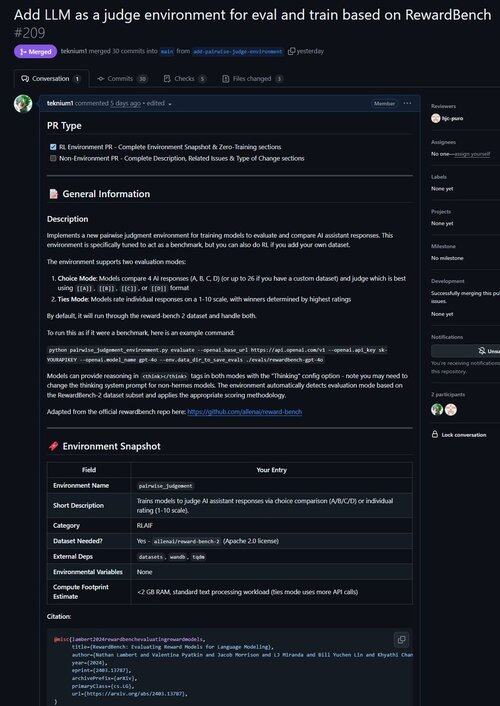

Acabei de fundir um PR para um ambiente para melhorar o LLM como juiz, bem como avaliar os modelos em sua capacidade de fazer julgamentos!

Você sabia que todos os ambientes de RL verificáveis são quase equivalentes a benchmarks (e vice-versa!)? Por isso, adicionamos um comando evaluate à base do Átropos e agora você pode executar benchmarks em ambientes Átropos.

Ficamos frustrados em trabalhar com tantos frameworks de benchmark que estavam desatualizados ou inutilizáveis, então implementamos o modo somente avaliação no Atropos, nosso framework de ambientes RL.

Portanto, nossa primeira porta de fora de nossos ambientes existentes foi o Banco de Recompensas do @natolambert!

Nota: ele suporta apenas modelos de recompensa generativa (LLM Judges regulares) no momento.

Confira o PR aqui:

20,55K

Melhores

Classificação

Favoritos