Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

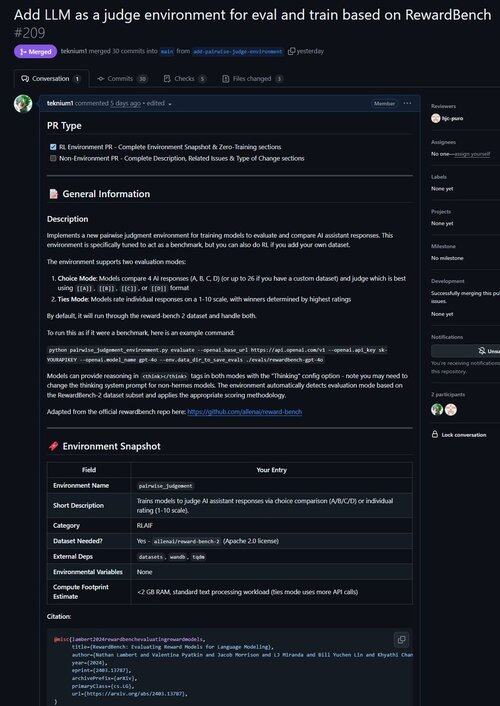

Abbiamo appena fuso una PR per un ambiente per migliorare LLM come Giudice e valutare i modelli sulla loro capacità di fare giudizi!

Sapevi che tutti gli ambienti RL verificabili sono quasi equivalenti ai benchmark (e viceversa!)? Quindi abbiamo aggiunto un comando di valutazione alla base di Atropos e ora puoi eseguire benchmark attraverso gli ambienti di Atropos.

Ci siamo frustrati nel lavorare con così tanti framework di benchmark che erano obsoleti o inutilizzabili, quindi abbiamo implementato una modalità di sola valutazione in Atropos, il nostro framework per ambienti RL.

Quindi il nostro primo porting da ambienti esterni è stato il Reward-Bench di @natolambert!

Nota: al momento supporta solo modelli di ricompensa generativa (Giudici LLM regolari).

Dai un'occhiata alla PR qui:

20,53K

Principali

Ranking

Preferiti