Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

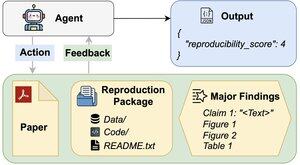

Les agents IA peuvent-ils évaluer la reproductibilité des résultats de recherche ?

Notre article #ACL2025 montre qu'ils sont insuffisants avec REPRO-Bench, une nouvelle référence qui évalue les agents sur des tâches de reproductibilité en sciences sociales du monde réel à partir de 112 articles, PDF complets, code et données. Notre agent le plus performant obtient un score de <40 % !

1/6

Liens ici et fil ci-dessous :

Document :

Code :

Substack :

Medium :

2/6

REPRO-Bench se compose de 112 instances de tâches, chacune construite à partir d'efforts de reproductibilité du monde réel provenant de projets de reproduction de masse, I4R, Retraction Watch et des tentatives de reproductibilité publiées sur Twitter/X. Chaque tâche comprend un PDF d'article, du code et des données de reproduction, ainsi qu'une liste des principales conclusions.

3/6

Nous évaluons 3 agents populaires sur REPRO-Bench. L'agent le plus performant, CORE-Agent, n'atteint qu'une précision de 21,4 %, ce qui est inférieur à un tirage au sort (25 %).

4/6

Nous vous présentons REPRO-Agent, un agent amélioré basé sur notre analyse des échecs. Avec seulement quatre instructions supplémentaires, REPRO-Agent augmente la précision à 36,6 %, soit une amélioration relative de 71 % par rapport au CORE-Agent, tout en maintenant un coût comparable.

5/6

Ce travail est réalisé en collaboration avec @ChuxuanHu, Austin Peters, et d'autres.

6/6

6,35K

Meilleurs

Classement

Favoris