熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

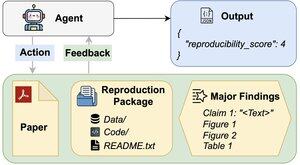

AI 代理能否評估研究結果的可重複性?

我們的 #ACL2025 論文顯示,使用 REPRO-Bench 的 AI 代理在現實社會科學可重複性任務中表現不佳,該基準評估了 112 篇論文的完整 PDF、代碼和數據。我們表現最好的代理得分不到 40%!

1/6

這裡的連結和下面的主題:

文件:

代碼:

Substack:

Medium:

2/6

REPRO-Bench 由 112 個任務實例組成,每個實例都來自於來自大規模重現項目、I4R、撤回監視和在 Twitter/X 上發布的重現嘗試的真實世界重現努力。每個任務都包括一篇論文 PDF、重現代碼和數據,以及主要發現的列表。

3/6

我們在 REPRO-Bench 上評估了 3 個受歡迎的代理。表現最佳的代理 CORE-Agent 只有 21.4% 的準確率,這低於隨機猜測的 25%。

4/6

我們介紹 REPRO-Agent,這是一個基於我們失敗分析的改進代理。僅需四條額外指令,REPRO-Agent 的準確率提升至 36.6%,相較於 CORE-Agent 提升了 71% 的相對改善,同時保持了可比的成本。

5/6

這項工作是與 @ChuxuanHu、Austin Peters 和其他人共同完成的。

6/6

6K

熱門

排行

收藏