Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

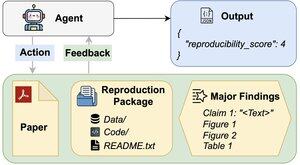

Могут ли агенты ИИ оценивать воспроизводимость результатов исследований?

Наша статья #ACL2025 показывает, что они не справляются с REPRO-Bench, новым эталоном, который оценивает агентов по задачам воспроизводимости в реальном мире в области социальных наук на основе 112 статей, полных PDF-файлов, кода и данных. Наш агент с наилучшей производительностью набирает <40%!

1/6

Ссылки здесь и тема ниже:

Документ:

Код:

Substack:

Medium:

2/6

REPRO-Bench состоит из 112 экземпляров задач, каждая из которых основана на реальных усилиях по воспроизводимости, полученных из проектов массового воспроизведения, I4R, Retraction Watch и попыток воспроизводимости, опубликованных в Twitter/X. Каждая задача включает PDF статьи, код и данные воспроизведения, а также список основных выводов.

3/6

Мы оцениваем 3 популярных агента на REPRO-Bench. Лучший агент, CORE-Agent, достигает всего 21,4% точности, что ниже, чем случайное угадывание (25%).

4/6

Мы представляем REPRO-Agent, улучшенный агент, основанный на нашем анализе неудач. С помощью всего четырех дополнительных инструкций REPRO-Agent повышает точность до 36,6%, что является относительным улучшением на 71% по сравнению с CORE-Agent, при этом сохраняя сопоставимые затраты.

5/6

Эта работа выполнена совместно с @ChuxuanHu, Остином Питерсом и другими.

6/6

6,01K

Топ

Рейтинг

Избранное