Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

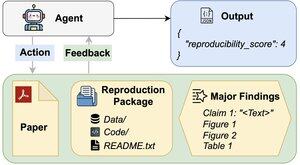

Чи можуть агенти штучного інтелекту оцінити відтворюваність результатів досліджень?

Наш #ACL2025 документ показує, що вони не дотягують до REPRO-Bench, нового еталону, який оцінює агентів у реальних завданнях відтворюваності соціальних наук, що складаються зі 112 статей, повних PDF-файлів, коду та даних. Наші найвищі оцінки агентів <40%!

1/6

Посилання тут і гілка нижче:

Папір:

Код:

Підстек:

Середнє:

2/6

REPRO-Bench складається зі 112 екземплярів завдань, кожен з яких створений на основі реальних зусиль щодо відтворення, отриманих від проектів масового відтворення, I4R, Retraction Watch та спроб відтворення, опублікованих у Twitter/X. Кожне завдання містить паперовий PDF-файл, код відтворення та дані, а також список основних висновків.

3/6

Оцінюємо 3 популярних агента на REPRO-Bench. Найефективніший агент, CORE-Agent, досягає точності лише 21,4%, що нижче, ніж при випадковому вгадуванні (25%).

4/6

Ми представляємо REPRO-Agent, вдосконалений агент, заснований на нашому аналізі відмов. Завдяки лише чотирьом додатковим інструкціям REPRO-Agent підвищує точність до 36,6%, що на 71% є відносним покращенням у порівнянні з CORE-Agent, зберігаючи при цьому порівнянну вартість.

5/6

Ця робота є спільною з @ChuxuanHu, Остіном Пітерсом та іншими.

6/6

6,01K

Найкращі

Рейтинг

Вибране