Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Gli agenti AI possono valutare la riproducibilità dei risultati della ricerca?

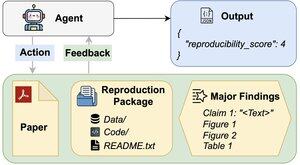

Il nostro articolo per #ACL2025 mostra che non ci riescono con REPRO-Bench, un nuovo benchmark che valuta gli agenti su compiti di riproducibilità delle scienze sociali nel mondo reale, basati su 112 articoli, PDF completi, codice e dati. Il nostro agente con le migliori prestazioni ottiene meno del 40%!

1/6

Link qui e thread sotto:

Carta:

Codice:

Substack:

Medium:

2/6

REPRO-Bench è composto da 112 istanze di task, ciascuna costruita da sforzi di riproducibilità del mondo reale provenienti da progetti di riproduzione di massa, I4R, Retraction Watch e tentativi di riproducibilità pubblicati su Twitter/X. Ogni task include un PDF del documento, codice e dati di riproduzione, e un elenco delle principali scoperte.

3/6

Valutiamo 3 agenti popolari su REPRO-Bench. L'agente con le migliori prestazioni, CORE-Agent, raggiunge solo il 21,4% di accuratezza, che è inferiore al semplice caso (25%).

4/6

Introduciamo REPRO-Agent, un agente migliorato basato sulla nostra analisi dei fallimenti. Con solo quattro istruzioni aggiuntive, REPRO-Agent aumenta l'accuratezza al 36,6%, un miglioramento relativo del 71% rispetto al CORE-Agent, mantenendo costi comparabili.

5/6

Questo lavoro è stato realizzato con @ChuxuanHu, Austin Peters e altri.

6/6

6K

Principali

Ranking

Preferiti